Clase 13

Diunggah oleh

Alvaro Arenas OviedoHak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

Clase 13

Diunggah oleh

Alvaro Arenas OviedoHak Cipta:

Format Tersedia

El Perceptrn

1958 - El psiclogo Frank Ronsenblant desarroll un modelo

simple de neurona basado en el modelo de McCulloch y Pitts que

utilizaba una regla de aprendizaje basada en la correccin del error:

Perceptrn

x

1

x

2

x

3

y

w

1

w

2

w

3

< + + +

+ + +

= =

... si 1

... si 1

) ,..., , (

2 2 1

2 2 1

2 1

1

1

n n

n n

n

x w x w x w

x w x w x w

x x x f y

Funcin paso o De Heaviside Funcin signo

= +

2 2 1 1

x w x w

> +

2 2 1 1

x w x w

< +

2 2 1 1

x w x w

Qu se pretende con el Perceptrn?

Se dispone de la siguiente informacin:

L Conjunto de patrones {x

k

}, k = 1,2,,p

1

, de la clase C

1

(z

k

= 1)

L Conjunto de patrones {x

r

}, k = p

1

+1,...,p , de la clase C

2

(z

r

= -1)

Se pretende que el perceptrn asigne a cada entrada (patrn x

k

) la

salida deseada z

k

siguiendo un proceso de correccin de error

(aprendizaje) para determinar los pesos sinpticos apropiados

Regla de aprendizaje del Perceptrn:

( ) ( ) ( ) | | ( ) k x k y k z k k w

j j

= ) (

= =

=

= = +

= +

1 ) ( y 1 ) ( si ) ( 2 ) (

) ( ) ( si ) (

, 1 ) ( y 1 ) ( si ) ( 2 ) (

) 1 (

k z k y k x k w

k z k y k w

k z k y k x k w

k w

j j

j

j j

j

error

tasa de

aprendizaje

Cmo se modifica el sesgo ?

+ + +

n n

x w x w x w ...

2 2 1 1

0 ...

1 1 2 2 1 1

+ + + +

+ + n n n n

x w x w x w x w

1

x

1

x

2

x

3

y

1

w

1

w

2

w

3

0 ) 1 ( ...

2 2 1 1

+ + + +

n n

x w x w x w

( ) ( ) ( ) | | k y k z k k = ) (

Algoritmo del Perceptrn

Paso 0: Inicializacin

Inicializar los pesos sinpticos con nmeros aleatorios del intervalo [-1,1].

Ir al paso 1 con k=1

Paso 1: (k-sima iteracin)

Calcular

Paso 2: Correccin de los pesos sinpticos

Si z(k) y(k) modificar los pesos sinpticos segn la expresin:

Paso 3: Parada

Si no se han modificado los pesos en las ltimas p iteraciones, es decir,

parar. La red se ha estabilizado.

En otro caso, ir al Paso 1 con k=k+1.

|

|

.

|

\

|

=

+

=

1

1

) ( sgn ) (

n

j

j j

k x w k y

( ) ( ) ( ) ( ) | | ( ) 1 ,..., 2 , 1 , 1 + = + = + n j k x k y k z k w k w

j i i j j

p k k r n j k w r w

j j

+ + = + = = ,..., 1 , 1 ,..., 2 , 1 ), ( ) (

El perceptron con Bolsillo

Consiste en tener en cuenta el nmero de iteraciones consecutivas del

algoritmo de perceptrn en las cuales no se ha modificado el vector de

pesos sinpticos (para cada uno de los vectores que va generando), es

decir, tener en cuenta el nmero de patrones que se han clasificado

correctamente con dicho vector hasta que se ha encontrado el primer

patrn que clasifica incorrectamente. Se tiene guardado en el bolsillo la

mejor solucin explorada, es decir, el vector de pesos sinpticos

generado que ha conseguido, hasta el momento, el mayor nmero de

iteraciones sin ser modificado. Cuando se encuentra un nuevo vector de

pesos sinpticos que consigue un mayor nmero de clasificaciones

correctas consecutivas que el que hay en el bolsillo entonces el vector

del bolsillo se reemplaza por este. La solucin final viene dada por el

vector de pesos sinpticos guardado en el bolsillo.

Algoritmo

del

Perceptrn

con

bolsillo

La ADALINA

La ADALINA (tambin llamada ADALINE), pues corresponde al acrnimo

de ADAptive Linear NEuron) o neurona con adaptacin lineal que fue

introducida por Widrow en 1959. Esta neurona es similar al Perceptrn

simple pero utiliza como funcin de transferencia la funcin identidad en

lugar de la funcin signo. La salida de la ADALINA es simplemente una

funcin lineal de las entradas (ponderadas con los pesos sinpticos):

=

=

N

j

j j

x w y

1

+

=

=

1

1

N

j

j j

x w y

{ }

p 2 1

x x x ,..., ,

{ }

p 2 1

z z z ,..., ,

( ) ( )

=

+

= =

|

|

.

|

\

|

= =

p

k

N

j

k

j j

k

p

k

k

x k w z k y z E

1

2

1

1 1

2

) (

2

1

2

1

La ADALINA

( ) ( )

=

+

= =

|

|

.

|

\

|

= =

p

k

N

j

k

j j

k

p

k

k

x k w z k y z E

1

2

1

1 1

2

) (

2

1

2

1

) ( ) ( ) 1 ( k w k w k w

r r r

+ = +

) (

) (

k w

E

k w

r

r

=

| |

k

r

k

x k y z ) ( =

Aprendizaje individualizado:

La ADALINA

) ( ) ( ) 1 ( k w k w k w

r r r

+ = +

) (

) (

k w

E

k w

r

r

=

( ) ( )

=

+

= =

|

|

.

|

\

|

= =

p

k

N

j

k

j j

k

p

k

k

x w z

p

k y z

p

E

1

2

1

1 1

2

2

1

2

1

| |

=

=

p

k

k

j

k

x k y z

p

1

) (

1

Aprendizaje por lotes:

Adalina

Para tratar problemas de clasificacin suele ponerse una funcin signo al

final de la salida continua. Sin embargo todos los clculos del proceso

de entrenamiento se realizan con la salida continua.

Neuronas con salida continua:

Regla de aprendizaje de Widrow-Hoff

Regla delta regla LMS (least mean square)

|

|

.

|

\

|

=

=

N

j

j j

x w g y

1

( )

( ) x

x g

2 exp 1

1

+

( ) ( )

x x

x x

e

e e

x x g

e

tanh

= =

x

1

x

2

x

3

y

w

1

w

2

w

3

Neuronas con salida continua:

Regla de aprendizaje de Widrow-Hoff

en linea

( ) ( )

=

+

= =

|

|

.

|

\

|

= =

p

k

N

j

k

j j

k

p

k

k

x k w g z k y z E

1

2

1

1 1

2

) ) ( (

2

1

2

1

) (

) (

k w

E

k w

j

j

=

| | ( )

k

j

k

x h g k y z ' ) ( =

Descenso por el gradiente

( )

( ) x

x g

2 exp 1

1

+

( ) ( )

x x

x x

e

e e

x x g

e

tanh

= =

Calcular g(x) para estos dos casos

( )

( ) x

x g

2 exp 1

1

+

( ) ( )

x x

x x

e

e e

x x g

e

tanh

= =

g(x)= 2 B g(x) (1-g(x))

g(x)= B [1 g

2

(x)]

Neuronas con salida continua:

Regla de aprendizaje de Widrow-Hoff

por lotes (batch)

( ) ( )

=

+

= =

|

|

.

|

\

|

= =

p

k

N

j

k

j j

k

p

k

k

x w g z

p

k y z

p

E

1

2

1

1 1

2

) (

2

1

2

1

j

j

w

E

w

=

| |

=

=

p

k

k

j

k

x h g k y z

p

1

) ( ' ) (

1

Ventajas de aprendizaje en lnea o por lotes:

En-linea: Menor computacin, cierta aleatoriedad ayuda a escapar de mnimos,

No requiere datos estticos

Por lotes(Batch): es simple y determinista (repetible).

Convergencia: similar pero puede depender del algoritmo en cuestin.

converge

cte. pequea

Descenso

gradiente

Continua Widrow-

Hoff (LMS)

converge

cte. pequea

Descenso

gradiente

Continua

y/o( +1;-1)

Adaline

LS:OK

NLS: OK

Correccin

errores +

memoria

bipolar

(+1;-1)

Perceptrn

+

Bolsillo

LS: OK

NLS: oscila

Correccin

errores

bipolar

(+1;-1)

Perceptrn

Convergencia Aprendizaje Salida Regla

Anda mungkin juga menyukai

- Mi Primer Proyecto de Emprendimiento (Parte 5) : A-B-C-DDokumen5 halamanMi Primer Proyecto de Emprendimiento (Parte 5) : A-B-C-DEnrique YamBelum ada peringkat

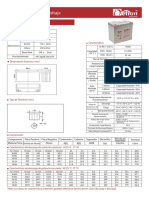

- Batería Gel 150AHDokumen2 halamanBatería Gel 150AHsantiago navarroBelum ada peringkat

- Urgencias PsiquiatricasDokumen37 halamanUrgencias PsiquiatricasIlse JuradoBelum ada peringkat

- TA1 - JhulisaCelis-LLC PDFDokumen7 halamanTA1 - JhulisaCelis-LLC PDFIrma Carvajal SimónBelum ada peringkat

- 4 Detalles y Detallado Del Acero de Refuerzo Del Concreto ACI-315-1Dokumen126 halaman4 Detalles y Detallado Del Acero de Refuerzo Del Concreto ACI-315-1Wilber Mac Alvi100% (1)

- Malla Curricular Ing Industrial PUCP-PerúDokumen2 halamanMalla Curricular Ing Industrial PUCP-PerúRichard LópezBelum ada peringkat

- PreguntasDokumen54 halamanPreguntasFatima MoreiraBelum ada peringkat

- Resumen Apéndice, La ÉticaDokumen8 halamanResumen Apéndice, La ÉticaSofy KeBelum ada peringkat

- Teoria de La Responsabilidad CivilDokumen121 halamanTeoria de La Responsabilidad CivilFRANK CARLOS BARRIONUEVO TERANBelum ada peringkat

- Convenio de Viena P - 173604860Dokumen22 halamanConvenio de Viena P - 173604860Naomi McMuffinBelum ada peringkat

- Sesion 2 Motivacion y Emocion UladechDokumen20 halamanSesion 2 Motivacion y Emocion UladechLuis EsbaBelum ada peringkat

- Cuota de Pantalla Obras de Cine - Analisis Comparado - Final - v3Dokumen9 halamanCuota de Pantalla Obras de Cine - Analisis Comparado - Final - v3Tripolina ZukBelum ada peringkat

- Proceso Constructivo de Un Sistema de AlcantarilladoDokumen20 halamanProceso Constructivo de Un Sistema de AlcantarilladoMarcelino Dzul UcanBelum ada peringkat

- Caracterización y Morfología de Gramíneas y LeguminosasDokumen14 halamanCaracterización y Morfología de Gramíneas y LeguminosasKike GarciaBelum ada peringkat

- Riaof Vol 3 N2 2020Dokumen90 halamanRiaof Vol 3 N2 2020Paqui CardonaBelum ada peringkat

- Fibra TECHDokumen16 halamanFibra TECHjcguevarapBelum ada peringkat

- RBD573 DIA LECTURA 2 A Resultados Asignatura Monitoreo Intermedio 2022 PDFDokumen9 halamanRBD573 DIA LECTURA 2 A Resultados Asignatura Monitoreo Intermedio 2022 PDFacyutaBelum ada peringkat

- 2.6.12 Microbiologial Examination of Non-Sterile Products 9.6 - EspDokumen10 halaman2.6.12 Microbiologial Examination of Non-Sterile Products 9.6 - EspSilvia PalaciosBelum ada peringkat

- 4 Integracion de Entidades Senales y Variables5Dokumen24 halaman4 Integracion de Entidades Senales y Variables5Camilo Andres RojasBelum ada peringkat

- Cuadro Comparativo Modelos PedagogicosDokumen3 halamanCuadro Comparativo Modelos PedagogicosDiana Aguilar100% (1)

- Manejo Seguro de Armas de FuegoDokumen20 halamanManejo Seguro de Armas de FuegoOlguita Lucia Remolina100% (1)

- CTA - U5 - 2do Grado - Sesion 04Dokumen4 halamanCTA - U5 - 2do Grado - Sesion 04Geovana Lucia Sulla LizarasoBelum ada peringkat

- El Privilegio de Los Dioses Por Encima de Los MortaleDokumen3 halamanEl Privilegio de Los Dioses Por Encima de Los MortaleYilder Ruiz SalinasBelum ada peringkat

- Módulo de Capacitación: Vigilancia de Indicadores NutricionalesDokumen181 halamanMódulo de Capacitación: Vigilancia de Indicadores NutricionalesMarilu HuaynachoBelum ada peringkat

- Dosificación Del Curso LGDokumen3 halamanDosificación Del Curso LGNORA SOCORRO GUTIERREZ DOMINGUEZBelum ada peringkat

- Leche y LácteosDokumen112 halamanLeche y LácteosMario Silva100% (7)

- Terapia FamiliarbDokumen22 halamanTerapia Familiarbjessica maximoBelum ada peringkat

- Https WWW - Mortal-Kombat - Org Guias Guia Mk1Dokumen3 halamanHttps WWW - Mortal-Kombat - Org Guias Guia Mk1Martin CatalánBelum ada peringkat

- Modelo Canvas LindaDokumen6 halamanModelo Canvas LindaDairon villalobos mercadoBelum ada peringkat

- La Auditoria InformaticaDokumen69 halamanLa Auditoria InformaticaJhon Alexander Robayo SuarezBelum ada peringkat