(Poster) Evaluation de La Précision Sur Un Système de Recherche D'information Hypertexte

Diunggah oleh

IDIR2002Judul Asli

Hak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

(Poster) Evaluation de La Précision Sur Un Système de Recherche D'information Hypertexte

Diunggah oleh

IDIR2002Hak Cipta:

Format Tersedia

Évaluation de la précision sur un système

de recherche d’information Hypertexte

Idir Chibane, Bich-Liên Doan

Département Informatique, Supélec

Plateau de Moulon, 3 rue Joliot Curie, 91 192 Gif/Yvette, France

{Idir.Chibane, Bich-Lien.Doan}@supelec.fr

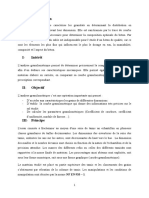

Système de Recherche d’Information

D2

Collection des documents

Q

Recherche

D1

α

Analyse lexicale

Besoins d’Information Indexation

Contexte

Représentation des documents et la requête

Différent mécanismes de Feedback

Représentation des Base des Représentation du

Suppression des mots vides

D = ( wt1, D , wt 2 , D ,..., wtn , D )

besoins d’information connaissances contenu des documents

Q = ( wt1,Q , wt 2 ,Q ,..., wtn ,Q )

Lemmatisation Pondération des termes

Requête Index et base de données tf (t ) D

W t , D = 0 . 5 + 0 . 5 * * log

Max (tf (t ))

des documents

Assignement des poids df ( t )

aux termes

Fonction de correspondance Fonction de correspondance

∑ wti ,D ⋅ wti ,Q

( )

SD D,Q =

D ⋅Q t ∈D ∩Q

= i

∑ wt2i ,D .∑ wt2i ,Q

2 2

Index D ⋅Q

t i ∈D ti

Documents retrouvés

Architecture d’un Système de Recherche d’Information Les étapes d’indexation Modèle vectoriel

La fonction de voisinage

T (Pi ) ∩ T (Q ) = 0

Méthodologie Démonstration

0

Nos expériences sont conduites selon les étapes suivantes : Pi Pj La mesure de voisinage

Étape 1. Liste initiale (l’ensemble du travail). C’est une liste de pages Web ∑[ ( )] ] Poids (Pj , Pi )∗ SD (Pi , Q )

VD (P j , Q ) =

Pi ∈ IN P j ∩ [ T ( Pi )∩ T (Q ) = k

n

répondant partiellement ou complètement à la requête posée par l’utilisateur. ∑

k =1 IN ( Pj )

Ces pages contiennent au moins un terme de la requête et elles sont classées

1 Avec Poids (Pj, Pi) la pondération du lien entre la page Pj et

selon un score calculé sur la base de TF-IDF. On notera SD le score de la ∗ β

page par rapport à la requête. C’est un score reposant sur le contenu seul de n Pi. Ce poids est défini comme suit

la page. Pi Pj

T (Pi )∩ T (Q ) = 1 Poids( p j , pi ) = ∗ β

k

Étape 2. Partition des pages. Une méthode de partition est appliquée pour n

Modèle

partitionner les pages retrouvées dans des ensembles. Chaque ensemble se

β un paramètre compris entre 0 et 1 qui vérifie la condition

compose des pages qui contiennent exactement k termes de la requête

[k=1...n(nombre total des termes de la requête]. L’Objectif de la partition est de suivante

n

k n

n! k n

(n − 1)! ∗ β

pondérer les liens entre les pages selon le nombre de termes de la requête

T (Pi ) ∩ T (Q ) = k ∑ Cnk ⋅ ⋅ β ⋅ = 1 ≡ ∑

n

∗ ∗β =1 ≡ ∑

k =1 k!∗(n − k )! n k =1 (k − 1)!∗(n − k )!

=1

contenus dans chaque page. k =1

k

∗ β

k

AvecCn est une combinaison de longueur k de l’ensemble T(Q)

Étape 3. Liste finale. La liste finale des pages Web classées selon une Pi n de cardinal n. Cette valeur représente le nombre de sous-

combinaison d’un score du contenu de la page et de son voisinage est Pj

construite à partir des pages qui contiennent tous les termes de la requête. ensembles différents de pages qui contiennent exactement k

termes de la requête.

S ( P , Q ) = α ∗ SD (P , Q ) + (1 − α ) ∗ SV (P , Q )

i i i

Nous avons par récurrence

Avec :

- α un paramètre compris entre 0 et 1. Il nous permet de voir l'impact de notre n

(n − 1)! 1

fonction de voisinage sur celle reposant sur le contenue seul de la page. T (Pi ) ∩ T (Q ) = n

∑ (k − 1)!∗(n − k )! = 2

k =1

n −1

d ' où β=

2 n −1

- SV(Pi,Q) le score de voisinage de la page Pi reposant sur la propagation des

scores des pages du voisinage de Pi à travers les liens. β Après la transformation de la première fonction en remplaçant

- SD(Pi,Q) le score associé à la page Pi reposant sur le contenu textuel de Pi Pj β par sa valeur, nous obtiendrons la fonction finale suivante

cette page par rapport à la requête.

VD (P j , Q ) =

n

SD (Pi )

1

n ∗ 2 n −1 * IN ( Pj )

∑ k ∗ ∑[

k =1

( )]

Pi ∈ IN P j ∩ [ T ( Pi )∩ T ( Q ) = k ]

Les étapes de la recherche Les différentes configuration de pondération des liens Mesure de voisinage

Expérimentations et analyse des résultats

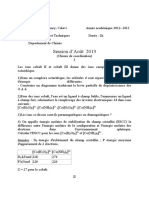

0,6 Contenu + vois inage

0,55 0% rappel 10% rappel 20% rappel

Contenu seulement (Baseline) Notre collection Collection

0,5 INDEGRE

0,5 (Sous collection de TREC) TREC

0,4 0,45 Nombre de sites 490 870

Precision

Précision

0,3

0,4 Nombre de documents 546.423 1.692.096

Application

0,35 Nombre de documents

0,2 477.064 1.532.012

0,3 avec des liens entrants

0,1 Nombre de documents

0,25 410.378 1.295.841

avec des liens sortants

0 0,2

Nombre de requêtes

0,05

0,1

0,15

0,2

0,25

0,3

0,35

0,4

0,45

0,5

0,55

0,6

0,65

0,7

0,75

0,8

0,85

0,9

0,95

1

0% 10% 20% 30% 40% 50% 60% 70% 80% 90% 100% 50 50

11 niveaux standards du rappel Parametre α exécutées

Fig 1. La précision moyenne aux 11 niveaux standard Fig 2. La précision moyenne aux niveaux 0%, 10% et 20% Tab-1. Caractéristique de notre collection de teste.

du rappel pour les 50 requêtes exécutées du rappel en fonction du paramètre α;

nombre de documents pertinents retrouvés

Précision InDegree Baseline 0.15*SD+0.85*VD Définition : Pr écision =

nombre de documents retrouvés

P@5 0,077 0,216 0,306

nombre de documents pertinents retrouvés

P@10 0,072 0,163 0,208 Rappel =

nombre de documents pertinents

Tab-2. P@5 et P@10

Anda mungkin juga menyukai

- Chap 5 Cours Transformation Nucléaire ComplétéDokumen6 halamanChap 5 Cours Transformation Nucléaire Complétéhugo.gloaguen44Belum ada peringkat

- TP Final 1Dokumen8 halamanTP Final 1linaBelum ada peringkat

- PolyDokumen84 halamanPolyPedroBelum ada peringkat

- EXTJRDokumen2 halamanEXTJRRAIDEN YTBelum ada peringkat

- CalorimetrieDokumen2 halamanCalorimetrieToki Mimi100% (1)

- Contribution À L'amélioration Des Méthodes D'optimisation de La Gestion de La Mémoire Dans Le Cadre Du Calcul Haute PerformanceDokumen174 halamanContribution À L'amélioration Des Méthodes D'optimisation de La Gestion de La Mémoire Dans Le Cadre Du Calcul Haute PerformancezachazetBelum ada peringkat

- Travail Et Energie Cinetique Exercices Non Corriges 7Dokumen3 halamanTravail Et Energie Cinetique Exercices Non Corriges 7Papa SallBelum ada peringkat

- Echangeur Thermique Chapitre 1Dokumen24 halamanEchangeur Thermique Chapitre 1aba diawBelum ada peringkat

- Les Méthodes de MaintenanceDokumen3 halamanLes Méthodes de MaintenanceSàmi BmBelum ada peringkat

- Fabrication Du DichlorométhaneDokumen2 halamanFabrication Du DichlorométhaneAmi naBelum ada peringkat

- Intégration D'une Pompe À Chaleur Dans Un Procédé Agroalimentaire - Simulation, Expérimentation Et IntégrationDokumen137 halamanIntégration D'une Pompe À Chaleur Dans Un Procédé Agroalimentaire - Simulation, Expérimentation Et Intégrationmonsterh5100% (1)

- GödelDokumen8 halamanGödelMarco BalzariniBelum ada peringkat

- Chapitre 2 AlgèbreDokumen11 halamanChapitre 2 Algèbreshurimanu4Belum ada peringkat

- Techozyme 41 Purification Acides Nucleiques PDFDokumen8 halamanTechozyme 41 Purification Acides Nucleiques PDFKarim OuzerourouBelum ada peringkat

- Maillage 4Dokumen1 halamanMaillage 4Reda BengrabBelum ada peringkat

- Demarrage Des Moteurs Prof V 2k6Dokumen16 halamanDemarrage Des Moteurs Prof V 2k6havoc2012100% (1)

- M. Sow MPC Année Scolaire: 2020-2021 Durée: 2h00min ClasseDokumen1 halamanM. Sow MPC Année Scolaire: 2020-2021 Durée: 2h00min ClasseNdeye diama Diop100% (1)

- CSI3120 Assignment 1Dokumen4 halamanCSI3120 Assignment 1P o o P o o H e a dBelum ada peringkat

- Chromatographie Planaire: Antoine M. SIOUFFIDokumen27 halamanChromatographie Planaire: Antoine M. SIOUFFIOualid100% (1)

- Rapport Etude 1Dokumen7 halamanRapport Etude 1ArielValdBelum ada peringkat

- Introduction A La Thermodynamique PDFDokumen139 halamanIntroduction A La Thermodynamique PDFFranklin MendozaBelum ada peringkat

- Cours TD AbsorptionDokumen21 halamanCours TD Absorptionمحمد خشعيBelum ada peringkat

- Cour Sur Les TransistorDokumen8 halamanCour Sur Les Transistorharouna souley hegaBelum ada peringkat

- Relation D'équivalence, Relation D'ordreDokumen3 halamanRelation D'équivalence, Relation D'ordreOmar AmroucheBelum ada peringkat

- BN-30x20ht NoteDokumen4 halamanBN-30x20ht NotemaiducthoBelum ada peringkat

- Rockwool FP Rockmur Nu Murs Interieurs 202104Dokumen1 halamanRockwool FP Rockmur Nu Murs Interieurs 202104Fouad AitBelum ada peringkat

- AoutDokumen2 halamanAoutBaroka julien YANEBelum ada peringkat

- Quoi de Neuf Sur La Climatisation À BordDokumen13 halamanQuoi de Neuf Sur La Climatisation À Bordanfel maatougBelum ada peringkat

- Traitement Signal Analogique NumeriqueDokumen72 halamanTraitement Signal Analogique Numeriquebouzid mhamdiBelum ada peringkat

- Db27Kse: Groupe ElectrogeneDokumen4 halamanDb27Kse: Groupe ElectrogeneDa silva Antonio DanyBelum ada peringkat