Evaluacion Convencional Vs Autentica

Diunggah oleh

marisolgudiniJudul Asli

Hak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

Evaluacion Convencional Vs Autentica

Diunggah oleh

marisolgudiniHak Cipta:

Format Tersedia

Psicothema 2000. Vol. 12, Supl. n 2, pp.

95-99

ISSN 0214 - 9915 CODEN PSOTEG Copyright 2000 Psicothema

La evaluacin convencional frente a los nuevos modelos de evaluacin autntica

Amaia Bravo Arteaga y Jorge Fernndez del Valle

Universidad de Oviedo

Durante los ltimos veinte aos, han ido apareciendo nuevas tendencias en evaluacin que tratan de responder a las demandas que la evaluacin convencional, basada en el uso de tests estandarizados no ha logrado cubrir. Estas demandas han tenido un especial protagonismo en el mbito educativo, donde el problema de la evaluacin del logro escolar ha sido objeto de numerosas investigaciones y publicaciones que ofrecen alternativas al uso de tests de eleccin mltiple. El trmino evaluacin autntica agrupa todo este conjunto de alternativas, y se define por oposicin a la evaluacin estandarizada, a la cual considera no-autntica e incapaz de detectar el verdadero aprendizaje. Desde este nuevo modelo se reivindica la importancia del contexto, el realismo de las demandas, de la situacin instruccional, y un mayor protagonismo del proceso frente a los resultados. A lo lar go del trabajo se ofrece una discusin sobre las ventajas, inconvenientes y aplicacin de ambos modelos. Traditional assessment versus authentic assessment. During last years, new trends on evaluation have appeared on educational context. These new alternatives pretend to replace traditional assessment based on standarized tests. In USA, standarized tests have been nearly the only way to assess academic performance during last decades, in fact, an only test was enough to decide educational and labour opportunities of a person. This kind of evaluation has received many criticisms by researchers and teachers, who think this model does not detect real learning. The term authentic assessment gathers some alternatives to assess people by a different way. People are asked for constructing their responses in a significant context. These assessments remark not only result but process too.

La evaluacin estandarizada en el mbito de la Psicologa, tiene sus orgenes en las demandas sociales de principios de siglo. La primera de ellas surge en el mbito educativo, donde al establecerse la enseanza obligatoria se requera algn mtodo para clasificar a los nios en diferentes niveles. La respuesta a este problema la ofreci Binet con el primer test mental que evaluaba procesos superiores de pensamiento (test Binet-Simon, 1905). Un segundo origen se sita en la Primera Guerra Mundial, cuando un grupo de psiclogos de la APA elabor los primeros tests colectivos de inteligencia (Army Alpha y Army Beta), con el fin de seleccionar entre miles de soldados a los ms adecuados para desempear diferentes tareas. Las nuevas demandas de clasificacin y seleccin impulsaron el desarrollo de toda una tradicin en la medicin psicolgica, la tradicin psicomtrica, basada en tres principios: estandarizacin, diferenciacin y el uso de tareas generales. Estos principios son bien reconocidos en los tests de eleccin mltiple, compuestos por un conjunto de tems (tareas generales) que segn el modelo reflejan el dominio de una habilidad. Instrucciones estndar, un deter-

Correspondencia: A. Bravo Arteaga Facultad de Psicologa Universidad de Oviedo 33003 Oviedo (Spain) E-mail: abravo@correo.cop.es

minado nmero de tems, tiempo limitado y obtencin de puntuaciones basadas en los resultados, son algunas caractersticas de los tests de lpiz y papel. A principios de los ochenta, los problemas del sistema educativo americano impulsaron la elaboracin de una reforma educativa que dio mucha importancia a la evaluacin y convirti a los tests estandarizados en su herramienta estrella (Linn, 1995). Este tipo de evaluacin ofreca importantes ventajas, entre las que sobresa len: la gran cantidad de informacin que permiten recabar en grupos grandes de personas, en poco tiempo y bajo coste econmico, adems del gran desarrollo de los estudios de validez y fiabilidad de estas pruebas. Los procedimientos de evaluacin estandarizados se convirtieron en la norma para evaluar el logro de los estudiantes y en el nico punto de referencia para la toma de decisiones tan importantes como el permitir o no a un alumno pasar de curso, a la universidad u obtener un diploma. En muchos casos la puntuacin obtenida en un nico test ha sido suficiente para determinar las oportunidades educativas y econmicas de una persona. Los efectos personales y sociales negativos que se derivan de estas decisiones estn bien documentados en la literatura (Oakes, 1986a; Oakes, 1986b; Jaeger, 1991). Sin embargo, la reforma de los ochenta no cumpli sus expectativas, las investigaciones mostraron slo modestas ganancias en habilidades bsicas. La creciente insatisfaccin foment numerosas crticas hacia los mtodos de evaluacin estandarizados, crti-

96

AMAIA BRAVO ARTEAGA Y JORGE FERNNDEZ DEL VALLE

ca que se fortaleci con los estudios que demostraban el poder que los procedimientos de evaluacin tienen sobre el currculum y los estndares educativos (Frederiksen, 1984; Madaus, 1988). La preocupacin sobre el impacto de las evaluaciones en lo que aprenden los alumnos, ha dirigido uno de los frentes ms importantes contra los mtodos de evaluacin estandarizados. Sobre este tema, Terence Crooks (1988) concluye: La evaluacin en el aula gua el juicio de los estudiantes sobre lo que es importante aprender, afecta a su motivacin y a la percepcin de su propia competencia, estructura su acercamiento al estudio, consolida el aprendizaje y afecta al desarrollo de estrategias de aprendizaje (p. 467). El mismo impacto se ha sealado en la decisin de los profesores sobre el qu y cmo deben ensear. Su trabajo se ve dirigido por las evaluaciones desarrolladas desde los cargos administrativos y polticos, sean municipales, regionales o nacionales (Lomax, 1992; Moss, et al. 1992; Nolan, Haladyna & Hass, 1992). Esto sucede en nuestro sistema educativo con la Selectividad, los profesores centran su instruccin en las habilidades y contenidos exigidos en ese nico examen, ensean habilidades especficas para responder mejor y utilizan el mismo formato en sus propias evaluaciones. Las evaluaciones dirigen y limitan el currculum a los objetivos que se reflejan en los tests, por ello, parece necesario evaluar el amplio rango de conocimientos, habilidades e intereses que queremos fomentar en nuestros estudiantes. En este sentido, Wiggins (1989) anima a los educadores a: evaluar aquellas capacidades y hbitos que creemos esenciales, y evaluarlas en su contexto. En la misma lnea Resnick y Resnick (1991) apuntan uno de sus principios: construye evaluaciones sobre aquello que quieres que los profesores enseen (p. 59), la idea es aprovechar el poder que la evaluacin tiene sobre la enseanza, dicha influencia puede convertirse en virtud y no en debilidad. Recientes investigaciones sobre aprendizaje y cognicin consideran al aprendiz, al estudiante, un participante activo en la construccin del conocimiento y en la comprensin, y no un mero receptor de hechos y reglas de proceder. Como dicen Resnick y Resnick (1991), incluso la memorizacin requiere organizacin para ser efectiva. Esto cambia el rol del profesor de transmisor de conocimiento a mediador del aprendizaje. Los estudiantes deben participar activamente en el proceso de pensamiento, en la organizacin y reorganizacin del conocimiento y en su propia evaluacin. Crticas a la evaluacin estandarizada A la luz de estas preocupaciones, en los ltimos aos se han multiplicado las experiencias, investigaciones y artculos donde se mencionan otros tipos de evaluacin que suelen etiquetarse como autnticos, alternativos, directos, basados en actuaciones. Todos ellos pretenden superar las crticas dirigidas a los mtodos de evaluacin estandarizados. A continuacin se describen algunas de las crticas citadas con mayor frecuencia: 1. Miden slo conocimiento declarativo y no procedimental (Mehrens, 1992). Los tems suelen referirse al recuerdo de hechos y resultados y rara vez evalan estrategias o habilidades procedimentales. 2. Se centran en el resultado y no en el proceso (Mumford, Baughman, Supinski y Andersen, 1998). No pueden explicar el porqu de las diferentes ejecuciones, ni el proceso por el cual llegan a obtener un resultado correcto o incorrecto. 3. No cubren adecuadamente el dominio evaluado (Mehrens, 1992; Wiggins, 1991). Esta crtica, dirigida a la validez de conte-

nido, no se centra exclusivamente en este tipo de medicin. Muchas alternativas a los tests siguen sin representar adecuadamente lo que se pretende evaluar. 4. Existen diferentes habilidades e incluso inteligencias que no son evaluadas por este tipo de tests. Desde la teora de Gardner de las inteligencias mltiples, donde incluye junto a las tradicionales inteligencias lingstica, lgico-matemtica y espacial, las inteligencias corporal-kinestsica, musical, interpersonal e intrapersonal, se sugiere un sistema de evaluacin con medidas ms autnticas. Tambin Powell (1990) critica la limitacin del contenido de estos tests a las reas acadmicas. 5. Son medidas relativas (Powell, 1990). Los tests clasifican a las personas dentro del grupo de referencia segn la puntuacin obtenida, pero en muchas ocasiones el objetivo de la evaluacin no es clasificar, sino averiguar lo que ha aprendido el estudiante, o su nivel de dominio en una tarea o campo concreto, independientemente del nivel de su grupo. Adems, se debe aadir la dificultad de conseguir una adecuada muestra de referencia. 6. La estandarizacin supone una muestra homognea. Sin embargo, la muestra evaluada es heterognea, con diferente dominio del lenguaje, actitudes y valores. 7. El formato de eleccin mltiple limita las evaluaciones y su pone otras habilidades distintas a las evaluadas (Powell, 1990) . Las inferencias realizadas suponen habilidades subyacentes a las respuestas del test. Adems, con frecuencia dependen demasiado de las habilidades verbales de las personas evaluadas o en una nica forma de ver el mundo, lo cual perjudica los resultados obtenidos por algunos grupos. 8. Se alejan de las verdaderas demandas contextuales (Mumford, Baughman, Supinski y Anderson, 1998) . Al buscar simplicidad y estandarizacin, el diseo de estos tests hace difcil detectar cmo la gente desarrolla habilidades especficas en ambientes complejos, ms reales. Este tipo de evaluacin no ofrece a los estudiantes la oportunidad de mostrar sus verdaderas competencias (Johnston, 1987; Newman, 1990). Los objetivos son homogeneizados y no representan adecuadamente los intereses de cada estudiante en su currculum; la puntuacin tambin se centraliza y se basa en criterios establecidos por personas que no conocen a los estudiantes, sus metas, o sus oportunidades de aprendizaje. Cada vez son ms las razones que impulsan a los expertos en el campo de la medicin a buscar alternativas. Bajo la precisin, objetividad y ahorro en tiempo y dinero que ofrece el uso de tests estandarizados, se realizan selecciones que reflejan slo una o pocas dimensiones de las diferencias individuales, no se mide a toda la persona, cuando es precisamente toda la persona la que es contratada para un trabajo o seleccionada para realizar determinada tarea. Nuevas alternativas: la evaluacin autntica Con el fin de superar estos problemas han ido apareciendo nuevas tendencias en evaluacin bajo la denominacin de evaluacin autntica, que es definida por sus defensores por oposicin a la evaluacin tradicional (no-autntica), a la que culpan de algunos de los problemas del actual sistema educativo, donde no se detec ta el verdadero aprendizaje. Este trmino agrupa todo un conjunto de alternativas a la evaluacin tradicional, donde la respuesta no est limitada a la eleccin de una de las alternativas presentadas y donde el contexto es significativo. La persona evaluada hace, crea

LA EVALUACIN CONVENCIONAL FRENTE A LOS NUEVOS MODELOS DE EVALUACIN AUTNTICA

97

o produce algo durante un tiempo suficiente para poder evaluar el proceso, el resultado o ambos (Messick, 1998). En los tests tradicionales la respuesta era correcta o incorrecta, sin posibilidad de conocer el proceso por el cual esa opcin era elegida. Algunos autores apuntan otros requerimientos para hablar de evaluacin autntica: la tarea debe dejar libertad al examinado; el material estimular no debe estar estandarizado; han de ser las propias personas evaluadas las que elijan el momento de actuar para estar verdaderamente motivados; incluso, y especialmente en el mbito educativo, el evaluador debe conocer a las personas que est evaluando, sus circunstancias vitales y su historia de ejecucin de la tarea (Sac kett, 1998). El nuevo modelo se centra en actuaciones ms realistas, siendo su objetivo evaluar en una escala absoluta (no relativa segn el grupo de referencia) cmo las personas dominan tareas especficas. Prcticamente cualquier alternativa al test de lpiz y papel entrara dentro del nuevo modelo: respuestas abiertas (construidas) frente a la mera eleccin de una alternativa; ensa yos; realizacin de tareas que pueden simular el desempeo de un trabajo o ser verdaderas muestras del trabajo que est realizando la persona evaluada (portafolio, en el mbito educati vo). Todos ellos, son indicadores ms convincentes de lo que realmente sabe un estudiante o un candidato para desempear un trabajo. Siempre ha existido este tipo de medidas, pero ahora se proponen como un nuevo sistema de evaluacin a gran escala. Hasta ahora se buscaban evaluaciones baratas, breves, fciles de puntuar y objetivas, el nuevo modelo tiene caractersticas muy diferentes: 1. Se realizan observaciones y registros de la ejecucin de tareas pertenecientes a un dominio especfico , que proporcionan una base para hacer inferencias sobre las personas, sin pretender evaluar habilidades subyacentes. 2. La demanda se asemeja ms a una situacin instruccional re al, donde se presenta un problema, pero no alternativas cerradas para resolverlo. La persona evaluada, no slo tiene que acabar de definir el problema, sino adems elaborar su respuesta. 3. Superan la simplicidad de las preguntas de alternativa mltiple, requiriendo que la persona acte en situaciones ms comple jas y reales. 4. Los resultados son percibidos como ms vlidos por los profesores, representan mejor los verdaderos conocimientos y habilidades del alumno. 5. Pueden examinarse tanto el proceso como el resultado. 6. Se observa la calidad de la ejecucin observada, sin valorar tanto la restrictiva estandarizacin de otras evaluaciones. Para poner en prctica este modelo, es necesario superar importantes retos a los que se enfrentan tanto profesores como investigadores: las aulas son pequeas, no se dispone de los materiales necesarios y las escuelas tienen esquemas de trabajo muy delimitados. Sin embargo, con ms o menos dificultades, cada vez son ms las experiencias donde la evaluacin se aparta de los cnones de la estandarizacin para reflejar las caractersticas del nuevo modelo. Dos ejemplos de su puesta en marcha son: la propuesta de Solano-Flores y Shavelson (1997) para evaluar la realizacin de una tarea y el uso del portafolio en el mbito educativo. Solano-Flores y Shavelson configuran el proceso de evaluacin a travs de tres componentes y tres dimensiones. Los componentes necesarios son siempre: a) una tarea donde se presenta un problema bien contextualizado, cuya solucin requiere el uso de materiales concretos que han de ser utilizados por los estudiantes; b) un medio para recoger las respuestas de los es-

tudiantes (grabaciones, grficos que reflejan la solucin, redaccin de conclusiones) y c) un sistema de puntuacin, con el fin de valorar el razonamiento y exactitud de las respuestas. Las dimensiones tienen un carcter metodolgico y prctico, y se encuentran muy vinculadas unas a otras: a) el contenido hace referencia a aspectos como la adecuada representacin del dominio, asegurar que los contenidos sean significativos y comprensibles para las personas evaluadas y que exista una amplia variedad de soluciones de diferente grado de correccin; b) el equipamiento, tiene en cuenta los materiales y recursos disponibles; y c) la puesta en prctica, alude a la disponibilidad de las condiciones fsicas y de tiempo necesarias, la fiabilidad interjueces, el tiempo para realizar la tarea o el entrenamiento con el sistema de puntuacin. Son frecuentes las tensiones entre las dimensiones debido a su mutua influencia, por ejemplo, si se reduce el coste de los materiales pueden aumentar los errores de medida, y si estos son de alta calidad el coste puede ser muy alto. Se trata de un proceso cclico, donde es imposible optimizarlas todas, se debe buscar la combinacin que maximiza las ventajas y minimiza los inconvenientes. El proceso comienza identificando las actuaciones que demuestran el dominio de ciertas habilidades y seleccionando las tareas que pueden licitarlas. Decididos los aspectos relativos a cada dimensin, el problema o tarea se presenta a las personas que se van a evaluar, y se van registrando los pasos que realizan durante el ejercicio. Las observaciones o registros son valorados por un grupo de jueces, expertos en el campo, quienes evalan la expresin de dichas habilidades y todo el proceso de ejecucin de la tarea. Esta propuesta es una opcin entre muchas de cmo llevar a la prctica la filosofa de la evaluacin autntica, ahora bien, la alternativa que ms atencin ha recibido, especialmente en el contexto educativo, es el portafolio. Se trata de un mtodo muy til en este mbito y que representa un buen ejemplo para explicar algunas caractersticas del nuevo modelo. Arter y Spandel (1991), lo definen como el grupo de trabajos realizados intencionalmente por el estudiante, donde se muestran sus lo gros en una o ms reas. Segn Meisels y Steele (1991), el portafolio permite a los estudiantes participar en la evaluacin de su propio trabajo, permite seguir mejor la pista de su desarrollo y proporciona una base para realizar una evaluacin cualitativa de todos los lo gros de cada nio. El portafolio recoge mltiples pruebas de trabajo: redacciones, cuentos, dibujos, libros ledos, vdeos, fotografas, grabaciones, Idealmente, debera incluir distintos tipos de observaciones (Grace y Shores, 1991): a) Registros de actividades, hechos e intervenciones espontneas realizadas por el estudiante, sin ser juzgadas. Dan una idea de su progreso diario. b) Inventario de objetivos. Es una de las herramientas ms tiles para seguir el progreso de los estudiantes, donde se especifican diferentes objetivos educativos, entre ellos los diferentes pasos para la adquisicin de habilidades. En general, las observaciones se basan en actividades cotidianas de clase . c) Escalas de evaluacin. Son apropiadas cuando el comportamiento observado tiene diferentes aspectos o componentes. d) Preguntas y peticiones. Una de las maneras ms directas de recoger informacin es preguntar directamente al alumno sobre su opinin o conocimientos sobre un tema determinado. Demuestra no slo sus conocimientos sino tambin sus habilidades lingsticas. e) Tests de prueba. Ayudan a identificar las habilidades y conocimientos adquiridos, con el fin de guiar la planificacin del proceso de enseanza.

98

AMAIA BRAVO ARTEAGA Y JORGE FERNNDEZ DEL VALLE

El portafolio supone un buen ejemplo de lo que se viene llamando evaluacin autntica. Es un mtodo que permite conocer mejor a los estudiantes y sus verdaderos logros, adems de ofrecerles una visin ms realista de las demandas que recibirn fuera del mbito escolar. Un estudio de Calfee y Perfumo (1993) sobre la utilizacin del portafolio y basado en la opinin de los profesores, revel dos aspectos importantes: por un lado, los profesores reconocen haber introducido el portafolio a su prctica educativa como un intento de renovacin personal, impulsados por un nuevo compromiso que ha incrementado su estatus, hacindoles ms responsables de su propia instruccin; por otra parte, reconocen que los fundamentos tcnicos de esta evaluacin son an dbiles, todava no est claro cmo medir los logros conseguidos. Limitaciones de los nuevos modelos A pesar de todas las ventajas mencionadas, no son pocos los problemas asociados a estas alternativas en evaluacin: 1. Son mtodos mucho ms costosos. Al mayor coste econmico, hay que aadir el tiempo, siendo adems mucho menor el nmero de personas que pueden ser evaluadas simultneamente. 2. Dificultad de elaborar evaluaciones paralelas. A diferencia de los tests, encontrar tareas cuyos requerimientos sean idnticos es muy difcil. 3. Falta de acuerdo en los constructos que han de evaluarse en el proceso de resolucin de problemas. 4. El uso de jueces para puntuar la ejecucin de tareas supone mayor subjetividad. La probabilidad de error aumenta y el coste es mayor. Aunque se entrene a los jueces y se les muestren ejemplos de una buena y mala ejecucin, los jueces no siempre siguen estas

reglas. Sus evaluaciones estn sometidas a factores situacionales, caractersticas de los examinados y asunciones del estereotipo de lo que es una buena ejecucin. 5. La compleja naturaleza de muchos ejercicios. Esta complejidad no slo hace que la evaluacin sea ms cara y difcil de puntuar, sino que dificulta la obtencin de una muestra adecuada de la expresin de estas habilidades. Por otro lado, el tiempo no puede alargarse ms de dos horas, para asegurar un buen rendimiento, y esto limita el nmero de tareas a un mximo de tres o cuatro, lo que difcilmente asegura una adecuada representacin de esa habilidad. 6. El efecto del contexto en la evaluacin. Separar la influencia del contexto de evaluacin de la ejecucin realizada es muy difcil. Los resultados pueden verse influidos por la presencia de otras personas y en el caso concreto del portafolio, nos encontramos con el problema de cmo averiguar si las muestras presentadas han sido realizadas por el nio. 7. Generalizacin de las inferencias. Al centrarse en habilidades especficas es difcil generalizar a otros dominios. Se requeriran evaluaciones muy amplias, extendidas a diferentes dominios, lo que encarecera el coste y se perdera efectividad. Los mtodos utilizados en este modelo no son novedosos, de hecho responden al tipo de evaluacin que se ha realizado dentro del aula durante muchos aos, la novedad se encuentra en su aplicacin a las evaluaciones a gran escala, y es aqu donde aparecen sus limitaciones. Aspectos como la validez y fiabilidad de las mediciones tienen gran relevancia, lo que es vlido dentro del aula, puede no serlo en una evaluacin a gran escala. Muchos autores han tratado el problema de la validacin de estas mediciones, sin embargo, no sucede lo mismo con la fiabilidad, olvidada por los defensores de la evaluacin autntica.

Tabla 1 Diferencias entre las dos lneas de evaluacin (Mumford, Baughman, Supinski y Anderson, 1998) EVALUACIN TRADICIONAL OBJETIVO Clasificar a las personas en funcin de la puntuacin alcanzada en el test. EVALUACIN AUTNTICA Evaluar el nivel de desarrollo de la habilidad a travs de la actuacin manifestada. Tareas ms amplias (ej. resolucin de un problema). Las respuestas sealan el dominio de una/s habilidad/es. Puntuacin a partir del juicio de expertos. Discrimina a las personas en funcin del dominio demostrado en habilidades especficas. Especificar el tipo de actuacin y conocimiento relevantes para cierta habilidad. Tareas realistas y referidas a un dominio especfico. Puntuacin en escala absoluta segn el criterio de referencia (dominio de habilidad). Recoge la complejidad de las habilidades. Refleja las diferencias cualitativas. Buena informacin diagnstica. Alta validez ecolgica.

MEDIDA

Tareas muy especficas y concretas (tems). Las respuestas sealan habilidades subyacentes. Puntuacin objetiva. Discrimina a las personas en funcin del nivel alcanzado en cierta habi lidad a partir de las puntuaciones obtenidas. Especificar los constructos que se pretenden evaluar con el test. tems que maximicen la discriminacin entre las personas. tems relacionados entre s. Coste bajo. Puntuacin objetiva. Fiabilidad. Imparcialidad. Validez predictiva. Generalizacin de inferencias. Validez de constructo. Puntuacin en escala relativa, segn grupo normativo. No recoge toda la complejidad de las habilidades evaluadas. Insensible a las diferencias cualitativas. Limitada informacin diagnstica. No est directamente relacionado con los conocimientos y habilidades del mundo real.

INFERENCIAS

DESARROLLO

VENTAJAS

DESVENTAJAS

Coste alto. Puntuacin subjetiva. Muestra del dominio no representativa. Efectos del contexto sobre las puntuaciones. Escasa generalizacin de las inferencias. Injusta para las personas pertenecientes a bajo nivel socioeconmico.

LA EVALUACIN CONVENCIONAL FRENTE A LOS NUEVOS MODELOS DE EVALUACIN AUTNTICA

99

Discusin Cada modelo responde mejor a unos determinados objetivos (tabla 1), mientras la evaluacin estandarizada permite evaluar a grandes grupos de personas simultneamente de forma objetiva, la evaluacin autntica busca mayor profundidad y exhaustividad, centrndose ms en el caso individual, a pesar de hacerlo a travs de evaluaciones ms subjeti vas. No tiene sentido sustituir un modelo por otro cuando los dos han demostrado su efectividad en di ferentes contextos. La primera ha resultado de gran utilidad cuando hay que seleccionar a un nmero de personas dentro de una amplia muestra. De hecho, dentro de la tradicin psicomtrica se est desarrollando una nueva lnea que supera muchos de los inconvenientes de la Teora Clsica de los Test, se trata de la Teora de Respuesta a los tems. Una de sus aplicaciones, los tests adaptativos informatizados, ha aportado grandes ventajas a la hora de realizar evaluaciones objetivas a un grupo muy amplio con fines de seleccin o cla sificacin (pruebas de acceso a la universidad, M.I.R., P.I.R., etc.). Por otro lado, en contextos como el educativo, la evaluacin autntica va ganando adeptos, lo cual tiene sentido si el verdade-

ro objetivo de la escuela es ensear y no clasificar a los estudiantes segn el nivel alcanzado en un test. Un profesor debe conocer lo que realmente ha aprendido cada uno de sus alumnos, con el fin de desarrollar mejor el proceso de enseanza, para ello un nico examen a fin de curso (o trimestral) no es el mejor indicador. De aqu proviene la defensa de la olvidada evaluacin continua mediante mtodos como los antes indicados por Grace y Shores (1991), si bien, para ello no vale slo defender este nuevo modelo, sino adecuar el contexto educativo para poder aplicarlo (nmero reducido de alumnos, caractersticas del aula, contactos profesor-alumno). No faltan en ambos modelos las ventajas e inconvenientes de su aplicacin (tabla 1), aunque el espritu de renovacin de la evaluacin autntica ha provocado una cierta visin romntica de sus posibilidades. Para rechazar la evaluacin estandarizada, conviene primero analizar cul es el objetivo de la evaluacin y los recursos disponibles, en palabras de Frechtling (1991): antes de asumir que disponemos de una alternativa que puede solucionar los problemas a los que nos enfrentamos, debemos estudiar esta nueva herramienta de manera ms analtica y menos emocional, y preguntarnos qu puede y no puede hacer.

Referencias

Arter, J. y Spandel, V. (1991). Using portafolios of student work in ins truction and assessment. Portland, OR: Northwest Regional Educational Laboratory. Calfee, R.C., y Perfumo, P. (1993). Student portafolios: opportunities for a revolution in assessment. Journal of Reading, 36, 532-537. Crooks, T.J. (1988). The impact of classroom evaluation practices on students. Review of Educational Research, 85(4), 438-481. Frechtling, J.A. (1991). Performance assessment: moonstruck or the real thing?. Educational Measurement: Issues and Practice,10(4), 23-25. Frederiksen, N. (1984). The real test bias: influences of testing on teaching and learning. American Psychologist, 39(4), 193-202. Grace, C. y Shores, E.F. (1991). The portafolio and its use: develop mentally appropiate assessment of young children. Little Rock, AR: Southern Early Childhood Association. Jaeger, R.M. (1991). Legislative perspectives on statewide testing. Phi Delta Kappan, 73(3), 239-242. Johnston, P. (1987). Assessing the process, and the process of assessment, in the language arts. En J.R. Squire (Ed.) The dynamics of language learning: research in reading and English. (pp.335-357). Urbana: ERIC Clearinghouse on Reading and Communication Skills. Linn, R.L. (1995). High-stakes uses of performance-based assessments. Rationale, examples, and problems of comparability. En Oakland, T., Hambleton, R. K. (Eds.). International perspecti ves on academic as sessment. (pp. 49-73). Boston/ Dordrecht/London: Kluwer Academic Publishers. Lomax, R.G. (1992). Appendix A: Nationwide teacher survey. En G.F. Madaus, M.M. West, M.C. Harmon, R.G. Lomax, y K.A. Viator (Eds.). The influence of testing on teaching math and science in grades 4-12. Chestnut Hill, MA: Center for the Study of Testing, Evaluation, and Public Policy, Boston College. Madaus, G. (1988). Testing and the curriculum: from compliant servant to dictatorial master. En L. Tanner (Ed.), Critical issues in curriculum: 87th NSSE yearbook. (pp. 83-121). Chicago: National Society for the study of Education. Mehrens, W.A. (1992). Using performance assessment for accountability purposes. Educational Measurement: Issues and Practice, 11(1), 320. Meisels, S. y Steele, D. (1991). The early childhood portafolio collec tion process. Ann Arbor, MI: Center for Human Growth and Development, University of Michigan. Messick, S.J. (1998). Alternative modes os assessment, uniform standards of validity. En M.D. Hakel (Ed.) Beyond multiple choice: evaluation alternatives to traditional testing for selection, (pp. 59-74) Mahwah, NJ: Lawrence Erlbaum Associates Publishers. Moss, P.A., Beck, J.S., Ebbs, C., Matson, B., Muchmore, J., Steele, D., Taylor, C., Herter, R. (1992). Portafolios, accountability, and interpretive approach to validity. Educational Measurement: Issues and Practice, 11(3), 12-21. Mumford, M.D., Baughman, W.A., Supinski, E.P., Anderson, L.E. (1998). A construct approach to skill assessment: procedures for assessing complex cognitive skills. En M.D. Hakel (Ed.) Beyond multiple choice: evaluation alternatives to traditional testing for selection. (pp. 75-112). Mahwah, NJ: Lawrence Erlbaum Associates Publishers. Newmann, F.M. (1990). Higher order thinking in teaching social studies: a rationale for the assessment of classroom thoughtfulness. Journal of Curriculum Studies, 22(1), 41-56. Nolan, S.B., Haladyna, T.M. y Hass, N.S. (1992). Uses and abuses of achievement test scores. Educational measurement: Issues and Practice, 11(2), 9-15. Oakes, J. (1986a). Beyond tracking. Educational Horizons, 65(1), 32-35. Oakes, J. (1986b). Tracking, inequality, and the rethoric of school reform: why schools dont change. Journal of education, 168(1), 61-80. Powell, M. (1990). Performance assessment: panacea or pandoras box. Rockville, MD: Montgomery County Public Schools. Resnick, L.B. y Resnick, D.P. (1991). Assessing the thinking curriculum: New tools for educational reform. En B.G. Gifford y M.C. OConner (Eds.) Changing assessments: alternative views of aptitude, achievement and instruction. (pp. 37-75). Boston: Kluwer Academic Publishers. Sackett, P.R. (1998). Performance assessment in education and professional certification: lessons for personnel selection? En M. D. Hakel (Ed.) Beyond multiple choice: evaluation alternatives to traditional testing for selection, (cap. 8, pp. 113-129) Mahwah, NJ: Lawrence Erlbaum Associates Publishers. Solano-Flores, G., Shavelson, R.J. (1997). Development of performance assessments in science: conceptual, practical, and logistical issues. Edu cational Measurement: Issues and Practice, 16(3 ), 16-25. Wiggins, G. (1989). A true test: Toward more authentic and equitable assessment. Phi Delta Kappan, 79 , 703-713. Wiggins, G. (1991). A response to Cizek. Phi Delta Kappas, 72, 700703.

Anda mungkin juga menyukai

- Instrumentos y Tecnicas de Investigación Educativa: Un Enfoque Cuantitativo y Cualitativo para la Recolección y Análisis de DatosDari EverandInstrumentos y Tecnicas de Investigación Educativa: Un Enfoque Cuantitativo y Cualitativo para la Recolección y Análisis de DatosPenilaian: 3.5 dari 5 bintang3.5/5 (18)

- Estrategias de evaluación: Evaluar los procesos de aprendizajeDari EverandEstrategias de evaluación: Evaluar los procesos de aprendizajeBelum ada peringkat

- CNE2011 Taller Wilfredo Gonzales FloresDokumen22 halamanCNE2011 Taller Wilfredo Gonzales FloresElio TapiaBelum ada peringkat

- Perspectiva Crítica Comunicativa y Sus Enfoques CurricularesDokumen9 halamanPerspectiva Crítica Comunicativa y Sus Enfoques CurricularesJorge Ivan Tilleria ZuñigaBelum ada peringkat

- Evaluar para aprender: Investigación-acción en la Universidad de La SabanaDari EverandEvaluar para aprender: Investigación-acción en la Universidad de La SabanaBelum ada peringkat

- Proyecto de Ley de OptometríaDokumen22 halamanProyecto de Ley de Optometríaopticapucv100% (5)

- Calidad de vida Europa y AsiaDokumen5 halamanCalidad de vida Europa y AsiaJham CMBelum ada peringkat

- La Evaluación Del Aprendizaje en La Universidad. Tensiones, Contradicciones y DesafíosDokumen22 halamanLa Evaluación Del Aprendizaje en La Universidad. Tensiones, Contradicciones y DesafíosJazz BluesBelum ada peringkat

- Los paradigmas de la evaluación educativaDokumen8 halamanLos paradigmas de la evaluación educativaMarisol Reza Ferreyra100% (2)

- 3 Herramientas Tic para El Area de MatematicaDokumen59 halaman3 Herramientas Tic para El Area de MatematicamarcosBelum ada peringkat

- Autoeficacia del profesor universitario: Eficacia percibida y práctica docenteDari EverandAutoeficacia del profesor universitario: Eficacia percibida y práctica docenteBelum ada peringkat

- Pruebas EstandarizadasDokumen17 halamanPruebas Estandarizadasapi-413808663Belum ada peringkat

- Evaluacion, ParafaseoDokumen4 halamanEvaluacion, ParafaseoAndrEea DlBelum ada peringkat

- 4 Evalua Instit DilemasDokumen30 halaman4 Evalua Instit DilemasMarisol GonzalezBelum ada peringkat

- La Evaluación EducativaDokumen11 halamanLa Evaluación EducativaJoselym MontenegroBelum ada peringkat

- Lect Complementaria La Evaluación Educativa - de La GarzaDokumen8 halamanLect Complementaria La Evaluación Educativa - de La GarzaraquelgabrielaBelum ada peringkat

- La Evaluación Del Aprendizaje en La UniversidadDokumen35 halamanLa Evaluación Del Aprendizaje en La Universidadjosep275Belum ada peringkat

- De La Garza (2004) - La Evaluación EducativaDokumen10 halamanDe La Garza (2004) - La Evaluación EducativaEncaladaBelum ada peringkat

- Evaluacion de Procesos y AprendizajesDokumen3 halamanEvaluacion de Procesos y AprendizajeslauraBelum ada peringkat

- Nae7004 s3 Apunte2 VFDokumen10 halamanNae7004 s3 Apunte2 VFKarina Atenas PigattiBelum ada peringkat

- Test Psicológicos - Resumen Ileana Zea 000101459Dokumen14 halamanTest Psicológicos - Resumen Ileana Zea 000101459Ileana Zea de SalazarBelum ada peringkat

- Capítulo 1 MONEREODokumen2 halamanCapítulo 1 MONEREOAlejandra CamposBelum ada peringkat

- Paradigmas de La EvaluaciónDokumen14 halamanParadigmas de La EvaluaciónJorge Luis Meléndez CastañedaBelum ada peringkat

- Evaluación CurricularDokumen14 halamanEvaluación Curricularleolaiz100% (2)

- Importancia Relativa de Tres Enfoques PsicológicosDokumen15 halamanImportancia Relativa de Tres Enfoques Psicológicoswarkiller1972Belum ada peringkat

- Sistema de evaluación en la Universidad Pedagógica NacionalDokumen239 halamanSistema de evaluación en la Universidad Pedagógica NacionaldiegoBelum ada peringkat

- Para Qué Sirve La Evaluación Educativa PDFDokumen10 halamanPara Qué Sirve La Evaluación Educativa PDFLuis Diego Aguilar LizarragaBelum ada peringkat

- Pedrini - Evaluacion Educativa - Aportes para Su ReflexionDokumen19 halamanPedrini - Evaluacion Educativa - Aportes para Su Reflexionr_guilloteBelum ada peringkat

- jUICIOS VALORATIVOSDokumen6 halamanjUICIOS VALORATIVOSGurjhas Peru GurjhasBelum ada peringkat

- Ficha Resumen 2Dokumen7 halamanFicha Resumen 2Pamella Josselyn Sanchez MillaresBelum ada peringkat

- La Evaluación y La AcreditaciónDokumen14 halamanLa Evaluación y La AcreditaciónMarcela MiceliBelum ada peringkat

- ART13 - Vol9 - N3 2010Dokumen20 halamanART13 - Vol9 - N3 2010Carlos EspinozaBelum ada peringkat

- 2examen de Orientacion PDFDokumen47 halaman2examen de Orientacion PDFReiniery MejiaBelum ada peringkat

- Funciones, Instrumentos y ResuisitosDokumen6 halamanFunciones, Instrumentos y ResuisitosTamara HerreraBelum ada peringkat

- Evaluación de los aprendizajes en la enseñanza universitariaDokumen8 halamanEvaluación de los aprendizajes en la enseñanza universitariaepuchuluBelum ada peringkat

- Teorías EvaluativasDokumen9 halamanTeorías EvaluativasCIRO ALFONSO GARCÍA IZAQUITABelum ada peringkat

- El docente ante la paradoja de la evaluaciónDokumen17 halamanEl docente ante la paradoja de la evaluaciónDiego Alexander Rodriguez OrtizBelum ada peringkat

- Evaluaciones Estandarizadas Seis Reflexiones CríticasDokumen27 halamanEvaluaciones Estandarizadas Seis Reflexiones CríticasyadiraafBelum ada peringkat

- Original LucianoDokumen15 halamanOriginal LucianoJoa Vargas CuevasBelum ada peringkat

- Ensayo PimientaDokumen5 halamanEnsayo PimientaMirthza AguilarBelum ada peringkat

- La Importancia de La Evaluación FormativaDokumen3 halamanLa Importancia de La Evaluación FormativaVentus LiberBelum ada peringkat

- La Evaluacion Autentica Centrada en El DesempenoDokumen53 halamanLa Evaluacion Autentica Centrada en El DesempenoMaria Del Carmen SuárezBelum ada peringkat

- AmbitosDokumen8 halamanAmbitosJeury Payano Diaz O̲̲̅̅f̲̲̅̅ı̲̲̅̅c̲̲̅̅ı̲̲̅̅a̲̲̅̅l̲̲̅̅'̲̲̅̅F̲̲̅̅bBelum ada peringkat

- EvaluaciónDokumen14 halamanEvaluaciónDanteRodriguezBelum ada peringkat

- Modelos de Evaluación Docente en Las Instituciones de Educación Superior en MéxicoDokumen15 halamanModelos de Evaluación Docente en Las Instituciones de Educación Superior en MéxicoSilviaBelum ada peringkat

- Establecimiento de Competencias Esenciales para Evaluadores de ProgramaDokumen19 halamanEstablecimiento de Competencias Esenciales para Evaluadores de ProgramaDogar JoMiBelum ada peringkat

- Sustentos Teoricos de La EvaluacionDokumen13 halamanSustentos Teoricos de La Evaluacionnicole dominique donoso valenzuelaBelum ada peringkat

- Material Cromatografo Agilent 7890ADokumen9 halamanMaterial Cromatografo Agilent 7890Ajohny SierraBelum ada peringkat

- Trabajo ConsolidadoDokumen8 halamanTrabajo ConsolidadoMartha Isabel BastidasBelum ada peringkat

- Anijovich, La Evaluación Significativa - La RetroalimentaciónDokumen15 halamanAnijovich, La Evaluación Significativa - La RetroalimentaciónYesica OliveraBelum ada peringkat

- Resumen Del Libro Evaluación EducativaDokumen5 halamanResumen Del Libro Evaluación EducativaMaricela Ayard OrtegaBelum ada peringkat

- EvaluaciónDokumen13 halamanEvaluaciónpeperudyBelum ada peringkat

- Introducción A La Evaluación Del Aprendizaje en EducaciónDokumen20 halamanIntroducción A La Evaluación Del Aprendizaje en EducaciónvictormanueljulianBelum ada peringkat

- Breve Historia de La EvaluaciónDokumen4 halamanBreve Historia de La Evaluaciónkid_latigo100% (1)

- Educacion MotrizDokumen15 halamanEducacion MotrizSarahi Serna Lopez100% (1)

- Modelos de Evaluación EducativaDokumen25 halamanModelos de Evaluación EducativaTasha Carcache CascanteBelum ada peringkat

- La Importancia de La Evaluación FormativaDokumen3 halamanLa Importancia de La Evaluación FormativaCiefd GuanajuatoBelum ada peringkat

- Texto Unidad IiDokumen13 halamanTexto Unidad IiMENDEL SRLBelum ada peringkat

- Ensayo Politicas de La EvaluacionDokumen9 halamanEnsayo Politicas de La EvaluacionMontserrat AvendañoBelum ada peringkat

- Shepard - Evaluación FormativaDokumen13 halamanShepard - Evaluación FormativaRodrigo Gómez100% (1)

- Evolucion de Los Enfoques de Evaluacion de Los AprendizajesDokumen8 halamanEvolucion de Los Enfoques de Evaluacion de Los AprendizajesKaren Cartes ValenzuelaBelum ada peringkat

- 10 Olga Gonzc3a1lez y Manuel Flores La Evaluacic3b3n Del AprendizajeDokumen19 halaman10 Olga Gonzc3a1lez y Manuel Flores La Evaluacic3b3n Del AprendizajeNéstor KliczukBelum ada peringkat

- Evaluacion EducativaDokumen9 halamanEvaluacion EducativaNestor LinuxBelum ada peringkat

- Evaluación educativa: tipos y funcionesDokumen10 halamanEvaluación educativa: tipos y funcionesJessica Lizeth Flores GuerreroBelum ada peringkat

- Acta Constitutiva de La Asociación Promotora de Educación ComunitariaDokumen2 halamanActa Constitutiva de La Asociación Promotora de Educación ComunitariaPeterJboAglr100% (4)

- Kant, ProlegomenosDokumen7 halamanKant, ProlegomenosAna MarkovićBelum ada peringkat

- Clase 16. Sobre La Práctica de La Lectura en La Escuela - Supuestos, Continuidades y RupturasDokumen14 halamanClase 16. Sobre La Práctica de La Lectura en La Escuela - Supuestos, Continuidades y RupturasJavierAguileraBelum ada peringkat

- Criterios de Calidad Kinesiologia y FisioterapiaDokumen37 halamanCriterios de Calidad Kinesiologia y FisioterapiaNici0% (2)

- Trastorno Específico Del LenguajeDokumen19 halamanTrastorno Específico Del LenguajeDaniBelum ada peringkat

- Historia de la I.E. Juan Velazco AlvaradoDokumen3 halamanHistoria de la I.E. Juan Velazco AlvaradoKlaudio Pillaca TaypeBelum ada peringkat

- Fortalecemos relaciones familiares juegos cooperativosDokumen2 halamanFortalecemos relaciones familiares juegos cooperativosJuanCarbajalRondonBelum ada peringkat

- Proyecto de GradoDokumen49 halamanProyecto de Gradojorge maldonado semperteguiBelum ada peringkat

- Resumen - Carolina Gutierrez ArrietaDokumen2 halamanResumen - Carolina Gutierrez ArrietaCarolina Gutiérrez ArrietaBelum ada peringkat

- Responsabilidad Social Cementos LimaDokumen48 halamanResponsabilidad Social Cementos LimaEmerson Vidal MasiasBelum ada peringkat

- Metodo Programa IndividualizadoDokumen8 halamanMetodo Programa IndividualizadoDorian MurilloBelum ada peringkat

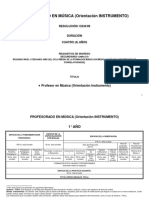

- Profesorado de Instrumento 13234Dokumen10 halamanProfesorado de Instrumento 13234Franco Pola Capellari0% (1)

- Catálogo de Casos SEKNDokumen59 halamanCatálogo de Casos SEKNMarvin FloresBelum ada peringkat

- Ambientes ApaDokumen6 halamanAmbientes ApahwserranitoBelum ada peringkat

- Monografia ProgramacionDokumen13 halamanMonografia ProgramacionKatherine CamposBelum ada peringkat

- Analisis Del Diario de Campo 1Dokumen5 halamanAnalisis Del Diario de Campo 1Arelis LLannosBelum ada peringkat

- 3°secuencia de ActividadesDokumen9 halaman3°secuencia de ActividadesjuanBelum ada peringkat

- Proyecto GuitarraDokumen5 halamanProyecto GuitarraMarco Antonio Rojas RonquilloBelum ada peringkat

- Transferencia de TecnologiaDokumen6 halamanTransferencia de TecnologiaAngel LagualBelum ada peringkat

- Claudia Yadira Ombita AguileraDokumen142 halamanClaudia Yadira Ombita AguileraJoana MoraBelum ada peringkat

- Factores Familiares Asociados Al Consumo de Sustancias Psicoactivas (Spa) en AdolescentesDokumen73 halamanFactores Familiares Asociados Al Consumo de Sustancias Psicoactivas (Spa) en AdolescentesJuanitaSanmiguelBelum ada peringkat

- Evaluacion de Los Aprendizajes Por Objetivos MarixaDokumen9 halamanEvaluacion de Los Aprendizajes Por Objetivos MarixaJonathan CastilloBelum ada peringkat

- USAER Guía de La Planeación GrupalDokumen2 halamanUSAER Guía de La Planeación GrupalAugusto Canto MBelum ada peringkat

- Gestión Profesional 1 GPPDokumen13 halamanGestión Profesional 1 GPPJERSIN JULINHO ZEVALLOS ARZAPALOBelum ada peringkat

- Aa P2 Ibtwo IiibimDokumen11 halamanAa P2 Ibtwo IiibimCesar QuichuaBelum ada peringkat

- Programa de Música 5 SemestreDokumen48 halamanPrograma de Música 5 SemestreyolygzzibarraBelum ada peringkat