Estratégias para Alocação Dinâmica de Recursos em Um Ambiente Híbrido de Computação em Nuvem

Diunggah oleh

rafaeltelematica21850 penilaian0% menganggap dokumen ini bermanfaat (0 suara)

51 tayangan12 halamanJudul Asli

Estratégias Para Alocação Dinâmica de Recursos Em Um Ambiente Híbrido de Computação Em Nuvem

Hak Cipta

© © All Rights Reserved

Format Tersedia

PDF, TXT atau baca online dari Scribd

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

© All Rights Reserved

Format Tersedia

Unduh sebagai PDF, TXT atau baca online dari Scribd

0 penilaian0% menganggap dokumen ini bermanfaat (0 suara)

51 tayangan12 halamanEstratégias para Alocação Dinâmica de Recursos em Um Ambiente Híbrido de Computação em Nuvem

Diunggah oleh

rafaeltelematica2185Hak Cipta:

© All Rights Reserved

Format Tersedia

Unduh sebagai PDF, TXT atau baca online dari Scribd

Anda di halaman 1dari 12

12 XI Workshop de Computao em Clouds e Aplicaes

Estrat egias para Alocac ao Din amica de Recursos em um

Ambiente Hbrido de Computac ao em Nuvem

Paulo Antonio Leal Rego

1

, Emanuel Ferreira Coutinho

1,2

, Jos e Neuman de Sousa

1

1

Mestrado e Doutorado em Ci encia da Computac ao (MDCC)

Universidade Federal do Cear a (UFC) Fortaleza, CE Brasil

2

Instituto UFC Virtual

Universidade Federal do Cear a (UFC) Fortaleza, CE Brasil

pauloalr@ufc.br, emanuel@virtual.ufc.br, neuman@ufc.br

Abstract. With the rise of cloud computing, many applications are migrating

to such environments. Increasingly resources are needed to fulll the applicati-

ons SLA requirements. These resources are rarely static, because they vary over

time due the workload changes. The purpose of this work is to present a solution

for dynamic and autonomic resource allocation in a cloud computing environ-

ment. This work describes strategies, based on the creation of virtual machines

and dynamic allocation of resources, to meet SLA requirements and ensure the

applications quality of service in a hybrid cloud computing environment. The

solution leverages the FairCPU architecture to dynamically adjust the amount

of CPU according to thresholds pre-dened by the user. Adding to that, several

experiments were conducted to compare three different strategies.

Resumo. Com a ascens ao da Computac ao em Nuvem, muitas aplicac oes est ao

migrando para este tipo de ambiente. Cada vez mais recursos s ao necess arios

para atender os requisitos de SLA das aplicac oes e esses recursos s ao raramente

est aticos, pois variam com o tempo, dada as mudancas na carga de trabalho.

O objetivo deste trabalho e apresentar uma soluc ao para alocac ao din amica e

auton omica de recursos emumambiente de Computac ao emNuvem. Este traba-

lho descreve estrat egias, baseadas na criac ao de m aquinas virtuais e alocac ao

din amica de recursos, para atender os requisitos de SLA e garantir a qualidade

de servico das aplicac oes emumambiente hbrido de Computac ao emNuvem. A

soluc ao aproveita a arquitetura FairCPU para ajustar dinamicamente a quan-

tidade de CPU conforme limites pr e-estabelecidos pelo usu ario. Al em disso,

experimentos foram conduzidos para comparar tr es estrat egias.

1. Introduc ao

Atualmente, muitos ambientes de Computac ao em Nuvem hospedam v arias aplicac oes

com diferentes caractersticas.

E natural que tais aplicac oes possuam diferentes Acordos

de Nvel de Servico (Service Level Agreement - SLA).

Nuvens computacionais s ao tipicamente datacenters virtualizados emlarga escala,

que hospedam milhares de servidores. Apesar de existirem diversas vantagens ao se uti-

lizar infraestruturas virtualizadas, como escalabilidade de recursos sob demanda, existem

tamb em quest oes que impedem sua utilizac ao generalizada. Em particular, para o sucesso

Anais 129

comercial desse paradigma, as infraestruturas de Computac ao em Nuvem precisam prover

uma melhor Qualidade de Servico (Quality of Service - QoS) [Wu et al. 2011].

Alocar recursos da infraestrutura para que esta atenda ao SLA das aplicac oes n ao

e uma tarefa f acil. Muitos par ametros podem ser utilizados como crit erios para a alocac ao

dos recursos. Algumas das m etricas utilizadas s ao geralmente relacionadas ao consumo

de CPU e mem oria, mas qualquer fator pode ser utilizado como entrada para tomada de

decis ao na alocac ao de recursos.

A quantidade de recursos necess aria para as aplicac oes s ao raramente est aticas,

pois variam com o resultado de mudancas em cargas de trabalho global, e aplicac oes

internas. O sub-provisionamento de recursos pode causar violac oes dos Objetivos de

Nvel de Servico (Service Level Objective - SLO), que s ao frequentemente associados

com signicativas penalidades nanceiras. O sobre-provisionamento desperdica recursos

que podem ser utilizados em outros casos. Para evitar ambos problemas, a quantidade de

recursos alocada para aplicac oes pode ser ajustada dinamicamente [Gong et al. 2010].

Este artigo tem como objetivo trabalhar sobre o desao de prover recursos compu-

tacionais sob demanda para garantir QoS das aplicac oes executadas em m aquinas virtuais

(MVs). Como resultado, uma soluc ao auton omica foi desenvolvida (estendendo a arquite-

tura FairCPU [Rego et al. 2011]) para modicar dinamicamente a quantidade de recursos

de CPU e instanciar/remover MVs. Al em disso, experimentos foram realizados em uma

nuvem hbrida, utilizando um balanceador de carga para distribuir as requisic oes de uma

aplicac ao web, alinhada a diferentes estrat egias para a alocac ao din amica de recursos.

O trabalho est a organizado da seguinte forma: a Sec ao 2 apresenta os trabalhos

relacionados; a Sec ao 3 descreve a soluc ao proposta, detalhando os componentes da ar-

quitetura; na Sec ao 4 e descrita a metodologia de avaliac ao; a Sec ao 5 apresenta os expe-

rimentos e discute os resultados; nalmente, a conclus ao e trabalhos futuros s ao apresen-

tadas na Sec ao 6.

2. Trabalhos relacionados

Diversos trabalhos consideram m ultiplos aspectos do ambiente para alocac ao de recursos,

baseando-se nesses par ametros para a tomada de decis ao. A maioria dos trabalhos executa

a coleta de informac oes dos ambientes e os utilizam para decidir a alocac ao dos recursos.

Em [Zhang et al. 2010], uma abordagem para o gerenciamento de recursos da in-

fraestrutura utilizando um loop de controle adaptativo foi proposta. Foram utilizados dois

loops de controle: um para alocar os recursos e outro para otimizar o consumo. Seus

experimentos utilizaram o Xen e trabalharam no nvel de PaaS (Platform as a Service).

Este trabalho e gen erico para se adequar a qualquer par ametro ou aspecto, como CPU e

mem oria, porque ele monitora m etricas de desempenho e pode modic a-la sempre que

necess ario.

Em [Heo et al. 2009] foi executado um experimento que verica como recursos

de mem oria se comportam na consolidac ao de um ambiente, e verica como mem oria e

CPU se comportam em diferentes aplicac oes. Foi desenvolvido um controle para alocar

dinamicamente mem oria e garantir que as MVs possuammem oria suciente para executar

suas aplicac oes. Foi utilizado o Xen como hipervisor nos experimentos.

Em [Emeakaroha et al. 2011], uma heurstica para a alocac ao de recursos conside-

13" XI Workshop de Computao em Clouds e Aplicaes

rando diversos aspectos do ambiente e apresentada. Esta heurstica inclui um mecanismo

para o balanceamento de carga para a distribuic ao da execuc ao de uma aplicac ao e uma es-

trat egia para criac ao de novas m aquinas virtuais. Os experimentos utilizaram o simulador

CloudSim [Calheiros et al. 2011] para cargas de trabalho heterog eneas.

No trabalho de [Pokluda et al. 2010], um framework para o gerenciamento

din amico de mem oria foi desenvolvido baseado nos conceitos de sensores e atuadores.

P aginas de mem oria foram utilizadas e ac oes foram tomadas quando necess ario. Neste

trabalho, o hipervisor OpenVZ foi utilizado.

[Oliveira 2012] utilizou uma estrat egia para alocac ao de recursos baseada em

CPU. A soluc ao apresenta um monitor, para o monitoramento da utilizac ao de CPU de

m aquinas fsicas, e um gerente, que utiliza a informac ao coletada para alocar ou desa-

locar recursos, adicionando ou removendo MVs. O Xen foi o hipervisor utilizado neste

trabalho.

[Wu et al. 2011] prop os algoritmos para a alocac ao de recursos com o objetivo de

minimizar o custo da infraestrutura e violac oes de SLA. As necessidades do cliente s ao

mapeadas para par ametros da infraestrutura, como tempo de resposta. O CloudSim foi

utilizado para simular o ambiente de Computac ao em Nuvem e executar os algoritmos

propostos para a alocac ao dos recursos.

A Tabela 1 apresenta alguns trabalhos relacionados. Nota-se que a maioria dos

trabalhos utilizou CPU ou mem oria como par ametros para a alocac ao dos recursos. A

abordagem proposta neste artigo utiliza variac ao de CPU e o hipervisor KVM, diferente

da maioria dos outros trabalhos, que utilizam o Xen. Al em disso, a arquitetura FairCPU

permite a criac ao de diferentes estrat egias, sendo que tr es delas foram avaliadas nesse

trabalho.

Tabela 1. Comparac ao entre trabalhos relacionados (M=medic ao, S=simulac ao,

MA=modelagem analtica).

Artigo Assunto Mecanismo de Alocac ao T ecnica

[Zhang et al. 2010] Aplicac ao Web (TomCat) Threads do servidor web e

mem oria

M-MA

[Heo et al. 2009] Aplicac ao Web (Apache) CPU e mem oria M-MA

[Emeakaroha et al. 2011] Aplicac ao Web e HPC /

CloudSim

Quantidade de aplicac oes

que as MVs suportam

S

[Pokluda et al. 2010] Aplicac ao Web (Apache) Mem oria M

[Oliveira 2012] Aplicac ao Web (TomCat) e

banco de dados

Uso de CPU M

[Wu et al. 2011] CloudSim Tempo de resposta e custo S

3. Soluc ao Proposta

De acordo com [Kephart and Chess 2003], um sistema auton omico compreende um con-

junto de elementos auton omicos. Um elemento auton omico e um componente res-

pons avel para o gerenciamento de seu pr oprio comportamento, em conformidade com

polticas denidas, e para interac ao com outros elementos auton omicos que prov em ou

consomem servicos computacionais.

O elemento b asico e o loop de controle, exibido na Figura 1. Este loop atua

Anais 131

Figura 1. Loop de controle.

como um gerenciador de recursos atrav es de ac oes de monitoramento, an alise e tomada

de decis ao, seguindo polticas particulares.

Um loop de controle inteligente e capaz de prover capacidades de computac ao au-

ton omica, tais como ciclos de processamento adicionais quando necess ario, atualizac oes

de software, reinicializac ao da execuc ao de uma aplicac ao ap os falhas e criac ao de bac-

kups ap os o processamento di ario [Hariri et al. 2006].

A soluc ao proposta estende a arquitetura FairCPU [Rego et al. 2011], pela adic ao

do conceito de sensor e loop de controle [Kephart and Chess 2003]. Assim, o ambiente

pode ser monitorado e a alocac ao dos recursos de CPU pode ser realizada para garantir a

QoS das aplicac oes.

A FairCPU utiliza o conceito de Unidade de Processamento (UP) para alocar os

recursos de CPU para as MVs de maneira a garantir um desempenho homog eneo, inde-

pendente da m aquina fsica subjacente e do modelo de seu processador. Desta maneira, a

arquitetura permite aos usu arios congurar o poder de processamento das MVs utilizando

uma m etrica uniforme.

A UP e a abstrac ao utilizada para representar o poder de processamento, similar

a ECU

1

(Elastic Computing Unit) da Amazon EC2. Ela pode ter um valor conhecido

em termos de GFLOPS (bilh oes de operac oes de ponto utuante por segundo), ou ou-

tra m etrica (como MIPS, MHz, etc) que possa ser utilizada para representar o poder de

processamento de cada m aquina fsica ou virtual.

A relac ao entre a soluc ao proposta e a arquitetura FairCPU pode ser visualizada na

Figura 2. A abordagem est a dividida em duas partes: Agente e Controlador Auton omico.

O Agente Auton omico e o componente presente em cada MV, que e respons avel por co-

letar dados e monitorar as aplicac oes. O Controlador Auton omico gerencia e analisa a

informac ao coletada pelo Agente em tempo real. Esta informac ao e armazenada e uti-

lizada para aumentar ou reduzir dinamicamente os recursos alocados, am de garantir o

SLA.

O Controlador Auton omico utiliza a interface disponvel pelo componente Cliente

da FairCPU, no qual est a disponvel a func ao de ajustar dinamicamente a quantidade

de recursos alocados para a MV. Um importante componente da arquitetura FairCPU

e o Gerenciador de Limites, que e o m odulo respons avel por congurar a quantidade

de recursos de CPU que podem ser utilizados pelas MVs. A implementac ao atual do

Gerenciador de Limites pode congurar o uso de CPU para os hipervisores Xen e KVM.

Mais informac ao sobre os m odulos da arquitetura FairCPU podem ser encontradas em

1

Uma ECU fornece a capacidade de CPU equivalente ` a de um processador 2007 Opteron ou 2007 Xeon

de 1,0-1,2 GHz [Amazon 2013].

132 XI Workshop de Computao em Clouds e Aplicaes

Figura 2. Vis ao geral da soluc ao proposta.

[Rego et al. 2011].

O Agente e o Controlador Auton omico foram desenvolvidos com a linguagem de

programac ao Ruby, assim como a arquitetura FairCPU e seu m odulo Cliente. Em um

trabalho pr evio, esta soluc ao foi utilizada para alocar dinamicamente recursos de CPU ` as

MVs considerando apenas a utilizac ao atual de CPU e o tempo de resposta das aplicac oes

[Rego et al. 2012].

Neste ponto, a soluc ao permite ajustar a mem oria da MV em tempo de execuc ao

e criar novas inst ancias de MVs. Al em disso, um arquivo XML com informac oes de SLA

pode ser utilizado para congurar o Controlador para tomada de decis oes. Um exemplo

do arquivo de SLA pode ser visualizado na Figura 3.

Como exemplo, a segunda linha do arquivo XML signica: a m etrica tempo de

resposta (response time) deve ser monitorada e caso seu valor seja maior do que 2 se-

gundos, a operac ao da FairCPU setpu+ deve ser chamada para aumentar a quantidade de

Unidades de Processamento em 1.

Com as novas funcionalidades implementadas, diferentes estrat egias de alocac ao

din amica de recursos podem ser desenvolvidas. Primeiro, e possvel aumentar/reduzir a

quantidade de CPU e mem oria das m aquinas virtuais para lidar com diferentes cargas de

trabalho. Neste caso, a quantidade total de CPU e mem oria da m aquina fsica subjacente

e o limite superior. Segundo, e possvel criar novas inst ancias de MVs e utilizar um

Figura 3. Exemplo do arquivo de congurac ao XML.

Anais 133

balanceador de carga para dividir a carga de trabalho entre elas. Esta estrat egia e mais

adequada para aplicac oes que utilizam um paradigma cliente/servidor, mas tamb em e

bastante interessante para aplicac oes distribudas de uso intensivo de CPU, como criar

um novo n o em um cluster virtual.

A segunda estrat egia pode ser utilizada para criar novas inst ancias de MVs tanto

com recursos locais (nuvem privada), quanto com recursos de provedores pagos de

Computac ao em Nuvem (nuvem p ublica). A abordagem mais comum e utilizar recur-

sos locais primeiramente. Entretanto, uma vez que todos os recursos locais estejam sendo

utilizados ou dependendo da funcionalidade requisitada, e possvel instanciar MVs em

nuvens p ublicas, como a Amazon EC2. Neste ponto, a soluc ao proposta pode utilizar

qualquer uma dessas estrat egias.

3.1. Polticas de Alocac ao

De acordo com [White et al. 2004], uma poltica de alocac ao especica quais medidas

devem ser tomadas sempre que o sistema alcanca determinado estado. Ela pode ser na

forma SE (condic ao) ENT

AO (ac ao), onde uma condic ao caracteriza um estado ou um

conjunto de estados. Um exemplo de poltica de ac ao e SE (tempo de resposta m edio do

servidor web for maior que 500 ms) ENT

AO (adicionar um novo servidor web). O pro-

blema com polticas de ac ao e que quando uma s erie de polticas de ac ao e especicada,

isto diculta a identicac ao de conitos que podem surgir entre as polticas.

Por exemplo, em um sistema multi-camadas, se um servidor web e uma aplicac ao

requerem recursos adicionais e os recursos disponveis s ao insucientes para ambos, um

conito surge. Para lidar com tais conitos, o sistema necessita de polticas de resoluc ao

de conitos, como dar uma prioridade maior para o servidor. Entretanto, como conitos

geralmente surgem em tempo de execuc ao, e difcil especicar polticas de resoluc ao.

Decidir qual e a melhor poltica de resoluc ao de conitos n ao est a no escopo deste

trabalho. O objetivo deste trabalho e apresentar uma arquitetura e estrat egias de alocac ao

din amicas. Considerando um ambiente hbrido, existem tr es possveis estrat egias: (1)

elasticidade vertical, pelo aumento/reduc ao dos recursos alocados; (2) elasticidade hori-

zontal, pela criac ao de MVs em uma nuvem privada; e (3) elasticidade horizontal, com a

criac ao de MVs em um ambiente de nuvem p ublica.

4. Metodologia de Avaliac ao

A metodologia para avaliac ao da soluc ao utilizada neste trabalho segue [Jain 1991]. A

Tabela 2 detalha as caractersticas relacionadas ao planejamento dos experimentos, assim

como m etricas e cargas de trabalho.

Uma nuvem privada heterog enea criada com o gerenciador de nuvem OpenNe-

bula

2

vers ao 3.8 foi utilizada como testbed, consistindo de 1 m aquina do tipo Ci5, 2

m aquinas do tipo Ci7 e 1 m aquina do tipo X4, todas conectadas por uma rede Gigabit

Ethernet. As congurac oes das m aquinas fsicas s ao apresentadas na Tabela 3.

Todas as m aquinas fsicas utilizaram o sistema operacional Ubuntu Server 12.04

64 bits e o hipervisor KVM. Para todos os experimentos, as MVs com os geradores de

carga foram executados na m aquina do tipo Ci5 com 4 UPs, a MV com o balanceador de

2

http://opennebula.org

134 XI Workshop de Computao em Clouds e Aplicaes

Tabela 2. Projeto de experimentos

Caractersticas Descric ao

Sistema Ambiente privado de Computac ao em Nuvem (Open

Nebula) e provedor de nuvem p ublica (Amazon EC2)

M etricas Tempo de resposta, tempo do experimento,

requisic oes perdidas

Par ametros CPU, mem oria, MVs, inst ancias da Amazon do tipo

(xsmall)

Fatores UP, congurac ao do httperf (quantidade de

requisic oes, taxa de requisic oes, tempo)

T ecnica de Avaliac ao Medic ao

Carga de Trabalho Carga de trabalho do httperf

Projeto de Experimentos O experimento consiste da gerac ao da carga de traba-

lho com o httperf no servidor web Apache para que

dinamicamente se ad eque ` a quantidade de CPU ou

` as MVs. Este experimento ser a executado em uma

nuvem privada e em um provedor p ublico de nuvem

(soluc ao hbrida)

An alise dos Dados Interpretac ao dos resultados descritos nos gr acos

Apresentac ao dos Resultados Gr aco de barras

Tabela 3. Congurac ao das m aquinas fsicas.

Tipo de M aquina Processador Mem oria

X4 Intel Xeon X3430 @ 2.4 GHz 8 GB

Ci5 Intel Core i5-750 @ 2.66 GHz 4 GB

Ci7 Intel Core i7-930 @ 2.8 GHz 24 GB

carga foi executada na m aquina do tipo X4 com 4 UPs, e as MVs com a aplicac ao PHP e o

servidor web Apache foramexecutadas nas m aquinas do tipo Ci7 comumn umero vari avel

de UPs. Todas as MVs possuam 2 VCPUs, 1 GB de mem oria e o sistema operacional

Ubuntu Server 12.04 64 bits.

Para simplicar os experimentos, a UP foi denida como 50% de um n ucleo do

processador da m aquina fsica do tipo Ci7. Assim, 1 UP e igual a 50% da capacidade da

CPU, 2 UPs equivalem a 100% da capacidade

3

da CPU, e assim por diante.

5. Experimentos

Os experimentos foram projetados para serem executados em dois ambientes: nuvem

privada construda com o OpenNebula e nuvem p ublica da Amazon. Para ambos os am-

bientes, as mesmas ferramentas foram utilizadas. O servidor web Apache foi instalado e

congurado em uma MV e uma pequena aplicac ao web em PHP foi desenvolvida para

gerar o consumo de recursos. A ferramenta httperf

4

foi utilizada como gerador de cargas

de trabalho sobre essa aplicac ao. O balanceador de carga Nginx

5

e o Agente Auton omico

3

Considerando que um processador com 4 n ucleos tem capacidade de 400%.

4

http://www.hpl.hp.com/research/linux/httperf

5

http://nginx.org

Anais 135

foram instalados em outra MV.

O tempo de resposta da aplicac ao para cada requisic ao foi coletado e armazenado

para tomada de decis ao posterior. Um script, escrito em Ruby, l e o arquivo de log do

Nginx a cada 5 segundos para coletar detalhes sobre as requisic oes.

O gr aco na Figura 4 descreve o comportamento da carga de trabalho utilizada

pelo httperf. Pode-se vericar que cada taxa foi aplicada por 2 minutos e inicia com

2 requisic oes por segundo, incrementando em 1 at e 6 requisic oes por segundo, quando

inicia a decair at e completar 14 minutos de experimento. A mesma carga de trabalho foi

aplicada aos tr es experimentos, num total de 3480 requisic oes por experimento.

Figura 4. Variac ao da carga de trabalho do httperf com o tempo.

5.1. Experimento 1 - Nuvem Privada e Elasticidade Vertical

Neste experimento o tempo de resposta foi utilizado para a tomada de decis ao. Foi esta-

belecido como limite superior o tempo de resposta de 2 segundos, como pode ser visto

no XML da Figura 5. Inicialmente a quantidade de UPs e igual a 1 e quando o limite for

excedido, o n umero de UPs deve ser aumentado em 1.

Figura 5. Arquivo de congurac ao XML para o primeiro experimento.

A Figura 6 apresenta o tempo de resposta da aplicac ao sobre o tempo. Este

tempo de resposta aumenta entre os minutos 6 e 8 pois a taxa do httperf atinge 5

requisic oes/segundo. A estrat egia selecionada incrementa rapidamente a quantidade de

UPs e o tempo de resposta estabiliza, retornando ao valor esperado. Para este experi-

mento, 13 requisic oes foram perdidas at e o sistema se adaptar.

5.2. Experimento 2 - Nuvem Privada com Elasticidade Horizontal

Neste experimento, n ao deve haver variac ao na quantidade de CPU alocada para as MVs.

Quando o limite for excedido, uma nova MV e instanciada e o balanceador de carga

136 XI Workshop de Computao em Clouds e Aplicaes

Figura 6. Tempo de resposta para o experimento com elasticidade vertical.

inclui o IP da nova MV na sua lista de redirecionamento. Assim, a nova MV pode receber

requisic oes.

A Figura 7 apresenta o arquivo XML de congurac ao para este experimento. A

MV que ser a criada deve ser do tipo 2 (n umero que identica o modelo da MV que deve

ser criada pelo OpenNebula). Este modelo de MV foi criado previamente.

Figura 7. Arquivo de congurac ao XML para o segundo experimento.

A Figura 8 apresenta o tempo de resposta da aplicac ao com o tempo. Diferente-

mente do experimento anterior, o tempo de resposta foi maior que o ideal, devido ao fato

do tempo de criac ao da MVser maior que tempo necess ario para incrementar a quantidade

de UPs. Neste experimento, 218 requisic oes foram perdidas.

Figura 8. Tempo de resposta para o experimento com elasticidade horizontal em

recursos locais.

5.3. Experimento 3 - Nuvem Hbrida e Elasticidade Horizontal

Para este experimento, uma nuvem privada com o OpenNebula tamb em foi utilizada com

uma MV com o httperf, outra MV para o Nginx e outra para a aplicac ao PHP. Quando o

Anais 137

limite para o tempo de resposta e ultrapassado, uma nova MV deve ser inicializada em

uma nuvem p ublica e o balanceador de carga deve incluir seu endereco IP na lista de

redirecionamento, para que ela possa receber requisic oes.

O provedor p ublico de nuvem escolhido foi a Amazon EC2. A inst ancia utilizada

foi do tipo xsmall, com 1 VCPU (1 ECU) e 1.7 GB de mem oria. O arquivo XML de

congurac ao (Figura 9) indica que a MV deve ser criada. O modelo da MV a ser criada

tem o identicador 7 e foi congurado previamente no OpenNebula, com a identicac ao

da AMI (Amazon Machine Image), o tipo de inst ancia, regi ao e zona da Amazon.

Figura 9. Arquivo de congurac ao XML para o terceiro experimento.

A Figura 10 apresenta o tempo de resposta sobre o tempo. Para este experimento,

671 requisic oes foram perdidas devido ao fato da criac ao da MV na Amazon demorar

mais de 2 minutos.

Figura 10. Tempo de resposta para o experimento com elasticidade horizontal

em recursos p ublicos.

5.4. Discuss ao dos Resultados

Comparando as Figuras 6, 8 e 10, e possvel vericar um comportamento similar na

variac ao do tempo de resposta. Os tr es experimentos iniciaram com um baixo tempo

de resposta (menor que 1 segundo) e aproximadamente na metade do experimento (entre

o sexto e o oitavo minuto) h a um grande pico no tempo de resposta. Este aumento no

tempo de resposta se deve ao acr escimo da taxa de requisic oes por segundo, que atingiu

uma carga de trabalho que n ao era suportada pelo servidor. Neste momento, dependendo

da estrat egia do experimento, uma ac ao era tomada no ambiente.

O Experimento 1 obteve o melhor resultado, pois a alterac ao din amica da quanti-

dade de CPU da m aquina virtual e feita de forma r apida. Os experimentos 2 e 3 obtiveram

resultados piores, pois uma nova MV precisou ser criada em ambos. O Experimento 2

obteve um resultado melhor do que o Experimento 3, pois a MV e criada mais r apido na

infraestrutura local.

13 XI Workshop de Computao em Clouds e Aplicaes

A quantidade de pacotes perdidos no Experimento 3 e bem maior, uma vez que,

com o aumento da carga de trabalho, o servidor cou sobrecarregado e os pacotes foram

considerados perdidos quando o tempo de resposta estava acima de 7 segundos. Como a

criac ao da MV extra foi mais demorada na nuvem p ublica, o servidor cou sobrecarre-

gado por mais tempo, e, por isso, mais pacotes foram perdidos. Pode-se notar tamb em

que, depois do minuto 12, h a um pequeno pico no tempo de resposta, mais not orio nos ex-

perimentos 2 e 3. Esses picos s ao resultados da remoc ao da MV extra e recongurac ao do

balanceador de carga. Como a taxa de requisic oes caiu, o tempo de resposta tamb em caiu

e uma ac ao foi disparada. Uma vez que tempo de resposta n ao ultrapassou 7 segundos,

n ao houve perda de pacotes nesse momento.

6. Conclus ao

Este trabalho apresenta estrat egias para alocac ao de recursos em ambientes de

Computac ao em Nuvem baseados na alocac ao din amica de CPU e a criac ao de MVs

(elasticidade vertical e horizontal). Uma soluc ao baseada na arquitetura FairCPU foi uti-

lizada para testar diferentes formas de garantir a qualidade do servico de aplicac oes web.

Este trabalho explorou diferentes ambientes, em especial uma nuvem hbrida im-

plementada com o gerenciador de nuvem OpenNebula, para que fosse possvel criar MVs

numa infraestrutura local e na nuvem da Amazon. A utilizac ao de uma soluc ao que au-

tomaticamente (1) incrementa e decrementa recursos de uma MV e (2) cria MVs, seja na

nuvem privada ou na nuvem p ublica, foi uma atividade muito importante. Esta atividade

nos permitiu explorar a arquitetura FairCPU e suas funcionalidades, bem como vislum-

brar diferentes formas de adaptar os recursos de uma aplicac ao ` as mudancas de cargas de

trabalho.

Um trabalho futuro vislumbrado seria misturar a elasticidade vertical e horizontal

para criar uma estrat egia hbrida. Uma ideia interessante e utilizar escalabilidade vertical

durante a criac ao das MVs (seja na nuvem privada, seja na nuvem p ublica) e assim evitar

violac oes do SLA durante esse intervalo de tempo. T ao logo a MV seja criada, os recur-

sos adicionados podem ser removidos. Al em disso, utilizar uma t ecnica preditiva para a

tomada de decis oes pode ajudar a diminuir a quantidade de pacotes perdidos, uma vez que

a tomada de decis ao seria feita antes do servico sobrecarregar. Outros possveis trabalhos

futuros est ao relacionados ` a utilizac ao de outros provedores de nuvens p ublicas, como a

HP Cloud Services, al em de realizar experimentos mais complexos, com a utilizac ao de

outras m etricas para an alise de desempenho, e a formulac ao de um modelo de custo para

avaliar a soluc ao hbrida.

Refer encias

Amazon (2013). Amazon web services. http://aws.amazon.com/pt/. Online; acessado em

marco-2013.

Calheiros, R. N., Ranjan, R., Beloglazov, A., De Rose, C. A. F., and Buyya, R. (2011).

Cloudsim: a toolkit for modeling and simulation of cloud computing environments and

evaluation of resource provisioning algorithms. Software: Practice and Experience,

41(1):2350.

Anais 139

Emeakaroha, V., Brandic, I., Maurer, M., and Breskovic, I. (2011). Sla-aware application

deployment and resource allocation in clouds. In Computer Software and Applications

Conference Workshops (COMPSACW), 2011 IEEE 35th Annual, pages 298 303.

Gong, Z., Gu, X., and Wilkes, J. (2010). Press: Predictive elastic resource scaling for

cloud systems. In Network and Service Management (CNSM), 2010 International

Conference on, pages 9 16.

Hariri, S., Khargharia, B., Chen, H., Yang, J., Zhang, Y., Parashar, M., and Liu, H. (2006).

The autonomic computing paradigm. Cluster Computing, 9(1):517.

Heo, J., Zhu, X., Padala, P., and Wang, Z. (2009). Memory overbooking and dynamic

control of xen virtual machines in consolidated environments. In Integrated Network

Management, 2009. IM 09. IFIP/IEEE International Symposium on, pages 630 637.

Jain, R. (1991). The Art of Computer Systems Performance Analysis: Techniques for

Experimental Design, Measurement, Simulation, and Modeling. John Wiley and Sons,

INC, 1st edition.

Kephart, J. O. and Chess, D. M. (2003). The vision of autonomic computing. Computer,

36(1):4150.

Oliveira, C. (2012). An architecture for experimentation with multi-tier internet appli-

cations in virtualized server environments. In II Workshop de Sistemas Distribudos

Auton omicos.

Pokluda, A., Keller, G., and Lutyya, H. (2010). Managing dynamic memory allocations

in a cloud through golondrina. In Systems and Virtualization Management (SVM), 2010

4th International DMTF Academic Alliance Workshop on, pages 7 14.

Rego, P. A. L., Coutinho, E. F., de Carvalho Sousa, F. R., and de Souza, J. N. (2012).

Alocac ao auton omica de recursos para m aquinas virtuais baseada em caractersticas

de processamento. In II Workshop de Sistemas Distribudos Auton omicos.

Rego, P. A. L., Coutinho, E. F., Gomes, D. G., and de Souza, J. N. (2011). Architecture for

allocation of virtual machines using processing features. In 1st International Workshop

on Cloud Computing and Scientic Applications (CCSA).

White, S., Hanson, J., Whalley, I., Chess, D., and Kephart, J. (2004). An architectu-

ral approach to autonomic computing. In Autonomic Computing, 2004. Proceedings.

International Conference on, pages 2 9.

Wu, L., Garg, S., and Buyya, R. (2011). Sla-based resource allocation for software as a

service provider (saas) in cloud computing environments. In Cluster, Cloud and Grid

Computing (CCGrid), 2011 11th IEEE/ACM International Symposium on, pages 195

204.

Zhang, Y., Huang, G., Liu, X., and Mei, H. (2010). Integrating resource consumption and

allocation for infrastructure resources on-demand. In Cloud Computing (CLOUD),

2010 IEEE 3rd International Conference on, pages 75 82.

Anda mungkin juga menyukai

- Desenvolvimento De Software Ii C# Programação Em CamadasDari EverandDesenvolvimento De Software Ii C# Programação Em CamadasBelum ada peringkat

- Computação em Nuvem1Dokumen9 halamanComputação em Nuvem1AlfredoBelum ada peringkat

- #6 - Computação em NuvemDokumen18 halaman#6 - Computação em NuvemSamuel RobertoBelum ada peringkat

- Implantac Ao de Uma Infraestrutura de Nuvem Usando OpenstackDokumen3 halamanImplantac Ao de Uma Infraestrutura de Nuvem Usando Openstackubiratam123Belum ada peringkat

- Pacheco 2017 1 9Dokumen10 halamanPacheco 2017 1 9onlytst tstBelum ada peringkat

- Apostila - Módulo 1 - Bootcamp Engenheiro (A) de Dados CloudDokumen35 halamanApostila - Módulo 1 - Bootcamp Engenheiro (A) de Dados Cloud5923Belum ada peringkat

- ListaExercicios P2 20231Dokumen5 halamanListaExercicios P2 20231Alan AugustoBelum ada peringkat

- EpaNet GridDokumen15 halamanEpaNet GridJessica SantosBelum ada peringkat

- Computação de Alto Desempenho - Cluster e GradeDokumen10 halamanComputação de Alto Desempenho - Cluster e GradeRaphael Lugon Campo Dall'OrtoBelum ada peringkat

- ESw Comp NuvemDokumen38 halamanESw Comp NuvemBruno WilsonBelum ada peringkat

- Em Direção A Uma Ferramenta para A Realização de de FunçõesDokumen24 halamanEm Direção A Uma Ferramenta para A Realização de de FunçõesVinicius Cardoso GarciaBelum ada peringkat

- AWS Cloud Best PracticesDokumen23 halamanAWS Cloud Best PracticeshebsonaraujoBelum ada peringkat

- Artigo BSBR 1Dokumen10 halamanArtigo BSBR 1Cainan TeixeiraBelum ada peringkat

- Relatorio Parcial1 WendelDokumen8 halamanRelatorio Parcial1 WendelWendel BarbosaBelum ada peringkat

- Mapa - Gerência de Infraestrutura - ConcluídoDokumen13 halamanMapa - Gerência de Infraestrutura - ConcluídoCleudimar MoraesBelum ada peringkat

- Artigo Mundo UNIFOR - Modelagem de Aplicações em Nuvens de InfraestruturaDokumen5 halamanArtigo Mundo UNIFOR - Modelagem de Aplicações em Nuvens de InfraestruturaPhilipp CostaBelum ada peringkat

- 157 20071 1 10 20230527Dokumen14 halaman157 20071 1 10 20230527mlkdd1988Belum ada peringkat

- TCC Rennan Formatacao-Final-1Dokumen29 halamanTCC Rennan Formatacao-Final-1Leandro Souza de Lima SilvaBelum ada peringkat

- Artigo 04Dokumen10 halamanArtigo 04Enea SepBelum ada peringkat

- Alcídio Alimo Virtualizacao&cloud ComputingDokumen14 halamanAlcídio Alimo Virtualizacao&cloud ComputingAlcidio AmericoBelum ada peringkat

- 8 - Implantação Dos Serviços de NuvemDokumen31 halaman8 - Implantação Dos Serviços de NuvemSamuel RobertoBelum ada peringkat

- Artigo BSBR 2Dokumen11 halamanArtigo BSBR 2Cainan TeixeiraBelum ada peringkat

- 243 1019 1 PBDokumen10 halaman243 1019 1 PBRafael EscalfoniBelum ada peringkat

- Implementação E Avaliação de Algoritmos de Ordenação Paralela em MapreduceDokumen8 halamanImplementação E Avaliação de Algoritmos de Ordenação Paralela em Mapreducefernando souzaBelum ada peringkat

- Ambiente de Computação em Nuvem - Google CloudDokumen43 halamanAmbiente de Computação em Nuvem - Google CloudElaynne M. SilvaBelum ada peringkat

- O Que É e para Que Serve o Balanceamento de CargaDokumen6 halamanO Que É e para Que Serve o Balanceamento de CargazansuedBelum ada peringkat

- Analise de Valor para A DeterminacaoDokumen6 halamanAnalise de Valor para A DeterminacaoGABRIEL BRAGABelum ada peringkat

- Relatório - Migração de Aplicações Via CloudStep.Dokumen16 halamanRelatório - Migração de Aplicações Via CloudStep.Jonas Luz Jr.Belum ada peringkat

- Computação NuvemDokumen81 halamanComputação NuvemBarry AllenBelum ada peringkat

- Cluster de ComputadoresDokumen7 halamanCluster de ComputadoresADDNBelum ada peringkat

- Ebook Jornada para Nuvem Atlzd 01 02 23 2Dokumen16 halamanEbook Jornada para Nuvem Atlzd 01 02 23 2dogreisBelum ada peringkat

- 2011 Migração de Experimentos Científicos para A NuvemDokumen4 halaman2011 Migração de Experimentos Científicos para A NuvemEduardo Cotrin TeixeiraBelum ada peringkat

- PreProjeto REDES 5 PeriodoDokumen12 halamanPreProjeto REDES 5 PeriodoEder RodriguesBelum ada peringkat

- O Uso de Simuladores No Ensino de Redes de ComputadoresDokumen12 halamanO Uso de Simuladores No Ensino de Redes de ComputadoresarquivonacionalBelum ada peringkat

- Telefonia Cruzeiro Do SulDokumen20 halamanTelefonia Cruzeiro Do SuladrsysBelum ada peringkat

- Portifolio Computação em NuvemDokumen8 halamanPortifolio Computação em NuvemOdair MattosBelum ada peringkat

- Virtualização e NuvemDokumen14 halamanVirtualização e NuvemPaulo SantanaBelum ada peringkat

- Virtualização de Servidores para Otimização de RecursosDokumen11 halamanVirtualização de Servidores para Otimização de RecursosMarcos de Paula CougoBelum ada peringkat

- Clagtee Paper Code2009Dokumen21 halamanClagtee Paper Code2009Lélis MurakamiBelum ada peringkat

- 2013 EC Ettore Simioni NetoDokumen123 halaman2013 EC Ettore Simioni NetoCarlos SiqueiraBelum ada peringkat

- Computacao em Nuvem Realtorio de Aula Pratica EnvioDokumen9 halamanComputacao em Nuvem Realtorio de Aula Pratica EnvioIdeia AssessoriaBelum ada peringkat

- Segurança em Computação de NuvemDokumen7 halamanSegurança em Computação de NuvemPedro B Schlindwein NiederleBelum ada peringkat

- 02 - Descrever Os Benefícios Da Computação em Nuvem - Learn - Microsoft DocsDokumen3 halaman02 - Descrever Os Benefícios Da Computação em Nuvem - Learn - Microsoft DocsJulio CesarioBelum ada peringkat

- Servidores Virtualizados Estudo para A Empresa Oficina CabralzinhoDokumen9 halamanServidores Virtualizados Estudo para A Empresa Oficina CabralzinhoCesar Augusto Della PiazzaBelum ada peringkat

- Definição Do ProblemaDokumen12 halamanDefinição Do ProblemaHugo GustavoBelum ada peringkat

- Comp Nuvem SerraDokumen26 halamanComp Nuvem SerraAristene CorreiaBelum ada peringkat

- Ebook Cloud Computing v1.0 CapaDokumen14 halamanEbook Cloud Computing v1.0 CapaocededBelum ada peringkat

- Apache Cayenne - Persistência de DadosDokumen31 halamanApache Cayenne - Persistência de DadosAnderson KerllyBelum ada peringkat

- Portifolio Computaçao em NuvemDokumen8 halamanPortifolio Computaçao em NuvemJhonathan S. MeloBelum ada peringkat

- Apostila Cloud Computing v1.1Dokumen32 halamanApostila Cloud Computing v1.1xlilianBelum ada peringkat

- Guia Da Computacao em NuvemDokumen50 halamanGuia Da Computacao em Nuvemmarconiljunior2001Belum ada peringkat

- VF Whitepaper CloudDokumen8 halamanVF Whitepaper CloudQualificação ProjetoBelum ada peringkat

- Cordeiro 2014 VerDokumen12 halamanCordeiro 2014 VerTerukoKajiharaBelum ada peringkat

- Conceitos e Aplicacoes Da Computacao emDokumen5 halamanConceitos e Aplicacoes Da Computacao emGerhard SaboiaBelum ada peringkat

- Exercicio ClusterDokumen3 halamanExercicio ClusterRenato Bernardes PereiraBelum ada peringkat

- Curso Azure 900 (Recuperação Automática)Dokumen83 halamanCurso Azure 900 (Recuperação Automática)Paula CantuárioBelum ada peringkat

- Abare Um Framework para Implantação Monitoramento e Gerenciamento Coordenado e Autonomo para Redes em Malha Sem FioDokumen14 halamanAbare Um Framework para Implantação Monitoramento e Gerenciamento Coordenado e Autonomo para Redes em Malha Sem Fiorafaeltelematica2185Belum ada peringkat

- KAHOOT Manual Do Docente UNIFAJDokumen39 halamanKAHOOT Manual Do Docente UNIFAJKrícia BarretoBelum ada peringkat

- Comp Brasil 2015 4 PDFDokumen58 halamanComp Brasil 2015 4 PDFaguiark510Belum ada peringkat

- Procedimentos para Uso Da Antena No VirtualboxDokumen1 halamanProcedimentos para Uso Da Antena No Virtualboxrafaeltelematica2185Belum ada peringkat

- Zenoss CoreDokumen64 halamanZenoss CoreJhonnatta124Belum ada peringkat

- Aula 1.0 Introdução e FCAPSDokumen39 halamanAula 1.0 Introdução e FCAPSrafaeltelematica2185Belum ada peringkat

- Reconguração de Ambientes Virtualizados Através Do Uso de Teste Baseado em Modelos e SLAsDokumen12 halamanReconguração de Ambientes Virtualizados Através Do Uso de Teste Baseado em Modelos e SLAsrafaeltelematica2185Belum ada peringkat

- Rede MeshDokumen6 halamanRede Meshfreehand100% (2)

- Provisionamento de QoS em Redes Ad Hoc Sem Fio Utilizando Medição de Retardo de Enlace TCC WevertonDokumen102 halamanProvisionamento de QoS em Redes Ad Hoc Sem Fio Utilizando Medição de Retardo de Enlace TCC Wevertonrafaeltelematica2185Belum ada peringkat

- Análise Do Impacto de Migração de MVs em Ambiente Comp. VirtDokumen14 halamanAnálise Do Impacto de Migração de MVs em Ambiente Comp. Virtrafaeltelematica2185Belum ada peringkat

- Um Estudo de Voz Sobre IP em Redes em Malha 802.11 - Dissertacao - EduardoDokumen103 halamanUm Estudo de Voz Sobre IP em Redes em Malha 802.11 - Dissertacao - Eduardorafaeltelematica2185Belum ada peringkat

- (B@699c29.Pdfprova InformaticaDokumen13 halaman(B@699c29.Pdfprova InformaticaBob CruzBelum ada peringkat

- Infraestrutura de Comunicação em Malha Sem Fio para Supervisão PDFDokumen10 halamanInfraestrutura de Comunicação em Malha Sem Fio para Supervisão PDFrafaeltelematica2185Belum ada peringkat

- Avaliacão de Estratégias de Balanceamento de Carga Do Tipo Mestre Escravo PDFDokumen8 halamanAvaliacão de Estratégias de Balanceamento de Carga Do Tipo Mestre Escravo PDFrafaeltelematica2185Belum ada peringkat

- Código 05 (Prova)Dokumen4 halamanCódigo 05 (Prova)rafaeltelematica2185Belum ada peringkat

- Infraestrutura de Comunicação em Malha Sem Fio para Supervisão PDFDokumen10 halamanInfraestrutura de Comunicação em Malha Sem Fio para Supervisão PDFrafaeltelematica2185Belum ada peringkat

- Arquitetura de Escalonamento Ortogonal de Tempo-Real para Garantias de QoS em Servicos Web PDFDokumen20 halamanArquitetura de Escalonamento Ortogonal de Tempo-Real para Garantias de QoS em Servicos Web PDFrafaeltelematica2185Belum ada peringkat

- 4 Tipos Estruturados E TAD PDFDokumen31 halaman4 Tipos Estruturados E TAD PDFrafaeltelematica2185Belum ada peringkat

- Raciocínio Lógico Do STJ 2008Dokumen7 halamanRaciocínio Lógico Do STJ 2008rafaeltelematica2185Belum ada peringkat

- PDC - Pós-Graduação em Desenvolvimento Full Stack-2Dokumen16 halamanPDC - Pós-Graduação em Desenvolvimento Full Stack-2Thiago FelipeBelum ada peringkat

- Ebook Telemedicine - BrazilDokumen25 halamanEbook Telemedicine - BrazilleserraoBelum ada peringkat

- TCC ModeloDokumen19 halamanTCC ModeloRafael NgungaBelum ada peringkat

- Desafio Do Módulo 1 - 2022-5A - Bootcamp - Profissional Azure Cloud ComputingDokumen8 halamanDesafio Do Módulo 1 - 2022-5A - Bootcamp - Profissional Azure Cloud ComputingIgor de Oliveira SantosBelum ada peringkat

- BackOffice Linha Protheus - 2T2022Dokumen26 halamanBackOffice Linha Protheus - 2T2022andre.zingraBelum ada peringkat

- Portifólio WatizeDokumen3 halamanPortifólio WatizeAlex CubaBelum ada peringkat

- Computação em Nuvem - 3 - Fundamentos de Computação em NuvemDokumen38 halamanComputação em Nuvem - 3 - Fundamentos de Computação em NuvemEvandro CelsoBelum ada peringkat

- EBOOK RENATO - 18 Segredos - 9 PDFDokumen66 halamanEBOOK RENATO - 18 Segredos - 9 PDFRondineli AnssiniBelum ada peringkat

- Manuteno Industrial - Unidade IIIDokumen41 halamanManuteno Industrial - Unidade IIIMatheus MedeirosBelum ada peringkat

- 1637937358229-Portfolio Arvut Seguranca Do TrabalhoDokumen22 halaman1637937358229-Portfolio Arvut Seguranca Do TrabalhoDepartamento Pessoal BocchiBelum ada peringkat

- CV Kassio AtualDokumen1 halamanCV Kassio AtualKassio MendesBelum ada peringkat

- Curso 125786 Aula 03 v5Dokumen181 halamanCurso 125786 Aula 03 v5Falcão FBBelum ada peringkat

- SIMULADOGABARITODokumen23 halamanSIMULADOGABARITOnataliaBelum ada peringkat

- Book Inevitável Kevin KellyDokumen29 halamanBook Inevitável Kevin KellyMiro MachadoBelum ada peringkat

- Proposta Confix BagaggioDokumen3 halamanProposta Confix Bagaggioth instalaçõesBelum ada peringkat

- CipherTrust Data Security PlatformDokumen49 halamanCipherTrust Data Security PlatformFelipe BragaBelum ada peringkat

- Apostila de Google DriveDokumen14 halamanApostila de Google DriveVictor SartiniBelum ada peringkat

- Consulplan 2023 Prefeitura de Nova Friburgo RJ Agente de Combate As Endemias ProvaDokumen16 halamanConsulplan 2023 Prefeitura de Nova Friburgo RJ Agente de Combate As Endemias ProvaBrenda GleikBelum ada peringkat

- HOWTO Migration ToolDokumen37 halamanHOWTO Migration ToolCarlos Alexandre MansurBelum ada peringkat

- 2018 EC Rafael NardiDokumen89 halaman2018 EC Rafael NardiCarlos SiqueiraBelum ada peringkat

- PAN Summary Specsheet PTBRDokumen3 halamanPAN Summary Specsheet PTBRMichel AlmeidaBelum ada peringkat

- PI Parte02 CompletoDokumen22 halamanPI Parte02 CompletoVinícius ValençaBelum ada peringkat

- PC - PBDokumen417 halamanPC - PBANACILIA CASTRO100% (1)

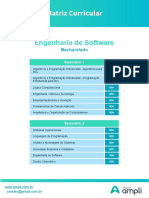

- Matriz - Curricular - Engenharia - de - Software AMPLIDokumen60 halamanMatriz - Curricular - Engenharia - de - Software AMPLIHUGO SOARESBelum ada peringkat

- Coletânea Cezar Taurion - Cloud ComputingDokumen228 halamanColetânea Cezar Taurion - Cloud ComputingSimone Saulo Sousa80% (5)

- Arcserve UDP 7.0 What's New Datasheet (BR)Dokumen2 halamanArcserve UDP 7.0 What's New Datasheet (BR)marcelowincklersimorBelum ada peringkat

- TCC - Carlos e Luiz - MicroserviçosDokumen17 halamanTCC - Carlos e Luiz - MicroserviçosSI Gestao PrincipalBelum ada peringkat

- ATIVIDADE PRATICA FeitaaDokumen8 halamanATIVIDADE PRATICA FeitaarenataBelum ada peringkat

- Folder CyberSegurançaDokumen1 halamanFolder CyberSegurançaTadeu PaesBelum ada peringkat

- Apostila-AZ900-2.3 InglêsDokumen23 halamanApostila-AZ900-2.3 Inglêsrenan silvaBelum ada peringkat