Markov

Diunggah oleh

rikardogonzalezcJudul Asli

Hak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

Markov

Diunggah oleh

rikardogonzalezcHak Cipta:

Format Tersedia

Por ejemplo si se tiene la siguiente cadena de Markov de dos estados

0.5

0.5

0.6

0.4

De los estados del diagrama tenemos la siguiente matriz:

0.5

0.5

0.4

0.6

P=

Para encontrar P(k), se necesita Pk, que puede ser encontrada con una tcnica

como la de Cayley-Hamilton(este modelo es aplicado para una matriz 2x2, no

se sabe cual es el modelo para otro tipo de matriz).

Pk=

((0.1)k-1-1)I

9

(10-(0.1) k-1)P

9

Donde I es la matriz identidad. Pk puede ser evaluada para un k especifico,

entonces :

P(k) =

P(0)Pk

En un caso de inters particular es en el que k tiende al infinito. Para este

ejemplo:

4/9

5/9

Pk=

4/9

5/9

Con k tendiendo al infinito.

Claramente, Pk llega a una constante. Esto conlleva a otra propiedad la que

puede ser vista con el rotulo de P(0)=(1

0). Entonces P k=[4/9

5/9] con k

tendiendo al infinito. Similarmente, si P(0)=(0 1), entonces P(k) con k tendiendo

al infinito sigue siendo igual. As, los limites de las probabilidades de estado son

independientes del estado inicial. Muchos procesos de Markov presentan esta

propiedad y son relacionados como procesos ergdicos.

1.1. CLASIFICACIN DE LOS ESTADOS

Limite de las probabilidades de estado:

Si k tiende a infinito, P(k) llega a una constante, entonces el limite de las

probabilidades de estado existe y son independientes de la condicin

inicial.

Si es un vector 1 x m definido como,

Limkinfinito P(k)=

Entonces puede satisfacer =P.

Para el ejemplo, esta ecuacin se puede ser resueltacon la restriccin

im =1

i

para obtener (12)

Estado transitorio

Si es un estado transitorio si se puede dejar el estado pero nunca retornar

a l.

Estado absorbente

Si es un estado absorbente si el sistema entra al estado y permanece ah.

Y el limite de la probabilidad de estado es 1. este estado es conocido

tambin como estado trampa.

Cadena recurrente

Una cadena recurrente es un conjunto de estados de los que el sistema

no puede salir. Un estado transitorio conduce al sistema dentro de este

conjunto de estados. El sistema hace saltos dentro de este conjunto

indefinidamente. La cadena recurrente es tambin llamada subcadena de

Markov irreducible o de clases recurrentes.

Finalmente se presentan unos tiles factores de las cadenas de Markov:

Cada cadena de Markov debe tener al menos una cadena recurrente

Una cadena recurrente es un estado absorbente generalizado

Un proceso de Markov que tiene una cadena recurrente ser

completamente ergdica desde dondequiera que el inicie finalizara en

cadena recurrente

Si un proceso tiene dos o ms cadenas recurrentes, entonces la

propiedad ergdica no se mantiene en el tiempo

Un estado transitorio es un estado que ocupa el sistema antes de

convertirse en una cadena recurrente

Anda mungkin juga menyukai

- Diferencias Entre Liderazgo y GestionDokumen2 halamanDiferencias Entre Liderazgo y GestionezarauzBelum ada peringkat

- Programa de Entrenamiento para Carreras de Medio FondoDokumen20 halamanPrograma de Entrenamiento para Carreras de Medio Fondoneubert martinez100% (1)

- Simbología en RefrigeraciónDokumen1 halamanSimbología en RefrigeraciónVianey Guadalupe75% (8)

- 4.5 IncotermsDokumen10 halaman4.5 IncotermsSOFIA GABRIELA SERRANO GURROLABelum ada peringkat

- Modulo 2 OrientaciónDokumen21 halamanModulo 2 OrientaciónBerta SanjurBelum ada peringkat

- Arreglos de ResistenciaDokumen6 halamanArreglos de ResistenciaEdgar AscencioBelum ada peringkat

- Informe Diagnostico (Parque San Cristobal) PDFDokumen10 halamanInforme Diagnostico (Parque San Cristobal) PDFArnold VillarBelum ada peringkat

- GC La Ecuación ContableDokumen17 halamanGC La Ecuación ContableLuis Leo DomBelum ada peringkat

- Diseño de Conexiones y Elementos en Estructuras de GuaduaDokumen12 halamanDiseño de Conexiones y Elementos en Estructuras de Guaduaandres tenorioBelum ada peringkat

- Test 3Dokumen10 halamanTest 3Segundo PicoBelum ada peringkat

- 4 Operaciones Con Monomios IIDokumen23 halaman4 Operaciones Con Monomios IIAna CuentalBelum ada peringkat

- GUIA DE TRABAJO Grado 11 #2Dokumen5 halamanGUIA DE TRABAJO Grado 11 #2BJR destrodBelum ada peringkat

- Revista CaribooDokumen7 halamanRevista CaribooemulatorpauBelum ada peringkat

- Planeamiento y Administración de Obra (P-2)Dokumen2 halamanPlaneamiento y Administración de Obra (P-2)norman arielBelum ada peringkat

- Gestion de Riesgos en Proyectos Industriales - Marta Hinojosa AguayoDokumen183 halamanGestion de Riesgos en Proyectos Industriales - Marta Hinojosa AguayoJairo HoyosBelum ada peringkat

- Guia - de TransmisionDokumen17 halamanGuia - de TransmisionDANNEYSBelum ada peringkat

- Multi SimDokumen12 halamanMulti SimEdin Yolfred Soles ReyesBelum ada peringkat

- A 62 Grados Bajo Cero - Alaska - Llorente SegundoDokumen71 halamanA 62 Grados Bajo Cero - Alaska - Llorente SegundoPablo BadanoBelum ada peringkat

- Ficha Tecnica k3 AdamaDokumen4 halamanFicha Tecnica k3 Adamanoe martinBelum ada peringkat

- Dimensiones SocialesDokumen1 halamanDimensiones SocialesYesel RafaeleBelum ada peringkat

- Diplomado de Cálculo y Diseño de PuentesDokumen20 halamanDiplomado de Cálculo y Diseño de PuentesLuis Alvaro Castillo VeloBelum ada peringkat

- Crear Un Ambiente para Los Líderes PotencialesDokumen27 halamanCrear Un Ambiente para Los Líderes PotencialesByron AranaBelum ada peringkat

- Tesis Samuel PachecoDokumen146 halamanTesis Samuel PachecoJulio César BarahonaBelum ada peringkat

- Trabajo Practico de Cinematica Fisica 3er TrimestreDokumen5 halamanTrabajo Practico de Cinematica Fisica 3er TrimestreAnonymous ByHuesBelum ada peringkat

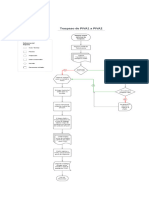

- Procesos de Envios de PIVA1 A PIVA2Dokumen1 halamanProcesos de Envios de PIVA1 A PIVA2casa.maravillas273Belum ada peringkat

- Sellador 415Dokumen2 halamanSellador 415Diego GallardoBelum ada peringkat

- Tesis CimentacionesDokumen178 halamanTesis CimentacionesMishel FuentesBelum ada peringkat

- Share PT Serv Tech RefDokumen792 halamanShare PT Serv Tech RefGabriel VillayzanBelum ada peringkat

- Curriculum Lic Ivett NavaDokumen7 halamanCurriculum Lic Ivett NavaJuvenal Hernandez LlanosBelum ada peringkat

- DECRETO 90 - 1993 Q Asigna Funciones A Organos Administrativos de La JADokumen3 halamanDECRETO 90 - 1993 Q Asigna Funciones A Organos Administrativos de La JAjoseBelum ada peringkat