RNAula 06

Diunggah oleh

Rosemeire MarinelliJudul Asli

Hak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

RNAula 06

Diunggah oleh

Rosemeire MarinelliHak Cipta:

Format Tersedia

UFPR PPGMNE - TC-747 - REDES NEURAIS E APLICAES EM ENGENHARIA Profa.

Andrea Sell Dyminski

4.3 Como melhorar o desempenho do treinamento?

Projeto de uma RN e seu desempenho

Dependem da

Experincia do Usurio

Porm, pode-se tambm utilizar alguns mtodos para melhorar o

desempenho dos algoritmos de treinamento (especialmente, o de

back-propagation):

a) Atualizao (dos pesos) sequencial comparada por lote:

A sequencial mais rpida que a por lote, principalmente para

conjuntos de dados muito grandes e altamente redundantes.

b) Maximizao do contedo de informao:

Para se ampliar a busca nos espao de pesos, pode-se fazer:

- uso de exemplo que resulte o maior erro de treinamento;

- uso de exemplo que seja radicalmente diferente dos usados

anteriormente.

No caso de problemas de classificao de padres, tornar aleatria a

ordem de apresentao dos exemplos (embaralh-los).

Ou ento, usar um esquema de nfase apresentar mais padres

difceis do que fceis. Faz-se esta diferenciao analisando o erro que

o exemplo produz.

Porm, cuidado com exemplos estranhos ou mal rotulados!!!!

c) Funo de ativao:

UFPR PPGMNE - TC-747 - REDES NEURAIS E APLICAES EM ENGENHARIA Profa. Andrea Sell Dyminski

O ideal que se use uma funo de ativao antissimtrica do que

no-simtrica.

Funo Antissimtrica: (-v) = -(v)

hiperblica)

(por exemplo: tangente

d) Valores-alvo:

As respostas desejadas devem estar dentro do intervalo da funo de

ativao escolhida (sigmide).

e) Normalizar as entradas:

Normalizar cada varivel de entrada (pr-processamento) de modo que

o seu valor mdio, de todo o conjunto, esteja prximo de zero ou

pequeno se comparado ao desvio padro.

Tambm se deve ter:

- variveis de entrada no correlacionadas (anlise de componentes

principais);

- estas variveis devem ser escaladas para que suas covarincias

sejam aproximadamente iguais (aprendizado com mesma velocidade).

f) Inicializao:

Boa escolha dos valores iniciais dos pesos e dos limiares da rede.

Pesos sinpticos iniciais --------- Valores pequenos!

UFPR PPGMNE - TC-747 - REDES NEURAIS E APLICAES EM ENGENHARIA Profa. Andrea Sell Dyminski

g) Aprendizagem por indcios: (ou dicas, ou hints)

Pode-se incluir informaes prvias que se tenha sobre a funo de

mapeamento f(.) (desconhecida) no processo de aprendizagem, como

por exemplo:

- propriedades invariantes;

- simetrias;

-etc....

h) Taxas de aprendizagem:

Deve-se atribuir ao parmetro da taxa de aprendizagem () valores

menores nas ltimas camadas do que nas camadas anteriores.

Sugerido (LeCun, 1993) ---- inversamente proporcional raiz

quadrada do nmero de conexes sinpticas.

4.4 Generalizao

Uma rede neural dever ser capaz de generalizar, ou seja, dar uma

soluo (ou resposta) coerente para uma situao no vista

anteriormente, ou seja, no utilzada durante o seu processo de

treinamento.

Cuidado! - Se o treinamento for excessivo, a rede pode memorizar os

exemplos aprendidos, perdendo sua capacidade de generalizao!!!

(Problema de overfitting)

Este problema tambm pode acontecer se utilizarmos nmero

excessivo de neurnios na camada escondida de RN.

(ver figura 4.19 do Haykin)

Pode-se dizer que a generalizao influenciada por trs fatores:

a) Tamanho do conjunto de treinamento representatividade do

espao de interesse;

UFPR PPGMNE - TC-747 - REDES NEURAIS E APLICAES EM ENGENHARIA Profa. Andrea Sell Dyminski

b) Arquitetura da rede neural;

c) Complexidade fsica do problema em questo.

Empiricamente, pode-se dizer que o tamanho do conjunto de

treinamento deve ser:

N = O (W/)

onde:

N = Nmero de exemplos do conjunto de treinamento;

W = Nmero de parmetros livres da RN (pesos sinpticos

e bias)

= Erro (de classificao) permitido sobre os dados de

teste

O = Ordem da quantidade entre parnteses

P. Ex.: Admitindo-se um erro de 10%, o nmero de exemplos de

treinamento necessrios deve ser de cerca de 10 vezes maior que o

nmero de parmetros livres da rede.

Quanto arquitetura da rede:

- em problemas de aproximao de funes, tem-se que atravs do

Teorema da Aproximao Universal:

uma nica camada oculta suficiente para um perceptron de mltiplas

camadas computar uma aproximao E uniforme para um dado

conjunto de treinamento representado pelo conjunto de entradas x1, ...,

xm e a sada desejada f(x1, ..., xm).

Porm, esta nica camada pode no ser tima no sentido do tempo de

aprendizado, facilidade de implementao ou generalizao.

No caso de aproximao de funes, pode-se dizer que, para uma boa

generalizao, deve-se ter:

N > W/mse, onde mse: mdia do erro quadrtico estimativo.

UFPR PPGMNE - TC-747 - REDES NEURAIS E APLICAES EM ENGENHARIA Profa. Andrea Sell Dyminski

4.5 Validao cruzada

Atravs deste princpio, deve-se inicialmente dividir o conjunto

disponvel de dados em:

- Conjunto de Treinamento

- Conjunto de Teste.

Depois disso, deve-se dividir o conjunto de treinamento em:

- subconjunto de estimao: usado para selecionar o modelo ou, no

caso das RNs, ajustar os parmetros livres;

- subconjunto de validao: usado para testar ou validar o modelo, em

RNs, usado para definir qual a melhor arquitetura e quando deve-se

parar o treinamento.

(vide figura 4.20 Haykin).

Deve-se apenas tomar cuidado para a rede no memorizar o

conjunto de validao!!!

Anda mungkin juga menyukai

- AparalixoDokumen2 halamanAparalixoRosemeire MarinelliBelum ada peringkat

- Aula 1 - FolhetoDokumen14 halamanAula 1 - FolhetoPaula DamasfBelum ada peringkat

- Aparalixo PDFDokumen10 halamanAparalixo PDFLindomar Corrêa de OliveiraBelum ada peringkat

- Andaime Balancim IndividualDokumen13 halamanAndaime Balancim IndividualJoao Diniz100% (1)

- Aula 4 - FolhetoDokumen9 halamanAula 4 - FolhetoRosemeire MarinelliBelum ada peringkat

- Acao de Anulacao e Substituicao de Titulo Ao PortadorDokumen5 halamanAcao de Anulacao e Substituicao de Titulo Ao PortadorRosemeire MarinelliBelum ada peringkat

- Manual de Metodos de Analise de Solo 2017Dokumen575 halamanManual de Metodos de Analise de Solo 2017Anonymous wl7LeV59dBelum ada peringkat

- Certidão Negativa de DébitoDokumen5 halamanCertidão Negativa de DébitoRosemeire MarinelliBelum ada peringkat

- Direito Societario - ApostilaDokumen68 halamanDireito Societario - ApostilaHanilton SantosBelum ada peringkat

- Manual Tecnico Do Sistema Cambio - Mercado Primario - Versao 1.2Dokumen55 halamanManual Tecnico Do Sistema Cambio - Mercado Primario - Versao 1.2Rosemeire MarinelliBelum ada peringkat

- Acao de Anulacao e Substituicao de Titulo Ao PortadorDokumen5 halamanAcao de Anulacao e Substituicao de Titulo Ao PortadorRosemeire MarinelliBelum ada peringkat

- AudienciaDokumen7 halamanAudienciaRosemeire MarinelliBelum ada peringkat

- Impressao Digital U V Flatbed Vinil Aplike Antiderrapante TecidoDokumen2 halamanImpressao Digital U V Flatbed Vinil Aplike Antiderrapante TecidoRosemeire MarinelliBelum ada peringkat

- Adesivos de Parede Parte Guia PlotterDokumen1 halamanAdesivos de Parede Parte Guia PlotterRosemeire MarinelliBelum ada peringkat

- Adesivos de Parede Adesivacao de Ambientes DomesticosDokumen5 halamanAdesivos de Parede Adesivacao de Ambientes DomesticosRosemeire MarinelliBelum ada peringkat

- Laminacao FoscaDokumen1 halamanLaminacao FoscaRosemeire MarinelliBelum ada peringkat

- Adevisacao Da FrotaDokumen5 halamanAdevisacao Da FrotaDuzeru CamiseteriaBelum ada peringkat

- Grupo Aplike Historico Posicionamento MercadoDokumen1 halamanGrupo Aplike Historico Posicionamento MercadoRosemeire MarinelliBelum ada peringkat

- Aplicacao Verniz PDFDokumen3 halamanAplicacao Verniz PDFRosemeire MarinelliBelum ada peringkat

- Adesi Amb Corpor Adesivos ParedeDokumen2 halamanAdesi Amb Corpor Adesivos ParedeRosemeire MarinelliBelum ada peringkat

- APLIKE - Cuto Certo5Dokumen2 halamanAPLIKE - Cuto Certo5Rosemeire MarinelliBelum ada peringkat

- Canvas Um Produto Diferenciado PDFDokumen2 halamanCanvas Um Produto Diferenciado PDFRosemeire MarinelliBelum ada peringkat

- APLIKE - Transformação de Folhas Auto-AdesivasDokumen8 halamanAPLIKE - Transformação de Folhas Auto-AdesivasRosemeire MarinelliBelum ada peringkat

- APLIKE - Coto Certo6Dokumen2 halamanAPLIKE - Coto Certo6Rosemeire MarinelliBelum ada peringkat

- APLIKE - Como Comprar o Produto CertoDokumen6 halamanAPLIKE - Como Comprar o Produto CertoRosemeire MarinelliBelum ada peringkat

- APLIKE - Couto Certo8Dokumen3 halamanAPLIKE - Couto Certo8Rosemeire MarinelliBelum ada peringkat

- APLIKE - Como Comprar o Produto CertoDokumen6 halamanAPLIKE - Como Comprar o Produto CertoRosemeire MarinelliBelum ada peringkat

- APLIKE - Como Aplicar CorretamenteDokumen10 halamanAPLIKE - Como Aplicar CorretamenteRosemeire MarinelliBelum ada peringkat

- APLIKE - Como Aplicar CorretamenteDokumen10 halamanAPLIKE - Como Aplicar CorretamenteRosemeire MarinelliBelum ada peringkat

- Avaliação em Medodologia CientificaDokumen3 halamanAvaliação em Medodologia CientificaAlessandra Cruz100% (1)

- Nível Médio - Conhecimentos BásicosDokumen9 halamanNível Médio - Conhecimentos BásicosabmelegariBelum ada peringkat

- A Educação Dos Primórdios Ao Século XXI: Perspectivas, Rumos e DesafiosDokumen39 halamanA Educação Dos Primórdios Ao Século XXI: Perspectivas, Rumos e DesafiosHermesBelum ada peringkat

- Construtivismo Versus Socio InteracionsimoDokumen13 halamanConstrutivismo Versus Socio InteracionsimoPaulo Ferreira100% (1)

- O Teatro de Confluencia de Murray Schafer A Integracao Das Artes Como Elemento ImportanteDokumen8 halamanO Teatro de Confluencia de Murray Schafer A Integracao Das Artes Como Elemento ImportanteIvan VerasBelum ada peringkat

- Como Criar Uma Meta Através Do Método GROW - Coaching de VidaDokumen3 halamanComo Criar Uma Meta Através Do Método GROW - Coaching de VidaRobert LuizBelum ada peringkat

- Atividade Reflexiva 1Dokumen2 halamanAtividade Reflexiva 1Nathalia0% (1)

- Historia A 10 11 12Dokumen80 halamanHistoria A 10 11 12atome67% (6)

- O Nacionalismo e Suas VertentesDokumen7 halamanO Nacionalismo e Suas VertentesAdelino Frazao100% (1)

- Edital CESMAC - PET 2024Dokumen13 halamanEdital CESMAC - PET 2024erogamegame10Belum ada peringkat

- Anna Karenina Chaves Delgado PDFDokumen120 halamanAnna Karenina Chaves Delgado PDFAllan Stephan SilvaBelum ada peringkat

- História Da Educação e Da Pedagogia - Lorenzo LuzuriagaSSSDokumen112 halamanHistória Da Educação e Da Pedagogia - Lorenzo LuzuriagaSSSYan Guedes64% (11)

- Socioeducação. Estrutura e Funcionamento Da Comunidade EducativaDokumen158 halamanSocioeducação. Estrutura e Funcionamento Da Comunidade EducativadjalmapsiBelum ada peringkat

- Modelo de Proposta para Trabalho PedagógicoDokumen10 halamanModelo de Proposta para Trabalho PedagógicoProf. Elicio Lima100% (6)

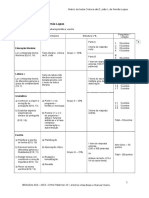

- Criterios Gerais Especificos Correcao Teste 01 F LopesDokumen9 halamanCriterios Gerais Especificos Correcao Teste 01 F LopesajsgomesBelum ada peringkat

- Sintaxe e Semântica Do PortuguêsDokumen5 halamanSintaxe e Semântica Do PortuguêsVinícius Adriano de Freitas100% (2)

- Cad04 ParteC Aluno Quali MAT SD3Dokumen3 halamanCad04 ParteC Aluno Quali MAT SD3Edilian ArraisBelum ada peringkat

- Conteúdo ProgramáticoDokumen1 halamanConteúdo ProgramáticoPaulo TrichesBelum ada peringkat

- Exame Portugues II 2010Dokumen4 halamanExame Portugues II 2010Marco MaquenaBelum ada peringkat

- Apostila Completa Das Aulas de Direito Do Trabalho - MarceloSegalDokumen277 halamanApostila Completa Das Aulas de Direito Do Trabalho - MarceloSegalDaniel Dos Santos MacedoBelum ada peringkat

- Procedimentos Da CrecheDokumen15 halamanProcedimentos Da CrecheMarta SantosBelum ada peringkat

- TAMC-RIGOTTO Raquel - AgrotoxicosDokumen12 halamanTAMC-RIGOTTO Raquel - AgrotoxicosDanilo Santana SilvaBelum ada peringkat

- Cel0284 - Tópicos em Libras Av1 Simulado 2Dokumen5 halamanCel0284 - Tópicos em Libras Av1 Simulado 2RodrjgwBelum ada peringkat

- Orbis Pictus - Jean Amós Comenius PDFDokumen11 halamanOrbis Pictus - Jean Amós Comenius PDFMarcos Cesar100% (1)

- 1º-Ficha de Avaliação Do 1º Ano B de 01 A 15 de Julho de 2021 Pró SolangeDokumen2 halaman1º-Ficha de Avaliação Do 1º Ano B de 01 A 15 de Julho de 2021 Pró SolangeSolange SantosBelum ada peringkat

- RD - (Educação) - Guia Do Microlearning para Instituições de EnsinoDokumen30 halamanRD - (Educação) - Guia Do Microlearning para Instituições de EnsinoEric DeBritoBelum ada peringkat

- Texto Ed. FisicaDokumen10 halamanTexto Ed. FisicaMarcelo GaldinoBelum ada peringkat

- Educação Física e Aprendizagem Social - Valter BrachtDokumen64 halamanEducação Física e Aprendizagem Social - Valter Brachtconstanzamabres100% (3)

- Projeto Pedagogico - Os Órgãos Dos SentidosDokumen22 halamanProjeto Pedagogico - Os Órgãos Dos Sentidosjames_jps8979100% (1)

- Boletim Pedagogico Proalfa 2009Dokumen50 halamanBoletim Pedagogico Proalfa 2009Ana Elena Silva GonçalvesBelum ada peringkat