0% menganggap dokumen ini bermanfaat (0 suara)

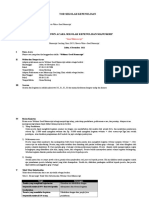

27 tayangan23 halamanPanduan Lengkap Clustering Analysis

memahami tentang clustering analysis

Diunggah oleh

mifta ardiantiHak Cipta

© © All Rights Reserved

Kami menangani hak cipta konten dengan serius. Jika Anda merasa konten ini milik Anda, ajukan klaim di sini.

Format Tersedia

Unduh sebagai PDF, TXT atau baca online di Scribd

0% menganggap dokumen ini bermanfaat (0 suara)

27 tayangan23 halamanPanduan Lengkap Clustering Analysis

memahami tentang clustering analysis

Diunggah oleh

mifta ardiantiHak Cipta

© © All Rights Reserved

Kami menangani hak cipta konten dengan serius. Jika Anda merasa konten ini milik Anda, ajukan klaim di sini.

Format Tersedia

Unduh sebagai PDF, TXT atau baca online di Scribd