Analisis Regresi Linier (Lanjutan)

Diunggah oleh

AS1222Judul Asli

Hak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

Analisis Regresi Linier (Lanjutan)

Diunggah oleh

AS1222Hak Cipta:

Format Tersedia

Analisis Regresi Linier (

Lanjutan )

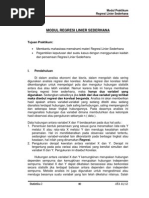

Outline

- Regresi Berganda

- Pemeriksaan Regresi :

Koef. Determinasi

Standar Error

Interval Kepercayaan

Uji Hipotesis :t test, F test,

- Pelanggaran Asumsi :

Multicollinearity

Heteroscedasticity

Otokorelasi

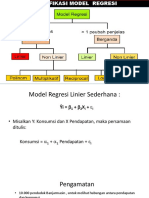

Regresi Berganda

Apakah Konsumsi hanya dipengaruhi oleh

Pendapatan saja?

Ada beberapa variabel lain yang berpengaruh,

seperti jumlah anggota keluarga, umur anggota

keluarga, selera pribadi, dan sebagainya.

Bila dianggap variabel lain perlu diakomodasikan

dalam menganalisis konsumsi, maka Regresi

Sederhana dikembangkan menjadi Regresi

Berganda.

MODEL

Y

i

= |

0

+ |

1

X

1i

+ |

2

X

2i

+ |

3

X

3i

+ ........+ |

k

X

ki

+ u

i

i = 1,2,3,......., N (banyaknya

observasi)

Contoh Aplikasi:

Y

i

= |

0

+ |

1

X

1

+ |

2

X

2

+ |

3

X

3

+ u

i

Y : Konsumsi

X

1

: Pendapatan

X

2

: Umur

X

3

: Jumlah tanggungan

Pemeriksaan Regresi

Koefisien Determinasi

Standard Error Koefisien

Interval Kepercayaan

Uji Hipotesis:

Uji t

Uji F

Pemeriksaan Regresi

Standard Error

Prinsip OLS: meminimalkan error. Oleh karena itu, ketepatan

dari nilai dugaan sangat ditentukan oleh standard error dari

masing-masing penduga. Adapun standard error dirumuskan

sebagai berikut:

Se=

2

n 2

=

SST SSR

n 2

=

2

b

n 2

= MSE

Pemeriksaan Regresi

Oleh karena o merupakan penyimpangan yang terjadi dalam

populasi, yang nilainya tidak diketahui, maka o biasanya diduga

berdasarkan data sampel. Adapun penduganya adalah sebagai

berikut :

s

u

N

i

=

|

\

|

.

|

|

2

1/2

2

u

i

2

=

2

)

(

i i

Y Y

u

i

2

=

Berdasar formula: error yang minimal akan

mengakibatkan standar error koefisien

yang minimal pula. Berapa batasannya

standar error disebut besar atau kecil?

Pemeriksaan Regresi

Sulit ditentukan secara absolut. Data jutaan

rupiah tentunya akan memiliki standar error

yang lebih besar dibanding ratusan rupiah.

Digunakan dengan membuat rasio dengan

koefisien regresi.

Rasio inilah yang menjadi acuan pada Uji-t.

Interval Kepercayaan

j

Apa yang dimaksud Interval kepercayaan?

Untuk apa?

Formulasi:

b

j

t

o/2

s.e(b

j

)

atau

P(b

j

- t

o/2

s.e(b

j

)

j

b

j

+ t

o/2

s.e(b

j

))= 1- o

Interval Kepercayaan

j

b

1

= 0,1022 dan s.e (b

1

) = 0,0092. Banyaknya

observasi (n) = 10; Banyaknya parameter yang

diestimasi (k) = 2; Dengan demikian derajat bebas

= 10 2 = 8; dan tingkat signifikansi 1-o = 95 %.

Dari tabel t

0,025

dengan derajat bebas = 8, diperoleh

nilai t = 2,306.

Makaintervalkepercayaanuntuk

1

adalah :

( 0,1022 2,306 (0,0092) ) atau (0,0810 ; 0,1234)

Artinya:Nilai

1

terletak antara 0,0810 dan 0,1234

dengan peluang sebesar 95%.

Uji Hipotesis

Pengujian koefisien regresi secara individu.

H

0

: |

j

= 0

H

1

: |

j

= 0; j = 0, 1, 2........, k k adalah

koefisien slop.

Untuk regresi sederhana:

(1) H

0

: |

0

= 0 (2) H

0

: |

1

= 0

H

1

: |

0

= 0 H

1

: |

1

= 0;

Uji-t didefinisikan sebagai berikut:

t =

b

j

j

s. e b

j

|

j

akan diuji

apakah

sama dengan 0

t =

b

j

s. e b

j

Uji t

Uji-t

Nilai t dibandingkan dengan nilai t tabel. Bila

ternyata, setelah dihitung |t| > t

o/2

,df, maka nilai t

berada dalam daerah penolakan, sehingga

hipotesis nol (|

j

= 0) ditolak pada tingkat

kepercayaan (1-o) x100%. Dalam hal ini dapat

dikatakan bahwa |

j

statistically significance.

Uji Hipotesis

Uji-F

Diperuntukkan guna melakukan uji hipotesis koefisien (slop)

regresi secara bersamaan.

H

0

: |

2

= |

3

= |

4

=............= |

k

= 0

H

1

: Tidak demikian (paling tidak ada satu slop yang = 0)

Dimana: k adalah banyaknya variabel bebas.

Regresi sederhana:

H

0

: |

1

= |

2

= |

3

= 0

H

1

: Tidak demikian (paling tidak ada satu slop yang = 0)

Pengujian: ANOVA (Analysis of Variance).

Uji-F

Observasi: Y

i

= |

0

+ |

1

X

i

+ e

i

Regresi:

i

= b

1

+ b

2

X

i

(catatan:

i

merupakan estimasi dari Yi).

Bila kedua sisi dikurangi maka:

Selanjutnya kedua sisi dikomulatifkan:

SST SSR SSE

SST : Sum of Squared Total

SSR : Sum of Squared Regression

SSE : Sum of Squared Error/Residual

Y YYYe

i i

=+

( ) (

) YY YYe

i i i

= +

2 2

( ) (

) YY YY e

i i i

= +

2 2 2

Y

Uji F

Tabel ANOVA

Sumber Sum of Square df Mean Squares F Hitung

Regresi SSR k MSR = SSR/k F = MSR

Error SSE n-k-1 MSE= SSE/(n-k-1) MSE

Total SST n-1

Dimana df adalah degree of freedom, k adalah jumlah variabel

bebas (koefisien slop), dan n jumlah observasi (sampel).

Bandingkan F

Hit

dengan F

(k,n-k-1)

Asumsi-asumsi dasar OLS

Pendugaan OLS akan bersifat BLUE

(Best Linier Unbiased Estimate) jika

memenuhi 3 asumsi utama, yaitu:

Tidak ada multikolinieritas

Tidak mengandung Heteroskedastisitas

Bebas dari otokorelasi

Multikolinieritas

Multikolinieritas: adanya hubungan

linier antara regressor.

Misalkan terdapat dua buah regressor,

X

1

dan X

2

. Jika X

1

dapat dinyatakan

sebagai fungsi linier dari X

2

, misal : X

1

= X

2

, maka ada kolinieritas antara X

1

dan X

2

. Akan tetapi, bila hubungan

antara X

1

dan X

2

tidak linier, misalnya

X

1

= X2

2

atau X

1

= log X

2

, maka X

1

dan

X

2

tidak kolinier.

Ilustrasi

Y

i

= |

0

+ |

1

X

1

+ |

2

X

2

+ |

3

X

3

+ u

i

Y : Konsumsi

X

1

: Total Pendapatan

X

2

: Pendapatan dari upah

X

3

: Pendapatan bukan dari upah

Secara substansi: total pendapatan (X

1

) = pendapatan dari

upah (X

2

) + pendapatan bukan dari upah (X

3

). Bila model ini

ditaksir menggunakan Ordinary Least Square (OLS), maka |

i

tidak dapat diperoleh, karena terjadi perfect multicollinearity.

Tidak dapatnya | diperoleh karena ( XT X )-1, tidak bisa dicari.

Akibat Multikolinieritas

Varians besar (dari taksiran OLS)

Interval kepercayaan lebar (variansi besar

Standar Error besar Interval kepercayaan lebar)

R

2

tinggi tetapi tidak banyak variabel yang

signifikan dari uji t.

Terkadang taksiran koefisien yang didapat akan

mempunyai nilai yang tidak sesuai dengan

substansi, sehingga dapat menyesatkan

interpretasi.

Kesalahan Interpretasi

Interpretasi dari persamaan regresi ganda

secara implisit bergantung pada asumsi bahwa

variabel-variabel bebas dalam persamaan

tersebut tidak saling berkorelasi. Koefisien-

koefisien regresi biasanya diinterpretasikan

sebagai ukuran perubahan variabel terikat jika

salah satu variabel bebasnya naik sebesar satu

unit dan seluruh variabel bebas lainnya

dianggap tetap. Namun, interpretasi ini menjadi

tidak benar apabila terdapat hubungan linier

antara variabel bebas

(Chatterjee and Price, 1977).

Ilustrasi

Model:

Y = 12,8 1,414X

1

+ 0,202 X

2

SE (4,696) (1,199) (0,117)

t (2,726) (-1,179) (1,721)

R

2

= 0,982

R

2

relatif tinggi, yaitu 98,2%. Artinya?

Uji t tidak signifikan. Artinya?

Koefisien X1 bertanda negatif. Artinya?

Ilustrasi: Model dipecah

Dampak Pendapatan pada Konsumsi

Y = 14,148 + 0,649X

1

SE (5,166) (0,037)

t (2,739) (17,659)

R

2

= 0,975

R

2

tinggi, Uji t signifikan, dan tanda X

1

positif.

Dampak Kekayaan pada Konsumsi

Y = 13,587 + 0,0635X

2

SE (4,760) (0,003)

t (2,854) (19,280)

R

2

= 0,979

R

2

tinggi, Uji t signifikan, dan tanda X

2

positif.

X

1

dan X

2

menerangkan variasi yang sama. Bila 1 variabel saja

cukup, kenapa harus dua?

Mendeteksi Multikolinieritas dengan Uji

Formal

1. Eigenvalues dan Conditional Index

Aturan yang digunakan adalah: Multikolinieritas ditengarai

ada didalam persamaan regresi bila nilai Eigenvalues

mendekati 0.

Hubungan antara Eigenvalues dan Conditional Index (CI)

adalah sebagai berikut:

CI=

max eigenvalues

min eigenvalues

Jika CI berada antara nilai 10 sampai 30:

kolinieritas moderat.

Bila CI mempunyai nilai diatas 30: kolinieritas

yang kuat.

2. VIF dan Tolerance

VIF

j

=

1

1 R

j

2

; j = 1,2,,k

k adalah banyaknya variabel bebas

adalah koefisien determinasi antara variabel bebas ke-j dengan

variabel bebas lainnya.

R

j

2

R

j

2

R

j

2

Jika

= 0 atau antar variabel bebas tidak berkorelasi, maka nilai VIF = 1.

0 atau ada korelasi antar variabel bebas, maka nilai VIF > 1. Jika

Oleh karena itu, dapat disimpulkan bahwa kolinieritas tidak ada

jika nilai VIF mendekati angka 1

Tolerance

VIF ini mempunyai hubungan dengan

Tolerance (TOL), dimana

hubungannya adalah sebagai berikut:

TOL

j

=

1

VIF

= 1 R

j

2

Variabel bebas dinyatakan tidak multikolinieritas jika

TOL mendekati 1

Mengatasi multikolinieritas

Melihat informasi sejenis yang ada

Tidak mengikutsertakan salah satu variabel yang

kolinier

Banyak dilakukan.

Hati-hati, karena dapat menimbulkan specification bias

yaitu salah spesifikasi kalau variabel yang dibuang

merupakan variabel yang sangat penting.

Mentransformasikan variabel

Mencari data tambahan

Data Heteroskedastisitas

Fakta:

hubungan positif antara X dan Y, dimana

nilai Y meningkat searah dengan nilai X.

semakin besar nilai variabel bebas (X)

dan variabel bebas (Y), semakin jauh

koordinat (x,y) dari garis regresi (Error

makin membesar)

besarnya variasi seiring dengan

membesarnya nilai X dan Y. Atau dengan

kata lain, variasi data yang digunakan

untuk membuat model tidak konstan.

Pemeriksaan

Heteroskedastisitas

1. Metode Grafik

Prinsip: memeriksa pola residual (u

i

2

)

terhadap taksiran Y

i

.

Langkah-langkah:

Run suatu model regresi

Dari persamaan regresi, hitung u

i

2

Buat plot antara u

i

2

dan taksiran Y

i

Pola Grafik

u

i

2

i

Pengamatan:

1.Tidak adanya pola yang sistematis.

2.Berapapun nilai Y prediksi, residual kuadratnya relatif sama.

3.Variansi konstan, dan data homoskedastis.

,

Pola Adanya

Heteroskedastisitas

Pola sistematis

u

i

2

u

i

2

i

i

Uji Park

Prinsip: memanfaatkan bentuk regresi

untuk melihat adanya

heteroskedastisitas.

Langkah-langkah yang dikenalkan

Park:

1. Run regresi Y

i

= o

0

+ |

0

X

i

+ u

i

2. Hitung ln u

i

2

3. Run regresi ln u

i

2

= o + | ln X

i

+ v

i

4. Lakukan uji-t. Bila | signifikan, maka

ada

heteroskedastisitas dalam data.

Ilustrasi

Y = -3,1470 + 5,5653 X

SE (0,0305) R

2

= 0,9992

slope signifikan: Bila sepatu terjual naik 1 unit, maka bonus

akan naik Rp.5.563.

Apakah ada heteroskedastisitas ?

Run regresi, didapat:

ln u

i

2

= 6,0393 2,1116 ln X

i

SE (0,0090) R

2

= 0,9995

Menurut uji t, | signifikan sehingga dalam model penjualan

sepatu vs bonus di atas ada heteroskedastisitas.

Uji Goldfeld Quandt

Metode Goldfeld Quandt sangat populer untuk digunakan, namun

agak merepotkan, terutama untuk data yang besar.

Langkah-langkah pada metode ini:

Urutkan nilai X dari kecil ke besar

Abaikan beberapa pengamatan sekitar median, katakanlah

sebanyak c pengamatan. Sisanya, masih ada (N c)

pengamatan

Lakukan regresi pada pengamatan 1, dan hitung SSE 1

Lakukan regresi pada pengamatan 2 dan hitung SSE 2.

Hitung df = jumlah pengamatan dikurangi jumlah parameter

Lakukan uji F sbb.

=

RSS

2

/ df

2

RSS

1

/ df

1

Bila > F tabel, kita tolak hipotesis yang mengatakan data mempunyai variansi

yang homoskedastis

Ilustrasi

Ada 30 pengamatan penjualan sepatu dan bonus. Sebanyak 4

pengamatan yang di tengah diabaikan sehingga tinggal 13

pengamatan pertama (Kelompok I) dan 13 pengamatan kedua

(Kelompok II).

Regresi berdasarkan pengamatan pada kelompok I:

Y = -1,7298 + 5,4199 X R

2

= 0,9979

RSS1 = 28192,66 df1 = 11

Regresi berdasarkan pengamatan pada kelompok II:

Y = -0,8233 + 5,5110 X R

2

= 0,9941

RSS2 = 354397,6 df2 = 11

Ilustrasi

=

RSS

2

/ df

2

RSS

1

/ df

1

= 354397,6/11

28192,66/11

= 12,5706

Dari tabel F, didapat F = 2,82 sehingga > F

Kesimpukan: ada heteroskedastisitas dalam data

Mengatasi

heteroskedastisitas

1. Transformasi dengan Logaritma

Transformasi ini ditujukan untuk

memperkecil skala antar variabel bebas.

Dengansemakinsempitnyarange nilai

observasi, diharapkan variasi error juga

tidak akan berbeda besar antar kelompok

observasi.

Adapun model yang digunakan adalah:

Ln Y

j

=

0

+

1

Ln X

j

+ u

j

2. Metode Generalized Least Squares

(GLS)

Perhatikan model berikut :

Y

j

= |

1

+ |

2

X

j

+ u

j

dengan Var (u

j

) = o

j

2

Masing-masing dikalikan

1

s

j

Y

j

s

j

=

1

1

s

j

+

2

X

j

s

j

u

j

s

j

Maka diperoleh transformed model sebagai berikut :

Y

i

* = |

1

* + |

2

X

i

* + u

i

*

GLS

Kita periksa dulu apakah ui* homoskedastis ?

E

u

i

2

i

2

=

1

i

2

E u

i

2 =

1

i

2

i

2 = 1

E(u

i

*

2

) =

konstan

Transformasi

Oleh karena mencari o

j

2

hampir tidak pernah diketahui, maka

biasanya digunakan asumsi untuk mendapat nilai o

j

2

. Asumsi

ini dapat dilakukan dengan mentransformasikan variabel. Ada

beberapa jenis, yaitu:

1

X

j

1. Transformasi dengan

Asumsi: o

j

2

= E u

j

2

=

2

X

j

2

Akibat transformasi, model menjadi:

Y

j

X

j

=

0

1

X

j

+

1

u

j

X

j

atau dapat ditulis dengan: Y

i

* = |

0

X* + |

1

+ v

i

Transformasi

Apakah sudah homoskedastis? Perhatikan bukti berikut:

E

u

j

2

X

j

2

=

1

X

j

2

E u

j

2

=

1

X

j

2

2

X

j

2

=

2

E(v

i

2

) = konstan

2. Transformasi dengan

1

X

i

Asumsi: o

j

2

=

E u

j

2

=

2

X

j

3. Transformasi dengan E(Yi)

E u

j

2

=

2

[ E Y

j

]

2

Asumsi: o

j

2

=

Otokorelasi

Otokorelasi: korelasi antara variabel itu

sendiri, pada pengamatan yang

berbeda waktu atau individu.

Umumnya kasus otokorelasi banyak

terjadi pada data time series Kondisi

sekarang dipengaruhi waktu lalu.

Misal: Tinggi badan, upah, dsbnya.

Salah satu alat deteksi: melihat pola

hubungan antara residual (ui) dan

variabel bebas atau waktu (X).

Mendeteksi Otokorelasi

Pola Autokorelasi

ui ui

*

* **

* * * * * *

* * * **

* * * Waktu/X * ** Waktu/X

* * * *

***

*

Gambar nomor (1) menunjukan adanya siklus, sedang nomor (2)

menunjukan garis linier. Kedua pola ini menunjukan adanya

otokorelasi.

Uji Durbin-Watson ( Uji d)

d=

t=2

N

u

t

u

t 1

2

t=1

N

u

t

2

Statistik Uji

Dalam Paket Program SPSS/EViews Sudah dihitungkan

Aturan main menggunakan uji Durbin-

Watson :

Bandingkan nilai d yang dihitung dengan nilai d

L

dan d

U

dari tabel dengan aturan berikut :

Bila d < d

L

tolak H

0

; Berarti ada korelasi yang positif

atau kecenderungannya = 1

Bila d

L

s d s d

U

kita tidak dapat mengambil kesimpulan

apa-apa

Bila d

U

< d < 4 d

U

jangan tolak H

0

; Artinya tidak ada

korelasi positif maupun negatif

Bila 4 d

U

s d s 4 d

L

kita tidak dapat mengambil

kesimpulan apa-apa

Bila d > 4 d

L

tolak H

0

; Berarti ada korelasi negatif

Mengatasi Otokorelasi: Metode Pembedaan

Umum (Generalized Differences)

Yt=

0

+

1

X

t

+ u

t

dan u

t

=u

t-1

+

v

t

Untuk waktu ke- t-1: Y

t-1

=

0

+

1

X

t-1

+ u

t-

1

Bilakeduasisipersamaandikalidengan,maka:

Y

t-1

=

0

+

1

X

t-1

+u

t-

1

Sekarang kita kurangkan dengan persamaan

Model

Y

t

- Y

t-1

=(

0

-

0

)+

1

(X

t

- X

t-1

) + (u

t

- u

t-

1

)

Persamaan tersebut dapat dituliskan sebagai:

Y

t

*=

0

(1 - )+

1

X

t

* +

v

t

Dimana: Y

t

* = Y

t

- Y

t-1

dan X

t

* = X

t

- X

t-1

Idealnya kita

harus dapat

mencarinilai.

Tapi dalam

banyak kasus,

diasumsikan

=1,

sehingga:

Yt* = Yt - Yt-1

Xt* = Xt - Xt-1

Pemilihan Model

1. R

2

Adjusted

Perhatikan Model:

(i) LABA = 5053,712 + 0,049 KREDIT; R

2

= 80,6%

(ii) LABA = 45748,484 + 0,0106 ASET + 0,0081 KREDIT; R

2

= 87,4%.

Model manakah yang lebih baik ditinjau dari koefisien

determinasi-nya?.

Sekarang kita perhatikan kembali formula untuk menghitung R

2

R

2

=

SSR

SST

= 1

SSE

SST

= 1

u

i

2

Y

i

Y

2

R

2

Adjusted

SST sama sekali tidak dipengaruhi oleh jumlah variabel bebas,

karena formulasinya hanya memperhitungkan variabel terikat

SSE dipengaruhi oleh variabel bebas, dimana semakin banyak

variabel bebas, maka nilai SSE cenderung semakin kecil, atau

paling tidak tetap. SSE kecil, maka nilai SSR akan besar.

Akibat kedua hal tersebut, maka semakin banyak variabel

bebas yang dimasukkan dalam model, maka nilai R

2

akan

semakin besar.

R

2

= 1

u

i

2

/ n k

Y

i

Y / n 1

Pemilihan Model

2. Akaike Information Criterion (AIC)

AIC=e

2k/n

u

i

2

n

=e

2k/n

SSE

n

ln AIC=

2k

n

ln

RSS

n

Bila kita membandingkan dua buah regresi atau lebih, maka model yang

mempunyai nilai AIC terkecil merupakan model yang lebih baik.

Ilustrasi

LABA = 5053,712 + 0,049 KREDIT; SSE = 3,28E+12

LABA = 58260,461 + 0,013 ASET; SSE = 2,1E+12

LABA = 45748,484 + 0,0106 ASET + 0,0081 KREDIT; SSE =

2,17E+12

ln AIC

i

=

2k

n

ln

RSS

n

=

2x2

50

ln

3,28E 12

50

= 24 , 9868

ln AIC

ii

=

2k

n

ln

RSS

n

=

2x2

50

ln

2,1E 12

50

= 24 , 5409

ln AIC

iii

=

2k

n

ln

RSS

n

=

2x3

50

ln

2,17E 12

50

= 24 , 6137

Pemilihan Model

3. Schwarz Information Criterion (SIC)

SIC=n

k/n

u

i

2

n

=n

k/n

SSE

n

ln SIC=

k

n

ln n+ln

RSS

n

Sama dengan AIC, model yang mempunyai nilai SIC terkecil merupakan

model yang lebih baik.

Ilustrasi

ln SIC

i

=

k

n

ln n+ln

RSS

n

=

2

50

ln50 ln

3,28E+12

50

= 25, 06

ln SIC

ii

=

k

n

ln n+ln

RSS

n

=

2

50

ln50 ln

2,1E 12

50

= 24 , 62

ln SIC

iii

=

k

n

ln n+ln

RSS

n

=

3

50

ln50 ln

2,17E+12

50

= 24 , 73

Anda mungkin juga menyukai

- Analisis Regresi Linear SederhanaDokumen19 halamanAnalisis Regresi Linear Sederhanabeni_rezpector100% (2)

- Regresi Linier SederhanaDokumen24 halamanRegresi Linier SederhanaAgunk Arc DarkHeart50% (2)

- Soal Ekonomi Kelas X Dan Kunci Jawaban Ulangan Umum Semester Ganjil - MATERI EKONOMIDokumen9 halamanSoal Ekonomi Kelas X Dan Kunci Jawaban Ulangan Umum Semester Ganjil - MATERI EKONOMIAS122273% (30)

- K2 - Regresi SederhanaDokumen25 halamanK2 - Regresi SederhanaFitranty AdirestutyBelum ada peringkat

- K3 - k4 - Regresi GandaDokumen51 halamanK3 - k4 - Regresi GandaAddinlaila30 김태형Belum ada peringkat

- Dasar2 EkonometrikaDokumen27 halamanDasar2 EkonometrikaadimanzaeBelum ada peringkat

- Regresi Linier PPDokumen48 halamanRegresi Linier PPonkysim_ewBelum ada peringkat

- Ekonometrika Dasar P1Dokumen13 halamanEkonometrika Dasar P1elsa rostianaBelum ada peringkat

- Modul 5Dokumen17 halamanModul 5Miie MirzahBelum ada peringkat

- Regresi Dan KorelasiDokumen57 halamanRegresi Dan Korelasisanti nurdinBelum ada peringkat

- Bahan Ajar Analisis RegresiDokumen15 halamanBahan Ajar Analisis Regresiokta7373Belum ada peringkat

- Regresi Linier Sederhana Dan Analisa Probit 2022-1Dokumen47 halamanRegresi Linier Sederhana Dan Analisa Probit 2022-1Rizky Bachrul AlamBelum ada peringkat

- BAB I Statistik Akuntansi IIDokumen12 halamanBAB I Statistik Akuntansi IIValeria RessaBelum ada peringkat

- Materi Korelasi RegresiDokumen31 halamanMateri Korelasi Regresigazwan gamingBelum ada peringkat

- Kuliah 13 - Asumsi Linear BergandaDokumen81 halamanKuliah 13 - Asumsi Linear BergandaSri RahayuBelum ada peringkat

- Korelasi Dan RegresiDokumen6 halamanKorelasi Dan RegresiNavita FebrianiBelum ada peringkat

- Analisis Regresi and Uji Asumsi Di MinitDokumen23 halamanAnalisis Regresi and Uji Asumsi Di MinitErlyana SaputriBelum ada peringkat

- Statdes Klompok 7 Analisis KorelasiDokumen11 halamanStatdes Klompok 7 Analisis KorelasiMuhammad Ghozian Kafi AhsanBelum ada peringkat

- Bab 1: Model Regresi Mudah Chapter OutlineDokumen36 halamanBab 1: Model Regresi Mudah Chapter OutlinepuzaimahBelum ada peringkat

- ApapunDokumen6 halamanApapunYaelahBelum ada peringkat

- Pertemuan 5Dokumen13 halamanPertemuan 5Dona MarinaBelum ada peringkat

- Slide ANALISIS REGRESI SEDERHANADokumen47 halamanSlide ANALISIS REGRESI SEDERHANARidho IlahiBelum ada peringkat

- MODUL 5 Asumsi KlasikDokumen4 halamanMODUL 5 Asumsi KlasikChirdie Rayv OnibalaBelum ada peringkat

- Regresi Linier Sederhana Erna P R Dan FauziahDokumen25 halamanRegresi Linier Sederhana Erna P R Dan Fauziahfauziah kBelum ada peringkat

- Pertemuan - Regresi Dan Korelasi Berganda (Manual SPSS)Dokumen45 halamanPertemuan - Regresi Dan Korelasi Berganda (Manual SPSS)asyaaa rlfBelum ada peringkat

- Analisa Regresi Dan Korelasi SederhanaDokumen5 halamanAnalisa Regresi Dan Korelasi SederhanaBryan PramanaBelum ada peringkat

- Materi 3 Regresi BergandaDokumen32 halamanMateri 3 Regresi BergandaValdZkyBelum ada peringkat

- Regresi LogistikDokumen7 halamanRegresi LogistikAny AyuningtyasBelum ada peringkat

- Pertemuan 4Dokumen15 halamanPertemuan 4Wirsa RinekoBelum ada peringkat

- Regresi GandaDokumen47 halamanRegresi GandaDeden IstiawanBelum ada peringkat

- Regresi Linier SederhanaDokumen14 halamanRegresi Linier SederhanaAdzay_nglBelum ada peringkat

- Ekonometrika 3b (Dummy Dan Ols)Dokumen38 halamanEkonometrika 3b (Dummy Dan Ols)Icha Mirza ElfSoneshawolBelum ada peringkat

- Ringkasan Bab 16 Regresi GandaDokumen17 halamanRingkasan Bab 16 Regresi Gandayose fani oktaviaBelum ada peringkat

- Modul Praktikum 5Dokumen11 halamanModul Praktikum 5I2I44OOI4 Rovida PratiwiBelum ada peringkat

- OLSDokumen34 halamanOLSQorri Novita SariBelum ada peringkat

- Multikolinieritas Regresi Ridge Data UpDokumen21 halamanMultikolinieritas Regresi Ridge Data UpAgus Shafrizal100% (1)

- Hijau Pastel Minimalis Tugas Kelompok PresentasiDokumen33 halamanHijau Pastel Minimalis Tugas Kelompok PresentasibbyblueBelum ada peringkat

- Analisis Bivariat Adalah Analisis Secara Simultan Dari Dua VariabelDokumen5 halamanAnalisis Bivariat Adalah Analisis Secara Simultan Dari Dua VariabelIlham YudiBelum ada peringkat

- Kisi-Kisi UAS EkonometrikaDokumen16 halamanKisi-Kisi UAS EkonometrikaHilmy ZIBelum ada peringkat

- BAB III Regresi SederhanaDokumen21 halamanBAB III Regresi SederhanaRohot Jeki ManurungBelum ada peringkat

- Jumriati - Regresi Linear BergandaDokumen6 halamanJumriati - Regresi Linear Bergandajumri atiBelum ada peringkat

- Tugas Statistika Pendidikan MatematikaDokumen7 halamanTugas Statistika Pendidikan MatematikaIgnasius GeraldiBelum ada peringkat

- P 7 Statistika 2 T.parulian Analisis Regresi SederhanaDokumen47 halamanP 7 Statistika 2 T.parulian Analisis Regresi SederhanaRisnalia RaellyBelum ada peringkat

- Bab 8 - Analisis Regresi SederhanaDokumen24 halamanBab 8 - Analisis Regresi SederhanaherranandaaaBelum ada peringkat

- ANALISISREGRESILINEARDokumen10 halamanANALISISREGRESILINEARBedran KerenBelum ada peringkat

- MULTIKOLINIERITAS - Materi EkonometrikaDokumen23 halamanMULTIKOLINIERITAS - Materi EkonometrikaLEONA YUSDA DINATABelum ada peringkat

- Analisis Regresi Dan KorelasiDokumen8 halamanAnalisis Regresi Dan KorelasiRizky AnugrahBelum ada peringkat

- Resume Video Youtube Analisis RegresiDokumen22 halamanResume Video Youtube Analisis RegresiAchmad FaisalBelum ada peringkat

- Cam PuranDokumen3 halamanCam PuranFithrotun NadiyahBelum ada peringkat

- Analisis RegresiDokumen31 halamanAnalisis Regresigus_motivation6947Belum ada peringkat

- Analisis Regresi Dan KorelasiDokumen9 halamanAnalisis Regresi Dan KorelasiDeliza SyaifhasBelum ada peringkat

- Sesi 4-6 Korelasi Dan RegresiDokumen40 halamanSesi 4-6 Korelasi Dan RegresiSalsabella Ramadhani MulyaBelum ada peringkat

- MODUL 5 Asumsi KlasikDokumen7 halamanMODUL 5 Asumsi KlasikYayu RachiBelum ada peringkat

- Regresi Dan Korelasi - Linier Sederhana 2Dokumen70 halamanRegresi Dan Korelasi - Linier Sederhana 2Amin Faisal AminBelum ada peringkat

- MAKALAH BIOS INFER MATERI 10 - Regresi LinierDokumen31 halamanMAKALAH BIOS INFER MATERI 10 - Regresi LinierAbidah Khoirun NisaBelum ada peringkat

- Analisis Bivariate PresentasiDokumen7 halamanAnalisis Bivariate PresentasiErRÿ Sîtï KhöêríähBelum ada peringkat

- I 5Dokumen1.042 halamanI 5AS1222Belum ada peringkat

- Aplikasi Persamaan Diferensial Pada Hukum Pendingin NewtonDokumen9 halamanAplikasi Persamaan Diferensial Pada Hukum Pendingin NewtonVe Kesma86% (7)

- PasswordDokumen662 halamanPasswordSorif KhanBelum ada peringkat

- Fisikadasartitis Blogspot Co IdDokumen10 halamanFisikadasartitis Blogspot Co IdAS1222Belum ada peringkat

- Teknik MGFDokumen28 halamanTeknik MGFAS1222Belum ada peringkat

- Kumpulan Soal Matematika Dan Ian Untuk SMA WWW Examsworld Us 2Dokumen325 halamanKumpulan Soal Matematika Dan Ian Untuk SMA WWW Examsworld Us 2AS1222Belum ada peringkat

- Fungsi Diskrit NumerikDokumen5 halamanFungsi Diskrit NumerikAS1222Belum ada peringkat

- 00 Halaman JudulDokumen8 halaman00 Halaman JudulAS1222Belum ada peringkat