MADG COMP6936036 MachineLearning-Answer

Diunggah oleh

adtomityoMADG COMP6936036 MachineLearning-Answer

Diunggah oleh

adtomityoCommon questions

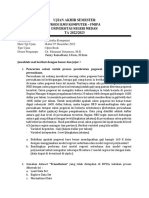

Didukung oleh AIIn a grid navigation scenario, the Multi-Armed Bandit problem is applied by treating each movement direction (up, down, left, right) as an arm. Actions are chosen to maximize the reward, defined as reaching the target location while avoiding obstacles. Through exploration using strategies like ε-greedy, the agent tries various paths and updates its movement policy based on the rewards received. Over multiple episodes, this method allows the agent to learn the most efficient paths to the goal .

When determining the number of clusters, factors include the business context and goals, customer demographics and data distribution, and techniques such as the Elbow Method, Silhouette Score, and Gap Statistic, all influencing the decision. These methods analyze patterns and data distributions to suggest an optimal number of segments that balance model complexity with clarity and utility, aligning analysis with practical business needs or hypotheses .

The curse of dimensionality arises as the number of dimensions increases, making measures of distance less meaningful because all points appear similarly distant. This affects algorithms relying on distance metrics, such as K-Means or KNN, rendering their outputs less reliable. As dimensions multiply, computational complexity and overfitting risk increase, complicating data analysis and model generalization. Reducing dimensions via techniques like PCA helps mitigate this issue by identifying dominant patterns .

Normalization standardizes the scale of data so that all features contribute equally to the model's performance. This is critical because algorithms like K-Means, PCA, SVM, and KNN are sensitive to the scale of features. If one feature, such as "RedMeat," has values significantly larger than another, like "Fish," the algorithm may infer undue importance to the former due to its larger scale, leading to biased and inaccurate model outputs. Normalizing features ensures a level playing field, resulting in a more accurate and representative model .

Clustering methods like K-Means can be employed to group countries with similar consumption patterns of items like "RedMeat" and "Fish." Dimensionality reduction techniques like PCA or t-SNE can help visualize these high-dimensional datasets, revealing underlying patterns or correlations. Association rule learning, though more common in transaction data, could also be adapted to find associations among consumption variables. These techniques allow for the identification of distinct consumption profiles and hidden trends within the dataset .

Decision tree classifiers create decision paths based on binary feature values, making them ideal for datasets with categorical variables. They split data using conditions derived from feature values to classify outcomes, such as determining if an animal is a mammal or fish based on attributes like "Hair" or "Feathers." Their ability to handle both categorical and numeric data without requiring normalization makes them especially suitable for datasets with these characteristics .

Clustering groups customers into segments with similar characteristics, allowing businesses to tailor marketing and services to specific needs and behaviors of each group. Methods like K-Means or DBSCAN identify these segments, and preprocessing steps like encoding categorical data and normalizing numerical ones ensure all features are equitably considered. Evaluating clustering results using metrics like Silhouette Scores provides insights into customer distribution, enhancing marketing strategies and customer satisfaction .

Preprocessing binary features by converting them to numerical values (e.g., True/False to 1/0) is crucial for logistic regression because the algorithm operates on numeric input. Additionally, while not mandatory, normalizing these features can improve the model's stability by preventing influence from disparate scales, contributing to more robust and accurate predictions tailored to binary classification tasks such as distinguishing between species types .

Gower Distance is specifically designed for mixed-type data, allowing for meaningful calculations across numerical and categorical variables, unlike Euclidean Distance, which is suitable only for purely numerical data. Gower's method standardizes numerical differences and assigns binary differences to categorical data, resulting in a comprehensive distance measure that captures more diversity in datasets with varied feature types, essential for mixed data clustering or analysis .

Data preparation for clustering involves several steps: handling missing values by imputing them with mean, median, or mode; normalizing numerical features to ensure equal weight in distance calculations; and encoding categorical data using techniques like label or one-hot encoding. These steps ensure that clustering algorithms can effectively compute similarities or distances between instances, leading to meaningful and interpretable groupings. Without these preprocessing steps, clustering might yield misleading results due to biased feature influences .