ID None

ID None

Diunggah oleh

brigittaatur0 penilaian0% menganggap dokumen ini bermanfaat (0 suara)

14 tayangan7 halamanJudul Asli

128636-ID-none

Hak Cipta

© © All Rights Reserved

Format Tersedia

PDF atau baca online dari Scribd

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

© All Rights Reserved

Format Tersedia

Unduh sebagai PDF atau baca online dari Scribd

0 penilaian0% menganggap dokumen ini bermanfaat (0 suara)

14 tayangan7 halamanID None

ID None

Diunggah oleh

brigittaaturHak Cipta:

© All Rights Reserved

Format Tersedia

Unduh sebagai PDF atau baca online dari Scribd

Anda di halaman 1dari 7

Jurnal Sainstek Vol. If No, 1: 87-93, Juni 2010

ISSN: 2085-8019

PROSES DECISION TREE PADA DATAMINING DENGAN

ALQORITMA ID3

Lita Sari Muchlis

Program Studi Manajemen Informatika STAIN Batusangkar

Jt Sudirman No. 137 Kuburajo Lima Kaum Batusangkar, Sumatera Barat 27213

Email: Litasarimuchlis@yahoo.com

ABSTRACT

‘This article was study about decision process data meaning with algoritma ID3.

Data meaning is an atomatic extraction process of large data. It was found with 4

contour data. Data meaning have a function to produce a different contour wich other

The function of classification of data meanin;

function with aigoritma ID3.

ig is helping write decision tree, the

Key words: data meaning, classification, decision tree

PENDAHULUAN

Suatu Aplikasi yang memudahkkan

dalam penyimpanan dan pengaksesan data

yang menyebabkan membengkaknya jumlah

data yang tersedia, Sudah banyak orang yang

menyadari bahwa data yang berukuran besar

tersebut scbenarnya _mengandung berbagai

Jenis pengetahuan tersembunyi yang berguna

luntuk proses pengambilan Keputusan, Akan

tetapi, pengetahuan akan sangat sulit di-

temukan dengan cara menganaiisis data secara

manual Oleh karena itu, dilakukan dara

‘mining untuk mengekstraksi pengetahuan

secara otomatis dari data berukuran_ besar

dengan cara mencari pola-pola menarik yang

terkandung di dalam data tersobut. Data

‘mining memiliki banyak fungsionalitas, antara

lain pembuatan ringkasan data, analisis

asosiasi antar data, Klasifikasi data, prediksi,

dan pengelompoken data. Setiap fung,

sionalitas akan menghasilkan pengetahuan

atau pola yang berbeda satu sama lain, Pada

Klasifikasi, akan dihasilkan sebuah mode!

yang dapat memprediksi Kelas atau kategori

dari objekobjek di dalam basisdsta, Sebagai

contoh, klasifikasi dapat digunakan oleh pe-

‘tugas peminjaman uang di sebuah bank untuk

‘memprediksi proses pengajuan Kredit oleh

nasabah (custumer) menjadi semakin mudah,

87

baik untuk kredit barang maupun uang

Pemohon mana yang aman dan mana yang be-

resiko untuk diberi pinjaman, oleh periset di

bidang medis untuk memprediksi jenis

pengebatan apa yang cocok diberikan kepada

seorang pasien dengan penyakit tertentu, Pada

kasus-kasus tersebut, model klasifikasi dibuat

untuk memprediksi kelas “aman” atau "be-

resiko” untuk. data permokonan pinjaman;

“deli” atau “tidak” untuk data pemasaran; dan

*pengobatan-1”, "pengobaian-2”, atau "peng-

obatan-3” untuk data medis. Model Klasifikasi

dibuat dengan cara menganalisis training data

(terdini dari objek-objek yang kelasnya sudah

diketahui). Mode! yang dihasilkan kemudian

akan digunakan untuk memprediksi kelas dari

unknown data (terditi dari objek-objek yang

Kelasnya belum ciketshui), Model Klasifikasi

dapat digambarkan dalam beberapa bentuk,

Seperti aturan klasifikasi (IF-THEN), pohon

kkeputusen, rumus maiematika, atau jaringan

saraftiruan. Fohon keputusan banyak

digunaken Karena mudah dipahami oleh

manusia serta mampu menangsni data

beratribut banyak.

Penggungan Model Pohon Keputusan

(Decision Tree) adalah salah satu teknik kla-

sifikasi sebagai bagian dari ilmu Data Mining,

Data Mining melakukan penggalian pe-

ngetahuan (knowledge) terhadap data. Untuk

Lita Sari Muchlis, Proses Decision ‘Tree Pada Datamining dengan Algoritma 1D3

tcknik Klasifikasi ini, digunakan algoritma

1D3 yang pertama Kali dikembangkan oleh

Ross Quinlan di Universitas Sydney pada

tahun 1975 dalam bukunya: Machine Lear-

ning, vol. 1, no. 1. ID3 is based off the

Concept Learning System (CLS) algorithm,

Kelebihan dari penggunaan model

Pohon Keputusan ini selain mudah dipakami

juga dapat dignnakan untuk menemukan atur-

fan atau syarat-syarat yang dapat dijadikan

sebagai kriteria yang berguna untuk kepertuan

analisa dalam satu proses pengambilan

keputusan.

‘Untuk membuat alat bantu Klasifikasi

dan identifikasi data dengan model Pohon Ke-

putusan menggunakan algoritma [D3 dan

mendapatkan basil yang optimal dengan

pemahaman akan teknik yang digunakan

tethadap model permasalahan yang dihadepi.

DECISION TREE MENGGUNAKAN

1D3

Pohon Keputusan (Decision Tree)

Decision Tree metupakan sustu

pendekatan yang sangat populer dan praktis

dan machine learning untuk menyelesaikan

permasalahan — Klasifikasi. Metode ini

digunakan untuk memperkirakan nilai diskrit

dari fungsi target. yang mana —fungsi

Yes,

Cinema,

Sunny

Play tennis

Richy

Shopping

pembelajaran direpresentasikan olch sebuah

decision tee. Decision Tree merupakan

himpunan aturan IF..THEN. Setiap path da-

lam tree dihubungkan dengan sebuah aturan,

dimana premis terdiri dari sckumpulan node-

node yang ditemui, dan kesimpulsn dari

aturan’ terdiri atas Kelas yang terhubung

dengan leaf dan parth

Dalam Pohon keputusan leafnodei

diberikan sebuah label Kelas. Non-terminal

node, yang terdiri atas root tas internalnocle

lainnya. Mengandung Kondisi-kondisi uji

atribut untuk memisahkan record yang

memiliki Karakteristik yang berbeda. Edge-

edge dapat dilabelkan dengan nilai-nilai

numeric symbolic, Sebvah atribut numertc-

symboilic adalah atribut yang dapat bernilai

numeric ataupun symbolic yang dihubungkan

dengan dengan sebuch variabel kuantitatif

Sebagai contoh, ukuran sescorang dapat

dituliskan “1,75 meter”, ataupun sebagai ni-

lai numeric-symbolic: seperti “tinggi” yang

berkaitan dengan suatu ukuran (size). Nilai se-

perti inilah yong menyetabkna perluasan dari

decesion tree

Pada sebuah pohon dapat digunakan

untuk memetakan pilihan keputusan. Pohon

yang memetakan pilihan-pilihan keputusan

tersebut dinamakan decision tree atau pohon

eputusan, Contoh bentuk dari pohon

Keputusan dapat dilihat pada gambar |

Parents

Visiting

No}

Weather

wo] a

meee Stayin

Poor

Cinema

Gambar |. Pohon Keputusan (Decision Tree)

88

Jumat Sainstek Vol, I No, 1: 87-93, Juni 2010

Pada Gambar 1 Pohon Keputusan dapat

dibaca sebagai berikut :

1, Jika orang tua berkunjung, kemudian

pergi ke bioskop

Jika orangtua tidak mengunjungi dan

cerah, kemudian bermain tenis

. Tika orangtua tidak mengunjungi dan

ini berangin dan kau kaya, kemudian

pergi berbelanja

. Jika orangtua tidak mengunjungi dan

ini berangin dan kau miskin, kemudian

pergi ke bioskop

. Jika orangtua tidak mengunjungi dan

hari hujan, maka tinggal masuk

Representasi_pohon berakar pada

pohon keputusan adalah sebagaiberikut:

+ Simpul dalam merepresentasikan

tesatribut

Daun merepresentasikan

Klosifikasi

2.

LEARNING POHON KEPUTUSAN

Menentukan Masalah

Bagaimana Pohon Keputusan meng-

identifikasi masalah? Kita mempunyai

sekumpulan contoh yang dikategorikan men-

jodi beberapa ketegori (keputusan-keputusan),

Kita juga mempunyai sekumpulan atribut

yang menjelastan contoh-contoh yang. ada,

dan setiap atrubut memiliki nilai yang ter-

hingga. Kita ingin menggunakan contch-

contoh yang ada untuk mempelajari.struktur

dari sebuah pohon keputusan yang dapat di-

gunakan untuk menentukan kategori dari

contoh yang belum ada (unseen example)

Ide dasar

Pada gambar |, simpul "parent visiting”

dilctakan paling atas (sebagai akar). Kita

belum tahu mengapa, sebagaimana kita tidak

tehu bagaimana proses pembuatan pahon

keputusan tersebut. Namun, jika orang tua

berkunjung, maka sudah pasti keputusannya

adalah pergi ke cinema. Oleh Karena itu,

pilinan parent visiting bisa ditaruh paling atas,

tanpa memperdulikan kemungkinan yang lain.

89

ISSN: 2085-2019

Pemikiran diatas yang mendasari algoritma

13,

Entropy

Membuat pohon keputusan adalah per-

kara memilih atribut mana yang harus diuji

pads setiap simpul pada Pohon untuk me-

nentukan ukuran dimana proses ini disebut

information gain, yang berguna untuk me-

nentukan atribut mana yang akan digunakan

pada setiap simpul. Information Gain itu

sendiri didapatkan dari perhitungan yang

menggunakan satuan yang disebut entropy.

Merdefenisikan kasus pada keputusan biner

dan kemudian/ menentukan asus umum.

‘Rumus Entropy adalah

Entropy (8) = ae Plog , p,

€ :jumlah nilai yang ada pada atribut target

Gumlah kelas klasifikasi),

, : porsi sampel untuk kelas /

Information Gain

Informatin Gain adalah sustu nilai sta-

tistik yang digunakan untuk remilih atribut

yang akan mengekspansi ree dan ‘meng-

hasilkan node bars pada algoritme 1D3. suatu

entropy dipergunakan untuk mendefenisikan

nilai information gain

Entropy digunakan sebagai parameter

untuk mengukur heterogenitas (keberagaman)

dari kumpulan sampet data dan Jika kumpulan

sempel data semakin heterogen, maka nilai

entropynya semakin besar. Information Gain

(2G) dimanfaatkan sobagai Efektivitas atribut

dalam mengklasifikasikan data Dihitung ber-

dasarkan entropy dengan ketentuan rumus

sebagai berikut:

Gai, A)= Entrops(S) -

A = atribut

v menyatakan suatu

nila yang mungkin untuk aribut A

Values (A) himpunan nilai-nilai

yang mungkin untuk atribut 4

Il : jumlah sampel untuk

nila y

Lita Sari Muchlis, Proses Decision Tree Pada Datamining dengan Algoritma 1D3,

5 jumlah — seluruh

sampel data

* Entropy(S,) : entropy untuk

sampel-sampel yang memilikj nilai v

Sebagai contoh, misalnya kita memiliki

sekumpulan contoh $ = {s1,s2,s3,s4} yang di

kategorikan menjadi positif dan “neg:

dimana 1 positif dan sisanya negative. Kita

ingin menghitung information gain dari

sebuah atribut A, dan A dapat memiliki nilai

2 memiliki nilai v2 untuk A

3 memiliki nilai v3 untuk A

s4 memiliki nilai v1 untuk A

Untuk mendapatkan information gain,

pertama kita harus menghitung entropy dari S.

‘Untuk menggunakan persamaan entropi pada

persoalan ini, kita harus mengetahui jumlah

positif dan negatify pada S. Dari soal dapat

diketahui bahwa positif = 1/4 dan negative =

3/4, sehingga kita bisa menghitung :

Entropy(S) = - (1/4)log2(1/4) — (3/4)log2(3/4)

(/4)(-2) — (8/4)(-0,415) = 0,5 + 0311 =

Oil

Selanjutnya kita periu menghitung

Entropi(Sv) untuk setiap nilai v= vi, v2, v3,

v4. Sv merupakan kumpulan dari contoh pada

S yang memiliki nilai v pada atribut A, atau

dapat ditulisakan sebagai berikut:

Sul = {s4}, sv2=(sl, 52}, sv3 = {53}

Sekarang, kita dapat menyelesaikan persama-

an-persamaan berikut:

{Sv IAS) * Entropy(Sv1) = (1/4) *

(O/1}log2/1) - (V/Jhog2C1/1))

(I/AY-0 ~(1)!082(1)) = (1/4)(-0 -0) = 0

(Sv2{S)) * Entropy(Sv2) = (2/4) * (-

(12)l0g2(12) - (1/2)log2(1/2))=

(12) * (2)%C1) - Q2)*C1) =

(2) *()=12

(Sv3}/|S)) * Entropy(Sv3) ~ (1/4) * (-

(O/1ylog2(0/1) - (1/1)tog2(1/1))

(1/AY(-0 -(1}log2(1)) = (1/4)(-0 -0) = 0

Sekarang kita bisa menambahkan

ketiga nilai tersebut dan mendapatkan hasil

dari perhitungan Entropi(S) yang merupakan

Informasi diperoleh melalui percabangen pada

atribut A:

Gain(S,A) = 0.811 -(0 + 1/2 +0)=0311

Informasi _ selanjuntnya

untuk menggunakan Alq

‘membengun Pokon keputusan

digonakan

ALGORITMA ID3

Konsep dasar Algoritma 1D3

Perhitungan untuk mendapat informasi

adalah bagian sulit dari algoriima. Algoritma

13 melakukan pencarian dengan meng-

gunakan Pohon Keputusan dan melibatkan

penambah simpul ke pohon yang ada. Fungsi

dari Algoritma.ID3 adalah sebagai berikut :

© Sebuah algoritma matematike untuk

‘membangun pohon keputusan,

+ Diciptakan oleh Ross Quinlan J. pada

tahun 1979.

Teori Informasi Menggunakan ditemukan

oleh Shannon pada tahun 1948.

Membangun pohon dari atas ke bawah,

‘dengan tidak mundur.

Informasi Keuntungan digunakan_ untuk

memilih atribut yang paling bergune untuk

Masifikasi

Algoritma —1D3

get_Attribute, Attributes)

sebagai berikut ID3

(Contoh, —Tar-

dapat dituliskan

Buat node root untuk pohon

+ HIKA semua contoh positif, Kembali

tunggal Root node pohon itu-, dengan label

=+

Jika semua contoh negatif, Kembali

tunggal Root node pohon itu-, dengan label

Jika jumlah memprediksi alribut kosong,

maka Kembali node tunggal Root pohon,

dengan label = nilai umum sebagian besar

stribut target pada contoh

Jika tidsk Mulaitah

o J 3 The Atribut yang paling

‘mengklasifikasikan contoh

Keputasan atribut Pohon untuk Root

A

Untuk setiap nilai positif, vi, A,

* Fembah pohon cabang baru di bawah

Root, sesuai dengan Tes

90

Jumal Sainstek Vol. II No. 1: 87-93, Juni 2010 ISSN: 2085-8019

* Contoh Biarkan

3. Untuk setiap cabang dari A yang ber

dari contoh yang memiliki_ nilai korespondensi dengan nilai y, hitung Sv.

untuk A vi + Jika Sy kosong, pilih kategori cdefault

+ Jika contoh (vi) Kosong yang mempunyai paling banyak contoh

+ Kemudian di bawah ini cabang baru pada 8, dan letakan pada simpul daun

menambahkan simpul daun dengan yang mengakhiri cabang tersebut

label = paling nilei umum target Jika Sv hanya mengandung contoh dari

peda conioh kategori c, maka letakan c sebagai

* Lain di bawah ini cabang baru impul daun yang mengakhiri cabang

menambehkan —ID3_—_subpohon tersebut

(Contoh (vi), Target_Attribute, * Sclain itu, hilangkan A dari kumpulan

Atribut -(A)) atribut yang bisa diletaken pada simpul.

+ Akhir Lalu, letaken simpul baru pada decision

« Kembali Root free, dimana atribut baru yang diletakan

Dari Algoritma diatas maka dapat kita adalah atribut yang memiliki

misallkan, diberikan sekumpulan contoh S, information gain terbesar terhadap Sv.

dikategorikan dalam sekumpulan kategori ci, Ulangi Jangkah diatas dengan

maka: mengganti $ dengan Sv

1, Tentukan simpul akar yang merupakan Algoritma di atas berhenti jika atribut su-

awibut A yang memiliki nilai information dah habis, atau decision tree sudah meng.

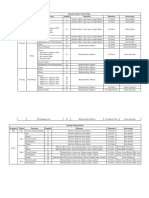

gain terbesar pada S klasifikasi contoh dengan sempurna. Ilustrasi

2 Untuk sctiap nilai v yang munghin dimiliki dari algoritma ID3 dapat d

A, gambarkan cabeng untuk simpul ter- ,

sebut

Airbuie®

Ecorse highest -fo

‘oraarea) s

eat rode:

Lor eallegary ©

Se mast

Only examples in +

category ¢ Ete,

petut

leat pede d

Sw must nave ne

exumples taking va

Gy alinbule Band d

inst be the category

ontainiry te mast

inemnbors ol Sy

Gambar 2, Ilustrasi dati algoritma [D3

1

Lita Sari Muchlis, Proses Decision Tree Pada Datamining dengan Algoritma ID3

Pemangkasan Pohon

Pada saat pembangunan pohon ke-

putusan, banyaknya cabang — mungkin

mencerminkan adanya noise pada training

data, Pemangkasan pohon dapat dilakukan

untuk mengenali dan menghapus caban

cabang tersebut. Pohon yang dipangkas al

menjadi lebih kecil dan lebih mudah di

pahami, Pohon semacam itu biasanya juga

menjadi lebih cepat dan lebih baik dalam

melakukan klasifikesi terhadap unknown data,

Melakukan proses Klasisfikasi deta disimpan

pada database dengan langkah pengerjaan yai-

tu membangun Pohon Keputusan dan me-

nyederhanaan ~ keputusan dalam — bentuk

pemangkasan dengan pendekatan Pruning

Desicion Tree (Gambar 3).

Garbar 3. Pohon keputusan sebelum dan setelah dipangkas

Proses Kerja Prunning Desicion Tree

dalam sebuah pohon keputusan jika sebuah

rule telah dibuat berdasarkan "pohon ke-

patusan, maka prosesnye sebagai berikut:

1, Eliminasi anteseden yang tidak perly, cara

4. Buat tabel kontigensi untuk setiap rule

yang mempunyai anteseden

b. Sederhanakan rule dengan

‘mengeliminasi anteseden

2, Eliminesi rule yang tidak perlu

cara

KESIMPULAN

Teknologi data mining dengan meng-

gunakan pemodelan Pohon Keputusan dapat

digunekan untuk melakukan Klasifikasi data

Dan hsil deri klasifikasi yang didapatkan

dengan menggunakan alat bantu ini adalah

92

dengan ditemukannnya aturan-aturan yang da-

pat digunakan sebagai kriteria-kriteria untuk

mengidentifikasi dan mengetahul apakah sua-

tw tindakan atau kegiatan harus dilakukan atau

tidak.

Pohon Keputusan dengan Algoritma

1D3 dapat digunakan untuk memperoleh pe~

ngetahuan tentang pengolahan data dalam

jumiah yang besar khususnya untuk meng-

klasifikasikan pemberian data pada pengambil

keputusen

Pemangkasan pohon dapat dilakukan

untuk menghilangkan catang-cabang_ tidak

perlu yang terbentuk akibat adanya noise atau

outlier pada training data.

Jumal Sainstek Vol. II No. 1: 87-93, Juni 2010 ISSN: 2085-8019

DAFTAR KEPUSTAKAAN Prayudi Y. 2002. Knowledge Discovery In

Medical Data, Singapore. McGraw-Hill

Blake CL, Merz CJ. 1998. UCI Repository of Tom MM, 1997, Machine Learning.

machine learning databases. frvine, CA: ‘Singapore. McGraw-Hill

University of California, Department of Russel N. 2003. Artificial Inteligence — a

Information and Computer Science. Modern Approach 2nd Edition. Pearson

Munir R. 2006. Diktat Kuliah 1F2133 Education Ine, New Jersey

Matematika Diskrit. Program Studi

Teknik Informatike, Institut Teknologi

Bandung

3

Anda mungkin juga menyukai

- Hari H Dadp KonsumsiDokumen8 halamanHari H Dadp KonsumsibrigittaaturBelum ada peringkat

- Teks Lagu NatalDokumen6 halamanTeks Lagu NatalbrigittaaturBelum ada peringkat

- Masalah Tata Letak Fasilitas Logistik Dengan Menggunakan Fuzzy Dynamic Analitycal Hierarchy Process (Fdahp)Dokumen11 halamanMasalah Tata Letak Fasilitas Logistik Dengan Menggunakan Fuzzy Dynamic Analitycal Hierarchy Process (Fdahp)brigittaaturBelum ada peringkat

- Dokumen Ditandatangani Secara Elektronik Menggunakan Sertifikat Elektronik Yang Diterbitkan Oleh BsreDokumen2 halamanDokumen Ditandatangani Secara Elektronik Menggunakan Sertifikat Elektronik Yang Diterbitkan Oleh BsrebrigittaaturBelum ada peringkat

- Teks Lagu 3Dokumen4 halamanTeks Lagu 3brigittaaturBelum ada peringkat

- Capstone DesainDokumen1 halamanCapstone DesainbrigittaaturBelum ada peringkat

- Dadp Opsi 1Dokumen4 halamanDadp Opsi 1brigittaaturBelum ada peringkat

- PDF Pemodelan Sistem Soaldocx - CompressDokumen4 halamanPDF Pemodelan Sistem Soaldocx - CompressbrigittaaturBelum ada peringkat

- 1020 2625 3 PBDokumen6 halaman1020 2625 3 PBbrigittaaturBelum ada peringkat

- 3.10 4.1 4.3 Pti4 Modul1Dokumen4 halaman3.10 4.1 4.3 Pti4 Modul1brigittaaturBelum ada peringkat

- 2274 6413 1 PBDokumen8 halaman2274 6413 1 PBbrigittaaturBelum ada peringkat

- Data Mining Entropy Desicion TreeDokumen6 halamanData Mining Entropy Desicion TreebrigittaaturBelum ada peringkat

- 1829 3216 1 SMDokumen24 halaman1829 3216 1 SMbrigittaaturBelum ada peringkat

- JurnalDokumen6 halamanJurnalbrigittaaturBelum ada peringkat

- Praktikum Optimisasi - Modul 4 - Kelompok 7Dokumen60 halamanPraktikum Optimisasi - Modul 4 - Kelompok 7brigittaaturBelum ada peringkat

- 158 251 1 SMDokumen6 halaman158 251 1 SMbrigittaaturBelum ada peringkat

- SituasiDokumen3 halamanSituasibrigittaaturBelum ada peringkat

- Week 5 - Control ChartDokumen56 halamanWeek 5 - Control ChartbrigittaaturBelum ada peringkat

- Praktikum Optimisasi - Modul 2 - Kelompok 7Dokumen53 halamanPraktikum Optimisasi - Modul 2 - Kelompok 7brigittaaturBelum ada peringkat

- Ujian Tengah Semester Keselamatan Dan Kesehatan Kerja: (Rabu, 06 Oktober 2021)Dokumen4 halamanUjian Tengah Semester Keselamatan Dan Kesehatan Kerja: (Rabu, 06 Oktober 2021)brigittaaturBelum ada peringkat

- Praktikum Optimisasi - Modul 4 - Kelompok 7Dokumen58 halamanPraktikum Optimisasi - Modul 4 - Kelompok 7brigittaaturBelum ada peringkat

- Contoh SURAT LAMARANDokumen1 halamanContoh SURAT LAMARANbrigittaaturBelum ada peringkat

- 3.2-3.2.3 Modul 2 OptimisasiDokumen23 halaman3.2-3.2.3 Modul 2 OptimisasibrigittaaturBelum ada peringkat

- 4.2.4 Pengumpulan Data Outlier: Tabel Data Outlier Antropometri Pria No Nama Suku Bangsa TDT TDN TBD TMD TSDDokumen34 halaman4.2.4 Pengumpulan Data Outlier: Tabel Data Outlier Antropometri Pria No Nama Suku Bangsa TDT TDN TBD TMD TSDbrigittaaturBelum ada peringkat

- Praktikum Optimisasi - Modul 2 - Kelompok 7Dokumen32 halamanPraktikum Optimisasi - Modul 2 - Kelompok 7brigittaaturBelum ada peringkat

- P10 - PPM - Win QSB Peta Kendali Variabel (12 April 2021)Dokumen4 halamanP10 - PPM - Win QSB Peta Kendali Variabel (12 April 2021)brigittaaturBelum ada peringkat

- LPJ 2019Dokumen8 halamanLPJ 2019brigittaaturBelum ada peringkat

- Laporan Modul 2 Perancangan Dan Pengembangan ProdukDokumen34 halamanLaporan Modul 2 Perancangan Dan Pengembangan Produkbrigittaatur100% (2)

- 5.3 Analisa Perhitungan Persentil: Praktikum Perancangan Sistem Kerja Ergonomi Modul 1 Antropometri Kelompok 1Dokumen4 halaman5.3 Analisa Perhitungan Persentil: Praktikum Perancangan Sistem Kerja Ergonomi Modul 1 Antropometri Kelompok 1brigittaaturBelum ada peringkat

- Laporan Praktikum Perancangan Sistem Kerja Ergonomi (TIN - 2261)Dokumen50 halamanLaporan Praktikum Perancangan Sistem Kerja Ergonomi (TIN - 2261)brigittaaturBelum ada peringkat