Decision Tree

Decision Tree

Diunggah oleh

Yaoming BachtiarHak Cipta

Format Tersedia

Bagikan dokumen Ini

Apakah menurut Anda dokumen ini bermanfaat?

Apakah konten ini tidak pantas?

Laporkan Dokumen IniHak Cipta:

Format Tersedia

Decision Tree

Decision Tree

Diunggah oleh

Yaoming BachtiarHak Cipta:

Format Tersedia

2.1 Decision Tree ( C 4.

5 )

Salah satu algoritme induksi pohon keputusan yaitu ID3 (Iterative Dichotomiser 3)

yang dikembangkan oleh J. Ross Quinlan [50]. Prosedur algoritma ID3, input berupa sampel

training, label training dan atribut. Algoritme C4.5 merupakan pengembangan dari ID3.

Sedangkan pada perangkat lunak open source WEKA dikenal sebagai J48.

Pohon dibangun dengan cara membagi data secara rekursif hingga tiap bagian terdiri

dari data yang berasal dari kelas yang sama. Bentuk pemecahan (split) yang digunakan untuk

membagi data tergantung dari jenis atribut yang digunakan dalam split. Algoritme C4.5 dapat

menangani data numerik/kontinyu dan diskret. Split untuk atribut numerik yaitu mengurutkan

contoh berdasarkan atribut kontiyu A, kemudian membentuk minimum permulaan (threshold)

M dari contoh-contoh yang ada dari kelas mayoritas pada setiap partisi yang bersebelahan, lalu

menggabungkan partisi-partisi yang bersebelahan tersebut dengan kelas mayoritas yang sama.

Split untuk atribut diskret A mempunyai bentuk value (A) ε X dimana X ⊂ domain(A).

Jika suatu set data mempunyai beberapa pengamatan dengan missing values yaitu record

dengan beberapa nilai variabel tidak ada, jika jumlah pengamatan terbatas maka atribut dengan

missing values dapat diganti dengan nilai rata-rata dari variabel yang bersangkutan [50].

Pemisahan obyek (split) dilakukan tes terhadap atribut dengan mengukur tingkat

ketidakmurnian pada sebuah simpul (node).

Pada algoritma C.45 menggunakan rasio perolehan (gain ratio). Sebelum menghitung

rasio perolehan, perlu menghitung dulu nilai informasi dalam satuan bit dari suatu kumpulan

objek. Cara menghitungnya dilakukan dengan menggunakan konsep entropi. Berikut ini contoh

kasus proses penghitungan secara matematis pada algoritme C 4.5 dapat dilihat pada Tabel 2.1.

Tabel 2.1 Keputusan Bermain Tenis

No Outlook Temperature Humidity Windy Play

1 Sunny Hot High False No

2 Sunny Hot High True No

3 Cloudy Hot High False Yes

4 Rainy Mild High False Yes

5 Rainy Cool Normal False Yes

6 Rainy Cool Normal True Yes

7 Cloudy Cool Normal True Yes

8 Sunny Mild High False No

9 Sunny Cool Normal False Yes

10 Rainy Mild Normal False Yes

11 Sunny Mild Normal True Yes

12 Cloudy Mild High True Yes

13 Cloudy Hot Normal False Yes

14 Rainy Mild High True No

Kasus pada Tabel 2.1 akan dibuat pohon keputusan untuk menentukan akan bermain

tenis atau tidak dengan kriteria berdasarkan outlook, temperature, humidity dan windy.

Cara kerja algoritme C4.5 dalam membangun pohon keputusan secara umum

menggunakan langkah berikut ini [53].

1. Pilih atribut sebagai akar.

2. Membuat cabang untuk tiap-tiap nilai.

3. Membagi kasus dalam cabang

4. Mengulangi proses untuk setiap cabang sampai semua kasus pada cabang memiliki kelas

yang sama.

Pemilihan atribut sebagai akar didasarkan pada nilai gain tertinggi dari atribut-atribut

yang ada. Perhitungan gain mengikuti Persamaan 2-7 sebagai berikut.

GainS , A Entropy( S )

n | Si |

* Entropy( Si) (2 - 7)

i 1 | S |

Keterangan:

S = Himpunan kasus

A = Atribut

n = Jumlah partisi atribut A

|Si| = jumlah kasus pada partisi ke-i

|S| = Jumlah kasus dalam S

Perhitungan nilai entropi mengikuti Persamaan 2-8 berikut ini.

n

EntropyS Entropy( S ) pi * log 2 ( pi ) (2 - 8)

i 1

Keterangan:

S = Himpunan kasus

n = Jumlah partisi atribut A

pi = Proporsi dari Si terhadap S

Penyelesaian untuk permasalahan pada Tabel 2.1 dapat diuraikan sebagai berikut.

a. Menghitung jumlah kasus untuk keputusan yes dan keputusan no dan menghitung entropi

dari tiap kasus yang dibagi berdasarkan atribut outlook ,temperature, humidity, windy.

Selanjutnya dilakukan perhitungan gain. Jika perbandingan dua kelas, rasionya sama

maka entropi bernilai 1 dan jika satu set hanya terdiri dari satu kelas maka entropi bernilai

0.

Perhitungan entropi total :

Entropi (total) = (- 4/14 * log2(4/14)) + (-10/4 * log2(10/14))

= 0,863 bits

Perhitungan entropi dan gain atribut outlook

Entropi atribut outlook = rainy

Entropi [1,4] = -1/5 log2(1/5) + (– 4/5 log2(4/5)) = 0,721 bits.

Entropi atribut outlook = sunny

Entropi [3,2] = -3/5 log2(3/5) + (- 2/5 log2(2/5)) = 0,971 bits.

Entropi atribut outlook = cloudy

Entropi [0,1] = - 0 log2(0) + (– 1 log2(1)) = 0 bits.

Entropi total atribut outlook

= entropi ([1,4]; [3,2]; [0,4])

= (((5/14)*0,721) + ((5/14)*0,971) + ((4/14)*0) = 0,604 bits.

Gain atribut outlook

n

| Outlook i |

GainTotal, outlook Entropy(total) * Entropy(outlook i ) Gain

i 1 | total |

atribut outlook

= 0,863 -0,604 = 0,259 bits

Proses perhitungan diatas juga diterapkan untuk atribut temperature, humidity, dan

windy. Secara lengkap hasil untuk proses split pada node 1 tampak pada Tabel 2.2 untuk

dibandingkan nilai gain untuk penentuan node akar.

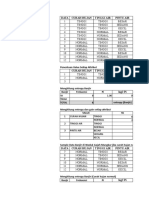

Tabel 2.2 Perhitungan node 1

Jumlah kasus Tidak Ya

Node Entropi Gain

(S) (S1) (S2)

1 Total 14 4 10 0,863121

Outlook 0,258521

Cloudy 4 0 4 0

Rainy 5 1 4 0,721928

Sunny 5 3 2 0,970951

Temperature 0,183851

Cool 4 0 4 0

Hot 4 2 2 1

Mild 6 2 4 0,918296

Humidity 0,370507

High 7 4 3 0,985228

Normal 7 0 7 0

Windy 0,005978

FALSE 8 2 6 0,811278

TRUE 6 2 4 0,918296

Berdasarkan hasil perhitungan yang tampak pada Tabel 2.2 untuk node 1 diketahui

bahwa atribut dengan gain tertinggi adalah humidity, sehingga atribut ini akan menjadi node

akar. Atribut humidity memiliki dua nilai yaitu high dan normal. Pada nilai normal telah

mengklasifikasikannya menjadi 1 yaitu keputusan yes sehingga tidak perlu dilakukan

perhitungan lagi, sementara untuk atribut humidity bernilai high perlu dilakukan perhitungan

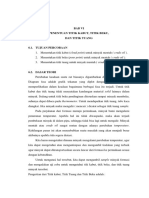

pada tahap selanjutnya. Hasil perhitungan pada node 1 dapat digambarkan pohon keputusan

sementara seperti Gambar 2.1 berikut ini.

1

1

High Normal

1 Ye

s

Gambar 2.1 Pohon keputusan hasil perhitungan node 1

Anda mungkin juga menyukai

- Modul 3 Excel TerapanDokumen7 halamanModul 3 Excel Terapannabilla baliniBelum ada peringkat

- Algoritma C.45Dokumen41 halamanAlgoritma C.45Farhan AuliaBelum ada peringkat

- ALGORITMA C4.5 (Chek Again Dude)Dokumen21 halamanALGORITMA C4.5 (Chek Again Dude)arisnurba100% (1)

- DATA MINING Materi 2Dokumen6 halamanDATA MINING Materi 2FlamboyanBelum ada peringkat

- Algoritma ID3Dokumen9 halamanAlgoritma ID3MADANI PELITA TVBelum ada peringkat

- Data Mining-III 2019-1Dokumen33 halamanData Mining-III 2019-1Parman Dogless TangerangBelum ada peringkat

- Amelia Winursetia - 3KA25 - 17119138 - TugasM7 - DataMiningDokumen5 halamanAmelia Winursetia - 3KA25 - 17119138 - TugasM7 - DataMiningAmelia WinursetiaBelum ada peringkat

- Pertemuan 7 Part 2Dokumen51 halamanPertemuan 7 Part 2Fransisca NataliaBelum ada peringkat

- Klasifikasi. Data MiningDokumen67 halamanKlasifikasi. Data MiningAwi 29Belum ada peringkat

- Metode Klasifikasi Algoritma.C45: Pertemuan Ke-6 (SI-RM53) 10-12-2020Dokumen28 halamanMetode Klasifikasi Algoritma.C45: Pertemuan Ke-6 (SI-RM53) 10-12-2020medy manzoomBelum ada peringkat

- Nama: Afifah Kurnia Lestari NPM: 2013030050 Prodi: SI/3BDokumen12 halamanNama: Afifah Kurnia Lestari NPM: 2013030050 Prodi: SI/3BDestria Septy Dara FpgBelum ada peringkat

- Agoritma c4.5Dokumen21 halamanAgoritma c4.5habibBelum ada peringkat

- Pertemuan 12.1 - Decision TreeDokumen34 halamanPertemuan 12.1 - Decision Treefadhilah dirayatiBelum ada peringkat

- Algoritma C4.5 - Nor Hafiz - TI 6B PDFDokumen15 halamanAlgoritma C4.5 - Nor Hafiz - TI 6B PDFnur hafizBelum ada peringkat

- Tugas 4 Data MiningDokumen36 halamanTugas 4 Data MiningGufran Ghozian RizkyBelum ada peringkat

- Contoh Perhitungan C4.5Dokumen8 halamanContoh Perhitungan C4.5muhammad rizky irnandaBelum ada peringkat

- REKTIFIKASIDokumen15 halamanREKTIFIKASIVania ParamithaBelum ada peringkat

- Tugas Algoritma ID3Dokumen16 halamanTugas Algoritma ID3Riyan SanjayaBelum ada peringkat

- Laporan Pola Decision TreeDokumen13 halamanLaporan Pola Decision TreeTacha100% (1)

- Tugas 18101152630092 Edo-Sulaiman Quiz IF-1Dokumen6 halamanTugas 18101152630092 Edo-Sulaiman Quiz IF-1Youtube PremiumBelum ada peringkat

- Algoritma ID3Dokumen18 halamanAlgoritma ID3Yoshua BryantBelum ada peringkat

- Sistem Cerdas Pertemuan XiiDokumen15 halamanSistem Cerdas Pertemuan XiiVañ LyubovBelum ada peringkat

- Tugas 6Dokumen232 halamanTugas 6Mimi JumiatiBelum ada peringkat

- REKTIFIKASIDokumen16 halamanREKTIFIKASIAde Thalia SyalsabillaBelum ada peringkat

- MATEMATIKA KEUANGAN FIX FixDokumen9 halamanMATEMATIKA KEUANGAN FIX FixPutra PradinataBelum ada peringkat

- 02 - Decision TreeDokumen39 halaman02 - Decision TreeAvin Unggul Wijaya XI-MIPA-2Belum ada peringkat

- Excel KlasifikasiDokumen8 halamanExcel KlasifikasiSista Anindya AisyahBelum ada peringkat

- (1821600007) Muhammad Riyan Ulil Albab - Decission TreeDokumen2 halaman(1821600007) Muhammad Riyan Ulil Albab - Decission TreeDimas RichoBelum ada peringkat

- Hincasting WordDokumen2 halamanHincasting WordWaskito DwiwicaksoputroBelum ada peringkat

- JWGP Intro To ML Chap6 SecuredDokumen8 halamanJWGP Intro To ML Chap6 SecuredAl HaisBelum ada peringkat

- Perbandingan Pengukuran Suhu Dan Kelembapan Menggunakan Data Logger Dan Humidity DigitalDokumen47 halamanPerbandingan Pengukuran Suhu Dan Kelembapan Menggunakan Data Logger Dan Humidity Digitalsartono indo fransBelum ada peringkat

- Kelompok 1A20 - Probabilitas GenetikaDokumen8 halamanKelompok 1A20 - Probabilitas GenetikaSalma NuraniBelum ada peringkat

- Perhitungan Klasifikasi Algoritma c45 - MahasiswaDokumen12 halamanPerhitungan Klasifikasi Algoritma c45 - MahasiswaEdyz Cah AndesgoBelum ada peringkat

- 6-Naive Bayes (Klasifikasi)Dokumen23 halaman6-Naive Bayes (Klasifikasi)sabrina waelBelum ada peringkat

- Annisaa Nurqomariah-Assg2Dokumen8 halamanAnnisaa Nurqomariah-Assg2Ninis NurqomariahBelum ada peringkat

- LAPTAP Fasa KesetimbanganDokumen16 halamanLAPTAP Fasa KesetimbangananastasyaBelum ada peringkat

- Laporan Praktikum Elektronika Lanjut TermometerDokumen13 halamanLaporan Praktikum Elektronika Lanjut TermometerHera OktavianiBelum ada peringkat

- Laporan Tetap Fasa KesetimbanganDokumen14 halamanLaporan Tetap Fasa KesetimbanganRpaaniBelum ada peringkat

- Contoh Perhitungan C4.5Dokumen7 halamanContoh Perhitungan C4.5Yana TriBelum ada peringkat

- Laporan 12Dokumen3 halamanLaporan 12Julius GunawanBelum ada peringkat

- 1 PBDokumen4 halaman1 PBNadia AdiningsihBelum ada peringkat

- Bab ViDokumen12 halamanBab ViHasna AfifBelum ada peringkat

- Dominick Davian - Petunjuk Teknis Praktikum Fisika 2020-2021Dokumen13 halamanDominick Davian - Petunjuk Teknis Praktikum Fisika 2020-2021Dominick DavianBelum ada peringkat

- Indeks Bias Jurnal ClearinDokumen7 halamanIndeks Bias Jurnal ClearinAyulita SofyanBelum ada peringkat

- LA - ANP5 - Rutherford Scattering - Ahmad Basyir NajwanDokumen8 halamanLA - ANP5 - Rutherford Scattering - Ahmad Basyir NajwanFisika dalam Kehidupan Olimpiade FisikaBelum ada peringkat

- Tugas Mandiri 2Dokumen8 halamanTugas Mandiri 22113034 TANRI ABENGBelum ada peringkat

- Lapres Modul 3 Excel TerapanDokumen9 halamanLapres Modul 3 Excel TerapanThobroni AkbarBelum ada peringkat

- Laporan 13Dokumen3 halamanLaporan 13Julius GunawanBelum ada peringkat

- Pemrograman Pascal Dan Aplikasi MatlabDokumen15 halamanPemrograman Pascal Dan Aplikasi MatlabAriza NovriandiniBelum ada peringkat

- Latihan 1 StatistikaDokumen9 halamanLatihan 1 Statistikashiva noviar auliaBelum ada peringkat

- Contoh Laporan ProjectDokumen9 halamanContoh Laporan Projectmiko prasojo djupri subarnoBelum ada peringkat

- Tugas 1 - C4.5 - Zulfahmi Ramadhani PDFDokumen7 halamanTugas 1 - C4.5 - Zulfahmi Ramadhani PDFAllen BakerBelum ada peringkat

- Kalibrasi Termometer DigitalDokumen7 halamanKalibrasi Termometer DigitalDian LesmanaBelum ada peringkat

- Laporan Praktikum Animasi LedDokumen8 halamanLaporan Praktikum Animasi LedQonita Falih ReswaraBelum ada peringkat

- Laporan Sementara DistilasiDokumen24 halamanLaporan Sementara Distilasiniko febrianBelum ada peringkat

- Analisa Kebutuhan Unit Gawat DaruratDokumen7 halamanAnalisa Kebutuhan Unit Gawat Daruratsatria putra nugrahaBelum ada peringkat

- Tugas Uas FuzzyDokumen14 halamanTugas Uas FuzzyMUHAMMAD NUR HAKIIMBelum ada peringkat

- PCD1Dokumen16 halamanPCD1Nur ImansyahBelum ada peringkat

- Kontrak PerkuliahanDokumen3 halamanKontrak PerkuliahanNur ImansyahBelum ada peringkat

- LAOD MAP OpenStreet Menggunakan Leaftlet Dan MapboxDokumen3 halamanLAOD MAP OpenStreet Menggunakan Leaftlet Dan MapboxNur ImansyahBelum ada peringkat

- Template Soal UASDokumen1 halamanTemplate Soal UASNur ImansyahBelum ada peringkat